Das französische, unabhängige und gemeinnützige KI-Forschungslabor Kyutai hat Moshi veröffentlicht, einen revolutionären, echtzeitfähigen, nativen multimodalen Basismodell-Sprachassistenten. Dieses innovative Modell imitiert und übertrifft in einigen Funktionen die im Mai von OpenAI vorgestellten Fähigkeiten von GPT-4o.

Produktzugang:https://top.aibase.com/tool/moshi-chat

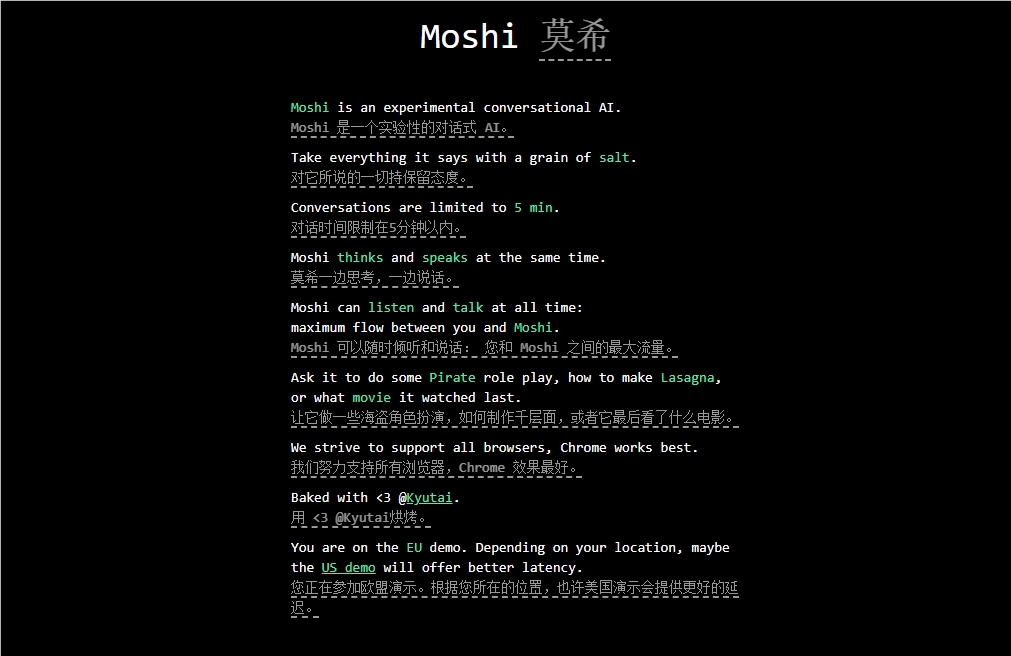

Moshi ist darauf ausgelegt, Emotionen zu verstehen und auszudrücken und kann in verschiedenen Akzenten (einschließlich Französisch) konversationieren. Es kann gleichzeitig Audio und Sprache hören und erzeugen und dabei einen flüssigen Textfluss aufrechterhalten. Moshi soll über eine Vielzahl menschenähnlicher Emotionen verfügen und kann mit 70 verschiedenen Emotionen und Stilen sprechen.

Ein herausragendes Merkmal von Moshi ist die gleichzeitige Verarbeitung zweier Audioströme, wodurch es gleichzeitig hören und sprechen kann. Diese Echtzeitinteraktion basiert auf einem gemeinsamen Vortraining mit gemischten Text- und Audiodaten und nutzt die synthetischen Textdaten des von Kyutai entwickelten 7-Milliarden-Parameter-Sprachmodells Helium.

Der Feinschliff von Moshi umfasste 100.000 synthetische Dialoge im „Sprech-Stil“, die mithilfe der Text-to-Speech (TTS)-Technologie konvertiert wurden. Der Klang des Modells wurde mit synthetischen Daten trainiert, die von einem anderen TTS-Modell generiert wurden, was eine erstaunliche End-to-End-Latenzzeit von 200 Millisekunden ermöglicht.

Bemerkenswert ist auch, dass Kyutai eine kleinere Variante von Moshi entwickelt hat, die auf einem MacBook oder einer Consumer-GPU laufen kann und somit einem breiteren Nutzerkreis zugänglich ist.

Highlights: 🔍 Kyutai hat Moshi veröffentlicht, ein echtzeitfähiges, natives multimodales KI-Basismodell.

🔍 Moshi kann Emotionen verstehen und ausdrücken und unterstützt verschiedene Akzente.

🔍 Das Modell wurde sorgfältig feinabgestimmt und trainiert und zeigt eine hohe Leistung und ein vielseitiges Anwendungspotenzial.