Im Mai hat IBM das für Unternehmensumgebungen geeignete Granite13B LLM-Modell als Open Source veröffentlicht. Nun hat Armand Ruiz, Vizepräsident für AI-Plattformprodukte bei IBM, den vollständigen Inhalt des 6,48 TB großen Datensatzes enthüllt, der zum Trainieren von Granite13B verwendet wurde.

Dieser Datensatz wurde nach einer strengen Vorverarbeitung auf 2,07 TB reduziert, was einer Verringerung von 68 % entspricht. Ruiz betont, dass dieser Schritt entscheidend ist, um einen qualitativ hochwertigen, unvoreingenommenen, ethisch und rechtlich einwandfreien Datensatz zu gewährleisten, der den Anforderungen von Unternehmensumgebungen entspricht.

Der Datensatz wurde sorgfältig aus verschiedenen Quellen zusammengestellt, darunter:

- arXiv: Über 2,4 Millionen wissenschaftliche Vorabdrucke.

- Common Crawl: Eine öffentlich zugängliche Web-Crawler-Datenbank.

- DeepMind Mathematics: Mathematik-Frage-Antwort-Paare.

- Free Law: Öffentliche Gerichtsentscheidungen aus US-Gerichten.

- GitHub Clean: Code-Daten von CodeParrot.

- Hacker News: Nachrichten aus den Bereichen Informatik und Unternehmertum von 2007-2018.

- OpenWeb Text: Die Open-Source-Version des Web Text-Korpus von OpenAI.

- Project Gutenberg (PG-19): Kostenlose E-Books mit Schwerpunkt auf älteren Werken.

- Pubmed Central: Artikel aus den Bereichen Biomedizin und Biowissenschaften.

- SEC Filings: 10-K/Q-Einreichungen der US-amerikanischen Börsenaufsichtsbehörde (SEC) (1934-2022).

- Stack Exchange: Benutzerbeiträge aus dem Stack Exchange-Netzwerk.

- USPTO: Von 1975 bis Mai 2023 erteilte US-Patente.

- Webhose: Konvertierung unstrukturierter Webinhalte in maschinenlesbare Daten.

- Wikimedia: Acht englischsprachige Wikimedia-Projekte.

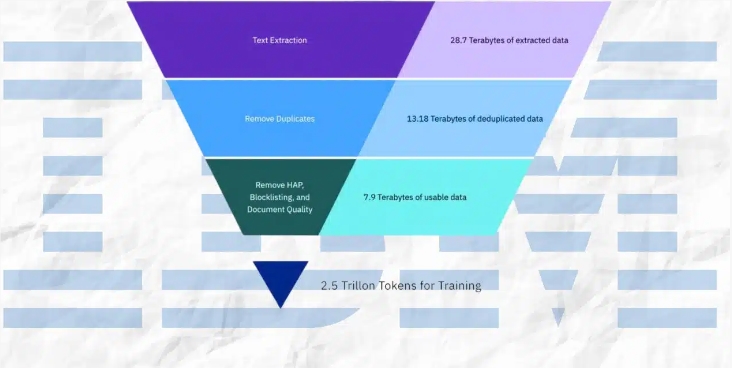

Die Vorverarbeitung umfasste Textextraktion, Deduplizierung, Spracherkennung, Satzsegmentierung, Kennzeichnung von Hassreden, Missbrauch und Schimpfwörtern, Kennzeichnung der Dokumentqualität, Kennzeichnung von URL-Maskierungen, Filterung und Tokenisierung.

Diese Schritte beinhalteten die Kennzeichnung und Filterung basierend auf festgelegten Schwellenwerten, um sicherzustellen, dass der endgültige Datensatz die höchste Qualität für das Modelltraining aufweist.

IBM hat vier Versionen des Granite-Codemodells mit einer Parameteranzahl zwischen 3 und 34 Milliarden veröffentlicht. Diese Modelle wurden in einer Reihe von Benchmarks getestet und übertreffen in vielen Aufgaben vergleichbare Modelle wie Code Llama und Llama3.

Wichtigste Punkte:

⭐ IBM hat den vollständigen 6,48 TB großen Datensatz veröffentlicht, der zum Trainieren des Granite13B LLM-Modells verwendet wurde.

⭐ Der Datensatz wurde nach einer strengen Vorverarbeitung auf 2,07 TB reduziert, was einer Verringerung von 68 % entspricht.

⭐ IBM hat vier Versionen des Granite-Codemodells mit einer Parameteranzahl zwischen 3 und 34 Milliarden veröffentlicht.