Groq hat kürzlich auf seiner Website eine blitzschnelle LLM-Engine vorgestellt, die es Entwicklern ermöglicht, schnell große Sprachmodelle abzufragen und Aufgaben auszuführen.

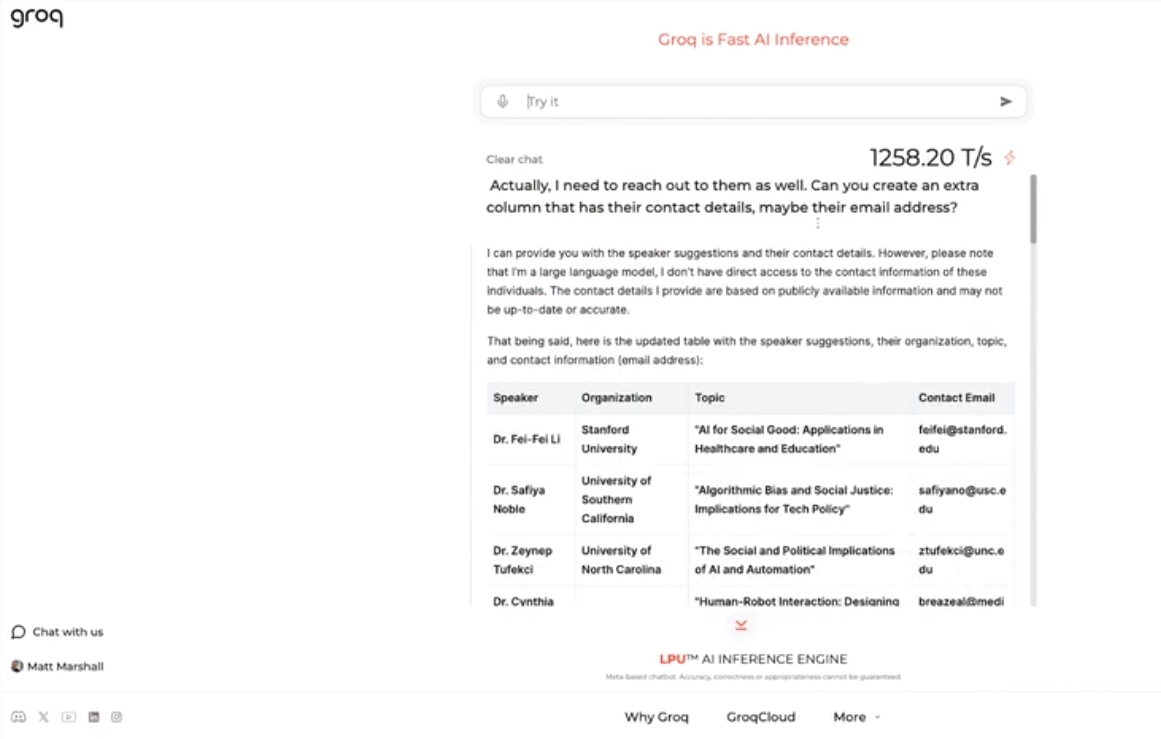

Diese Engine nutzt Metas Open-Source-LLM Llama 3-8b-8192 und unterstützt standardmäßig weitere Modelle. Ihre Geschwindigkeit ist erstaunlich. Tests ergaben, dass die Groq-Engine 1256,54 Token pro Sekunde verarbeiten kann – deutlich mehr als GPUs von Nvidia und anderen Herstellern. Dies hat sowohl bei Entwicklern als auch bei Nicht-Entwicklern große Aufmerksamkeit erregt und die Schnelligkeit und Flexibilität von LLM-Chatbots demonstriert.

Groqs CEO Jonathan Ross erklärt, dass die Nutzung von LLMs weiter zunehmen wird, da die Menschen feststellen werden, wie einfach es ist, sie auf der schnellen Engine von Groq zu verwenden. Die Demos zeigen, wie einfach verschiedene Aufgaben, wie das Erstellen von Stellenanzeigen oder das Bearbeiten von Texten, mit dieser Geschwindigkeit erledigt werden können. Die Groq-Engine kann sogar Anfragen über Sprachbefehle bearbeiten und demonstriert so ihre Leistungsfähigkeit und Benutzerfreundlichkeit.

Neben dem kostenlosen Angebot von LLM-Workload-Services stellt Groq Entwicklern ein Konsolen-Tool zur Verfügung, mit dem sie Anwendungen, die auf OpenAI aufgebaut wurden, einfach auf Groq umstellen können.

Diese einfache Umstellung hat viele Entwickler angezogen. Mittlerweile nutzen über 280.000 Entwickler die Dienste von Groq. CEO Ross prognostiziert, dass bis zum nächsten Jahr über die Hälfte aller Inferenzberechnungen weltweit auf Groq-Chips laufen werden, was das Potenzial und die Zukunftsaussichten des Unternehmens im Bereich KI unterstreicht.

Wichtigste Punkte:

🚀 Groq präsentiert eine blitzschnelle LLM-Engine, die 1256,54 Token pro Sekunde verarbeitet – deutlich schneller als GPUs.

🤖 Groqs Engine demonstriert die Schnelligkeit und Flexibilität von LLM-Chatbots und zieht Entwickler und Nicht-Entwickler gleichermaßen an.

💻 Groq bietet einen kostenlosen LLM-Workload-Service an, der bereits von über 280.000 Entwicklern genutzt wird. Es wird erwartet, dass bis zum nächsten Jahr die Hälfte aller Inferenzberechnungen weltweit auf Groq-Chips laufen wird.