Das ByteDance-Team für große Sprachmodelle hat erneut einen Erfolg erzielt: Ihr Depth Anything V2-Modell wurde in die Core ML-Modellbibliothek von Apple aufgenommen. Dieses Ergebnis ist nicht nur ein technischer Durchbruch, sondern vor allem bemerkenswert, weil die Projektleiterin eine Praktikantin ist.

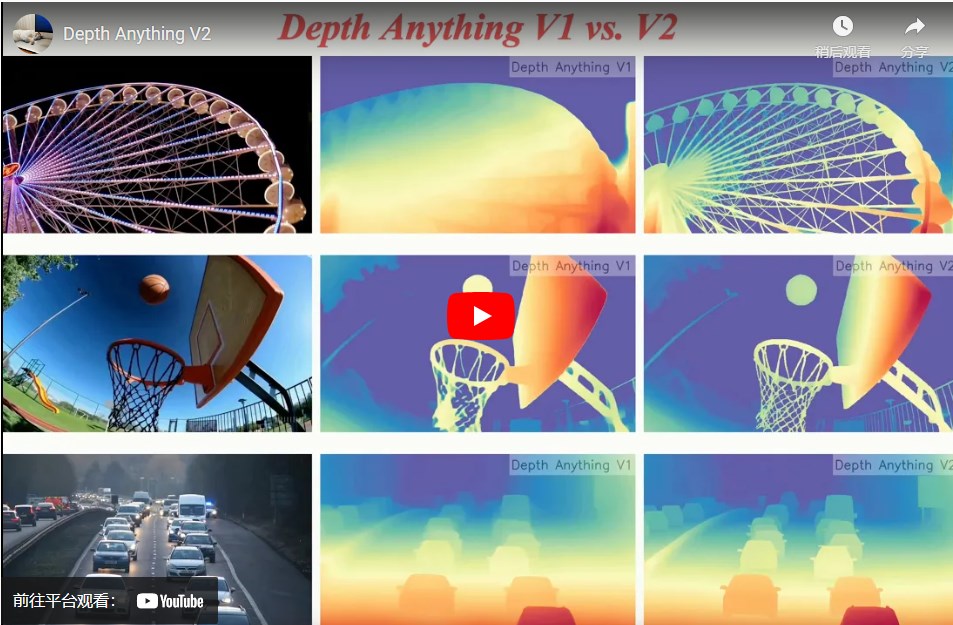

Depth Anything V2 ist ein Monokulares Tiefenestimationsmodell, das aus einem einzelnen Bild Tiefeninformationen einer Szene berechnen kann. Das Modell hat sich von der Version V1 aus Anfang 2024 bis zur aktuellen V2-Version entwickelt und die Parameterzahl von 25 Millionen auf 1,3 Milliarden erhöht. Es findet Anwendung in verschiedenen Bereichen, darunter Videoeffekte, autonomes Fahren, 3D-Modellierung und Augmented Reality.

Das Modell hat auf GitHub bereits 8.700 Sterne erhalten. Die V2-Version sammelte kurz nach der Veröffentlichung 2.300 Sterne, während die V1-Version 6.400 Sterne erreichte. Ein solcher Erfolg ist für jedes technische Team ein Grund zum Stolz, besonders wenn die Hauptkraft dahinter eine Praktikantin ist.

Die Aufnahme von Depth Anything V2 in die Core ML-Modellbibliothek von Apple ist eine hohe Anerkennung der Modellleistung und der Zukunftsaussichten. Core ML, Apples Framework für maschinelles Lernen, ermöglicht den effizienten Betrieb von Machine-Learning-Modellen auf iOS- und macOS-Geräten, selbst ohne Internetverbindung können komplexe KI-Aufgaben ausgeführt werden.

Die Core ML-Version von Depth Anything V2 verwendet mindestens ein 25-Millionen-Parameter-Modell. Durch die Optimierung durch das offizielle HuggingFace-Engineering erreicht es auf einem iPhone 12 Pro Max eine Inferenzgeschwindigkeit von 31,1 Millisekunden. Zusammen mit anderen ausgewählten Modellen wie FastViT, ResNet50 und YOLOv3 deckt es Bereiche von der Verarbeitung natürlicher Sprache bis zur Bilderkennung ab.

Im Zuge der Entwicklung großer Sprachmodelle wird der Wert von Skalierungsgesetzen (Scaling Laws) immer mehr anerkannt. Das Depth Anything-Team hat sich für die Entwicklung eines einfachen, aber leistungsstarken Basismodells entschieden, um in einer einzelnen Aufgabe bessere Ergebnisse zu erzielen. Sie sind der Ansicht, dass die Lösung grundlegender Probleme mithilfe von Skalierungsgesetzen einen größeren praktischen Wert hat. Die Tiefenschätzung, eine wichtige Aufgabe im Bereich des Computersehens, die aus Bildern die Entfernung von Objekten in einer Szene ableitet, ist für Anwendungen wie autonomes Fahren, 3D-Modellierung und Augmented Reality unerlässlich. Depth Anything V2 hat nicht nur ein breites Anwendungsspektrum in diesen Bereichen, sondern kann auch als Middleware in Videoplattformen oder Videoschnittsoftware integriert werden, um die Erstellung von Spezialeffekten und die Videobearbeitung zu unterstützen. Die federführende Entwicklerin des Depth Anything-Projekts ist eine Praktikantin des Teams. Dieser Nachwuchsstar hat unter Anleitung ihres Mentors in weniger als einem Jahr den Großteil der Arbeit vom Projektkonzept bis zur Abfassung der wissenschaftlichen Arbeit geleistet. Das Unternehmen und das Team boten ein freies Forschungsumfeld und umfassende Unterstützung und ermutigten die Praktikantin, sich mit schwierigeren und grundlegenderen Problemen auseinanderzusetzen.

Das Wachstum dieser Praktikantin und der Erfolg von Depth Anything V2 zeigen nicht nur den persönlichen Einsatz und das Talent, sondern auch die intensive Erforschung und Talentförderung von ByteDance im Bereich der visuellen Generierung und großer Sprachmodelle.

Projektseite: https://top.aibase.com/tool/depth-anything-v2