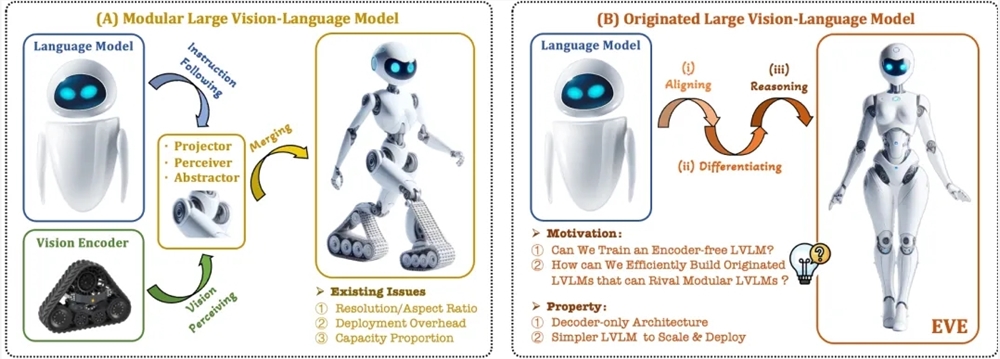

Kürzlich wurden bemerkenswerte Fortschritte in der Forschung und Anwendung von multimodalen großen Sprachmodellen erzielt. Ausländische Unternehmen wie OpenAI, Google und Microsoft haben eine Reihe fortschrittlicher Modelle vorgestellt, und auch inländische Organisationen wie Zhihu AI und Jieyue Xingchen haben auf diesem Gebiet Durchbrüche erzielt. Diese Modelle verlassen sich in der Regel auf visuelle Encoder, um visuelle Merkmale zu extrahieren und mit großen Sprachmodellen zu kombinieren. Dies führt jedoch zu einem Problem der visuellen Induktionsverzerrung aufgrund getrennter Trainingsmethoden, was die Implementierungs-Effizienz und die Leistung multimodaler großer Sprachmodelle einschränkt.

Um diese Probleme zu lösen, haben das Zhiyuan-Institut in Zusammenarbeit mit der Universität für Wissenschaft und Technologie Dalian und der Universität Peking ein neues visuelles Sprachmodell ohne Encoder namens EVE vorgestellt. EVE integriert visuelle und sprachliche Repräsentationen, Ausrichtung und Inferenz in eine einheitliche reine Decoder-Architektur durch raffinierte Trainingsstrategien und zusätzliche visuelle Überwachung. Mit öffentlich zugänglichen Daten erzielt EVE in mehreren visuellen und sprachlichen Benchmark-Tests hervorragende Ergebnisse, die denen der gängigen encoderbasierten multimodalen Methoden nahekommen oder diese sogar übertreffen.

Die Hauptmerkmale von EVE sind:

Visuelles Sprachmodell ohne Encoder: Verzicht auf visuelle Encoder, Verarbeitung beliebiger Bildseitenverhältnisse, deutlich besser als vergleichbare Fuyu-8B-Modelle.

Geringe Daten- und Trainingskosten: Das Vortraining verwendet öffentlich zugängliche Daten wie OpenImages, SAM und LAION, die Trainingszeit ist kürzer.

Transparente und effiziente Exploration: Bietet einen effizienten und transparenten Entwicklungspfad für reine Decoder-basierte multimodale Architekturen.

Modellstruktur:

Patch Embedding Layer: Gewinnung von 2D-Merkmalskarten des Bildes über eine einschichtige Faltungsschicht und eine Durchschnittspooling-Schicht, um lokale und globale Informationen zu verbessern.

Patch Aligning Layer: Integration von visuellen Merkmalen aus mehreren Netzwerkschichten, um eine feinkörnige Ausrichtung mit der Ausgabe des visuellen Encoders zu erreichen.

Trainingsstrategie:

Vom großen Sprachmodell geführte Vortrainings-Phase: Aufbau einer ersten Verbindung zwischen visuellen und sprachlichen Informationen.

Generative Vortrainings-Phase: Verbesserung des Verständnisses des Modells für visuelle und sprachliche Inhalte.

Überwachte Feinabstimmungsphase: Schulung des Modells, um Anweisungen zu befolgen und Dialogmuster zu erlernen.

Quantitative Analyse: EVE zeigt in mehreren visuellen und sprachlichen Benchmark-Tests hervorragende Ergebnisse und ist mit verschiedenen gängigen encoderbasierten visuellen Sprachmodellen vergleichbar. Obwohl Herausforderungen bei der genauen Beantwortung spezifischer Anweisungen bestehen, erreicht EVE durch effiziente Trainingsstrategien eine mit encoderbasierten visuellen Sprachmodellen vergleichbare Leistung.

EVE demonstriert das Potenzial von nativen visuellen Sprachmodellen ohne Encoder. Zukünftige Verbesserungen der Leistung, Optimierungen der Architektur ohne Encoder und der Aufbau nativer multimodaler Systeme könnten die Entwicklung multimodaler Modelle weiter vorantreiben.

Paper-Adresse: https://arxiv.org/abs/2406.11832

Projektcode: https://github.com/baaivision/EVE

Modell-Adresse: https://huggingface.co/BAAI/EVE-7B-HD-v1.0