In der Welt der künstlichen Intelligenz sind große Sprachmodelle (LLMs) für ihre herausragenden Fähigkeiten in der Verarbeitung natürlicher Sprache bekannt. Der Einsatz dieser Modelle in der Praxis steht jedoch vor großen Herausforderungen, hauptsächlich aufgrund ihrer hohen Rechenkosten und ihres hohen Speicherbedarfs während der Inferenzphase. Um dieses Problem zu lösen, erforschen Wissenschaftler kontinuierlich Möglichkeiten zur Verbesserung der Effizienz von LLMs. Kürzlich hat eine Methode namens Q-Sparse große Aufmerksamkeit erregt.

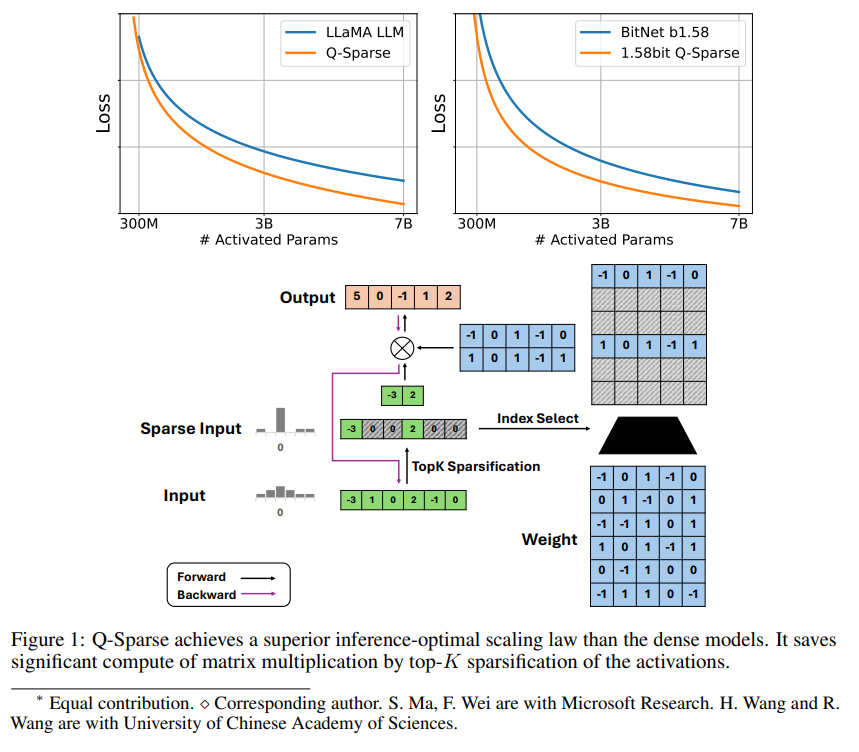

Q-Sparse ist eine einfache, aber effektive Methode, die durch die Anwendung von Top-K-Verdünnung in der Aktivierung und eines Straight-Through-Estimators während des Trainings eine vollständig dünnbesetzte Aktivierung von LLMs erreicht. Dies bedeutet eine signifikante Effizienzsteigerung während der Inferenz. Die wichtigsten Forschungsergebnisse umfassen:

Q-Sparse erreicht eine höhere Inferenzeffizienz bei vergleichbaren Ergebnissen zu Baseline-LLMs.

Es wurde ein optimales Skalierungsgesetz für die Inferenz von dünnbesetzten LLMs vorgeschlagen.

Q-Sparse ist in verschiedenen Einstellungen effektiv, einschließlich Training von Grund auf, Weitertraining und Feintuning von bestehenden LLMs.

Q-Sparse ist sowohl für LLMs mit voller Genauigkeit als auch für 1-Bit-LLMs (z. B. BitNet b1.58) geeignet.

Vorteile dünnbesetzter Aktivierung

Die Dünnbesetztheit verbessert die Effizienz von LLMs auf zwei Arten: Erstens reduziert sie den Rechenaufwand der Matrixmultiplikation, da Nullelemente nicht berechnet werden; zweitens reduziert sie den Datenübertragungsaufwand für Ein-/Ausgabe (I/O), der der Hauptengpass in der Inferenzphase von LLMs ist.

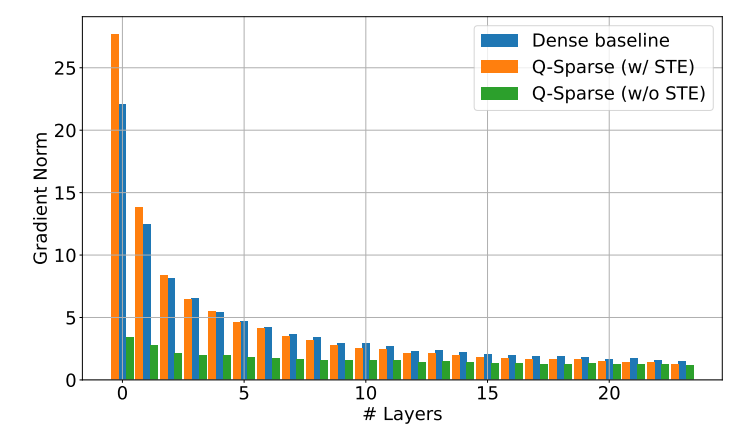

Q-Sparse erreicht die vollständige Dünnbesetztheit der Aktivierung durch Anwendung einer Top-K-Verdünnungsfunktion in jeder linearen Projektion. Für die Rückwärtsausbreitung wird ein Straight-Through-Estimator zur Berechnung des Aktivierungsgradienten verwendet. Zusätzlich wird eine quadratische ReLU-Funktion eingeführt, um die Dünnbesetztheit der Aktivierung weiter zu verbessern.

Experimentelle Validierung

Die Forscher untersuchten durch eine Reihe von Skalierungsexperimenten die Skalierungsgesetze für dünnbesetzte LLMs und machten einige interessante Entdeckungen:

Die Leistung dünnbesetzter Aktivierungsmodelle steigt mit zunehmender Modellgröße und Verdünnungsrate.

Bei einer festen Verdünnungsrate S folgt die Leistung dünnbesetzter Aktivierungsmodelle einem Potenzgesetz in Bezug auf die Modellgröße N.

Bei einer festen Anzahl von Parametern N folgt die Leistung dünnbesetzter Aktivierungsmodelle einem Exponentialgesetz in Bezug auf die Verdünnungsrate S.

Q-Sparse kann nicht nur für das Training von Grund auf verwendet werden, sondern auch für das Weitertraining und Feintuning bestehender LLMs. Im Weitertrainings- und Feintuning-Setup verwenden die Forscher dieselbe Architektur und denselben Trainingsprozess wie beim Training von Grund auf. Der einzige Unterschied besteht darin, dass das Modell mit vorab trainierten Gewichten initialisiert und die Verdünnungsfunktion für das Weitertraining aktiviert wird.

Die Forscher untersuchen derzeit die Kombination von Q-Sparse mit 1-Bit-LLMs (wie BitNet b1.58) und Mixture-of-Experts (MoE), um die Effizienz von LLMs weiter zu verbessern. Darüber hinaus arbeiten sie daran, Q-Sparse mit Batch-Modus kompatibel zu machen, was mehr Flexibilität für das Training und die Inferenz von LLMs bietet.