Kürzlich haben die Forschungsteams von Apple und Meta AI eine neue Technologie namens LazyLLM vorgestellt, die die Effizienz großer Sprachmodelle (LLMs) bei der Verarbeitung langer Texte verbessert.

Bekanntlich sind aktuelle LLMs bei der Verarbeitung langer Eingaben, insbesondere in der Vorbereitungsphase, oft langsam. Dies liegt hauptsächlich daran, dass die Rechenkomplexität moderner Transformer-Architekturen beim Berechnen der Aufmerksamkeit quadratisch mit der Anzahl der Tokens im Input wächst. Daher ist die Berechnungszeit des ersten Tokens beim Llama2-Modell oft 21-mal höher als die der nachfolgenden Dekodierungsschritte und macht 23 % der Gesamtgenerierungszeit aus.

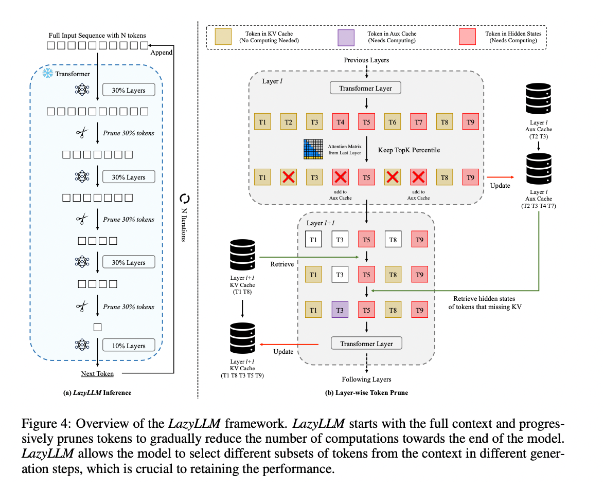

Um dies zu verbessern, schlagen die Forscher LazyLLM vor, eine neue Methode zur Beschleunigung der LLM-Inferenz durch dynamische Auswahl wichtiger Tokens. Der Kern von LazyLLM liegt in der Bewertung der Wichtigkeit jedes Tokens basierend auf den Aufmerksamkeitswerten vorheriger Schichten, um den Rechenaufwand schrittweise zu reduzieren. Im Gegensatz zu permanenter Komprimierung kann LazyLLM bei Bedarf die reduzierten Tokens wiederherstellen, um die Genauigkeit des Modells zu gewährleisten. Darüber hinaus führt LazyLLM einen Aux-Cache ein, der die Hidden States der gekürzten Tokens speichert, um diese effizient wiederherzustellen und Leistungseinbußen zu vermeiden.

LazyLLM zeigt eine hervorragende Leistung in Bezug auf die Inferenzgeschwindigkeit, insbesondere in der Vorbereitungs- und Dekodierungsphase. Die drei Hauptvorteile der Technologie sind: Kompatibilität mit allen Transformer-basierten LLMs, keine Notwendigkeit für ein erneutes Training des Modells und hohe Effizienz bei verschiedenen sprachlichen Aufgaben. Die dynamische Pruning-Strategie von LazyLLM ermöglicht eine erhebliche Reduzierung des Rechenaufwands bei gleichzeitiger Beibehaltung der meisten wichtigen Tokens, was zu einer schnelleren Generierung führt.

Die Ergebnisse zeigen, dass LazyLLM bei mehreren sprachlichen Aufgaben hervorragende Leistungen erbringt, mit einer TTFT-Geschwindigkeitsverbesserung um das 2,89-fache (für Llama2) und das 4,77-fache (für XGen) bei nahezu gleichbleibender Genauigkeit im Vergleich zur Baseline. Ob Frage-Antwort-Systeme, Zusammenfassungen oder Code-Completion – LazyLLM ermöglicht eine schnellere Generierung und erzielt ein gutes Gleichgewicht zwischen Leistung und Geschwindigkeit. Die schrittweise Pruning-Strategie und die schichtenweise Analyse bilden die Grundlage für den Erfolg von LazyLLM.

论文地址:https://arxiv.org/abs/2407.14057

Wichtigste Punkte:

🌟 LazyLLM beschleunigt die LLM-Inferenz durch dynamische Auswahl wichtiger Tokens, insbesondere bei langen Texten.

⚡ Die Technologie verbessert die Inferenzgeschwindigkeit deutlich, mit einer TTFT-Verbesserung um bis zu 4,77-fach bei gleichzeitiger Aufrechterhaltung hoher Genauigkeit.

🔧 LazyLLM erfordert keine Änderungen an bestehenden Modellen und ist mit allen Transformer-basierten LLMs kompatibel, wodurch die Implementierung einfach ist.