Nach der gestrigen Ankündigung von Meta zur Veröffentlichung des leistungsstärksten Open-Source-Modells Llama 3.1, hat Mistral AI heute früh sein Flaggschiffmodell Mistral Large 2 vorgestellt. Dieses neue Produkt verfügt über 123 Milliarden Parameter und ein extrem großes Kontextfenster von 128k, womit es mit Llama 3.1 vergleichbar ist.

Mistral Large 2 Modelldetails

Mistral Large 2 verfügt über ein Kontextfenster von 128k und unterstützt Dutzende von Sprachen, darunter Französisch, Deutsch, Spanisch, Italienisch, Portugiesisch, Arabisch, Hindi, Russisch, Chinesisch, Japanisch und Koreanisch, sowie über 80 Programmiersprachen wie Python, Java, C, C++, JavaScript und Bash.

Mistral Large 2 wurde für die Einzelknoten-Inferenz entwickelt und richtet sich hauptsächlich an Anwendungen mit langem Kontext. Seine Größe von 123 Milliarden Parametern ermöglicht einen hohen Durchsatz auf einem einzelnen Knoten. Mistral Large 2 wird unter der Mistral Research License veröffentlicht und ist für Forschungs- und nicht-kommerzielle Zwecke bestimmt; für kommerzielle Zwecke ist eine Kontaktaufnahme zur Erlangung einer kommerziellen Lizenz erforderlich.

Gesamtperformance:

In Bezug auf die Leistung setzt Mistral Large 2 neue Maßstäbe bei den Bewertungsmetriken und erreicht insbesondere im MMLU-Benchmark eine Genauigkeit von 84,0 %, was eine starke Performance bei ausgewogenen Servicekosten zeigt.

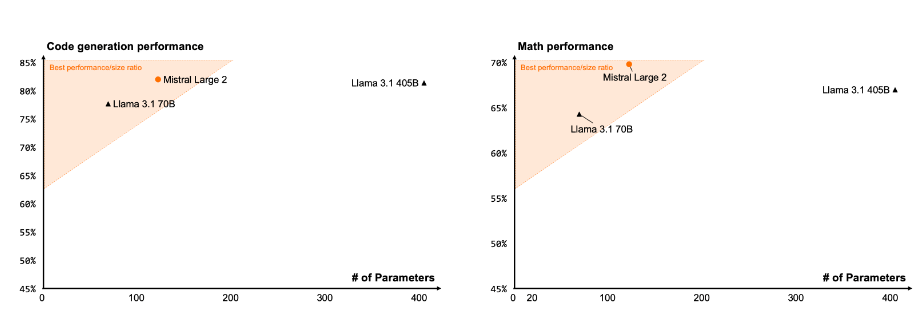

Code und Inferenz

Durch die Lernerfahrungen mit Codestral 22B und Codestral Mamba zeigt Mistral Large 2 eine hervorragende Leistung in der Codeverarbeitung, die sogar mit Top-Modellen wie GPT-4o, Claude 3 Opus und Llama 3405B vergleichbar ist.

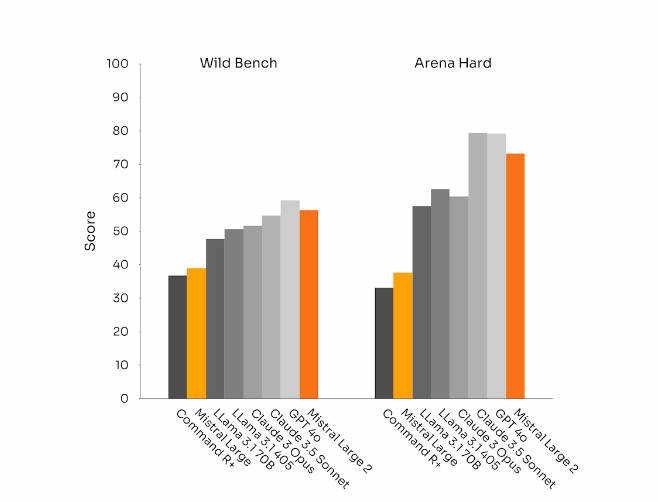

Anweisungsbefolgung und Ausrichtung

Mistral Large 2 hat auch bei der Anweisungsbefolgung und den Konversationsfähigkeiten erhebliche Fortschritte gemacht, insbesondere bei der flexibleren Bearbeitung komplexer, mehrstufiger Dialoge. Bei einigen Benchmarks führt die Generierung längerer Antworten oft zu höheren Punktzahlen. In vielen kommerziellen Anwendungen ist jedoch Kürze entscheidend – kürzere Modellgenerierungen beschleunigen die Interaktion und die Inferenz ist kostengünstiger.

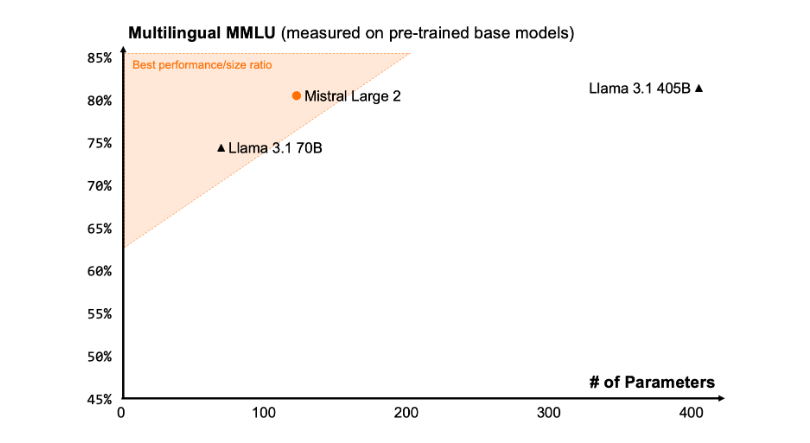

Sprachvielfalt

Das neue Mistral Large 2 wurde mit umfangreichen mehrsprachigen Daten trainiert und zeigt besonders gute Ergebnisse in Englisch, Französisch, Deutsch, Spanisch, Italienisch, Portugiesisch, Niederländisch, Russisch, Chinesisch, Japanisch, Koreanisch, Arabisch und Hindi. Im Folgenden finden Sie die Performance-Ergebnisse von Mistral Large 2 im mehrsprachigen MMLU-Benchmark im Vergleich zu den Vorgängermodellen Mistral Large, Llama 3.1 und Cohere's Command R+.

Tool-Nutzung und Funktionsaufrufe

Mistral Large 2 verfügt über verbesserte Funktionsaufrufe und Retrieval-Fähigkeiten und wurde darauf trainiert, parallele und sequentielle Funktionsaufrufe gekonnt auszuführen, wodurch es als leistungsstarkes Backend für komplexe Geschäftsanwendungen dienen kann.

Verwendungsweise:

Derzeit können Benutzer Mistral Large 2 auf der La Plateforme (https://console.mistral.ai/) unter dem Namen mistral-large-2407 verwenden und im Chat testen. Es ist in der Version 24.07 (unser YY.MM Versionskontrollsystem, das wir auf alle Modelle anwenden) und unter dem API-Namen mistral-large-2407 verfügbar. Die Gewichte des instruct-Modells sind verfügbar und werden auch auf HuggingFace gehostet (https://huggingface.co/mistralai/Mistral-Large-Instruct-2407).

Die Produkte auf der La Plateforme umfassen die beiden allgemeinen Modelle Mistral Nemo und Mistral Large sowie die beiden spezialisierten Modelle Codestral und Embed. Während wir die alten Modelle auf der La Plateforme schrittweise außer Betrieb nehmen, sind alle Apache-Modelle (Mistral 7B, Mixtral 8x7B und 8x22B, Codestral Mamba, Mathstral) weiterhin mit dem SDK mistral-inference und mistral-finetune bereitstellbar und feinabstimmbar.

Ab heute wird die Feinabstimmungsfunktion auf der La Plateforme erweitert: Diese Funktionen sind jetzt für Mistral Large, Mistral Nemo und Codestral verfügbar.

Mistral AI arbeitet auch mit mehreren führenden Cloud-Anbietern zusammen, um Mistral Large 2 weltweit verfügbar zu machen, insbesondere auch auf der Google Cloud Platform in Vertex AI.

Wichtige Punkte:

🌟 Mistral Large 2 verfügt über ein Kontextfenster von 128k und unterstützt bis zu zehn Sprachen und über 80 Programmiersprachen.

📈 Es erreicht eine Genauigkeit von 84,0 % im MMLU-Benchmark und bietet eine hervorragende Performance bei ausgewogenen Kosten.

💻 Benutzer können über die La Plateforme auf das neue Modell zugreifen und es auf Cloud-Plattformen einsetzen.