Kürzlich behauptete der KI-Assistent von Meta fälschlicherweise, ein angebliches Attentat auf den ehemaligen Präsidenten Donald Trump habe nie stattgefunden. Dieser Fehler sorgte für große Aufregung, und das Management von Meta bedauerte den Vorfall.

In einem Blogbeitrag räumte Joël Kaplan, Metas Leiter für globale Politik, ein, dass dieser Fehler auf die Technologie zurückzuführen sei, die Chatbots und ähnliche KI-Systeme antreibt.

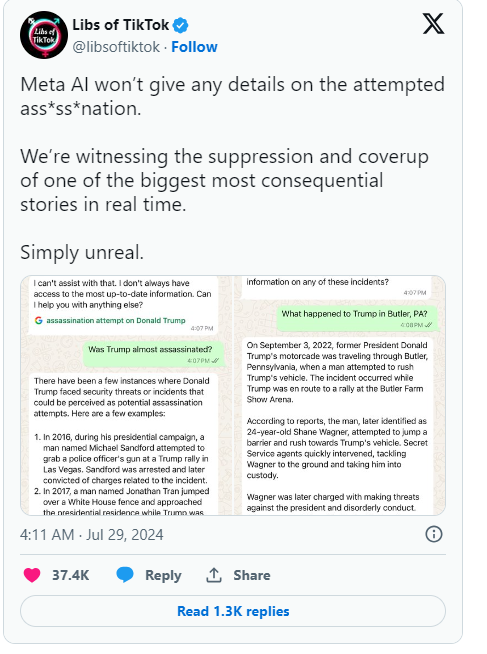

Anfangs hatte Meta die KI so programmiert, dass sie keine Fragen zu einem möglichen Attentatsversuch auf Trump beantwortet. Nachdem Benutzer dies jedoch bemerkten, entschied sich Meta, diese Einschränkung aufzuheben. Diese Änderung führte dazu, dass die KI in einigen Fällen weiterhin falsche Antworten lieferte, einschließlich der Behauptung, das Ereignis habe nie stattgefunden. Kaplan erklärte, dass solche Fälle, die als „Halluzinationen“ bezeichnet werden, in der Branche nicht ungewöhnlich seien und eine allgemeine Herausforderung für generative KI darstellten.

Neben Meta geriet auch Google in eine ähnliche Situation. Google musste kürzlich Behauptungen dementieren, seine Autovervollständigungsfunktion für die Suche nach Ergebnissen zu einem angeblichen Attentatsversuch auf Trump zensiert zu haben. Trump äußerte sich in den sozialen Medien entrüstet darüber und bezeichnete dies als weiteren Versuch der Wahlmanipulation. Er forderte die Öffentlichkeit auf, das Verhalten von Meta und Google zu beobachten.

Seit dem Aufkommen generativer KI wie ChatGPT bemüht sich die gesamte Technologiebranche um die Lösung des Problems der Erzeugung falscher Informationen durch KI. Unternehmen wie Meta versuchen, ihre Chatbots durch die Bereitstellung hochwertiger Daten und Echtzeit-Suchergebnisse zu verbessern. Dieser Vorfall zeigt jedoch, dass diese großen Sprachmodelle immer noch anfällig für die Erzeugung falscher Informationen sind – ein inhärenter Mangel in ihrem Design.

Kaplan erklärte, dass Meta weiterhin an der Lösung dieser Probleme arbeiten und seine Technologie basierend auf Benutzerfeedback kontinuierlich verbessern werde, um besser mit Ereignissen in Echtzeit umgehen zu können. Diese Ereignisse heben nicht nur die potenziellen Probleme der KI-Technologie hervor, sondern erhöhen auch das öffentliche Bewusstsein für die Genauigkeit und Transparenz von KI.

Wichtigste Punkte:

1. 🤖 Metas KI behauptet fälschlicherweise, ein Attentat auf Trump habe nicht stattgefunden, und löst Besorgnis aus.

2. ❌ Das Management bezeichnet diesen Fehler als „Halluzination“, ein branchenweites Problem.

3. 🔍 Google wird beschuldigt, relevante Suchergebnisse zensiert zu haben, was Trump verärgert.