Kürzlich hat Zyphra das neue Sprachmodell Zamba2-2.7B veröffentlicht, ein Meilenstein in der Entwicklung kleiner Sprachmodelle. Das neue Modell bietet erhebliche Verbesserungen in Bezug auf Leistung und Effizienz. Es wurde mit einem Datensatz von etwa 3 Billionen Token trainiert und erreicht damit eine vergleichbare Leistung wie Zamba1-7B und andere führende 7B-Modelle.

Besonders überraschend ist der deutlich geringere Ressourcenbedarf von Zamba2-2.7B während der Inferenz, was es zu einer effizienten Lösung für mobile Anwendungen macht.

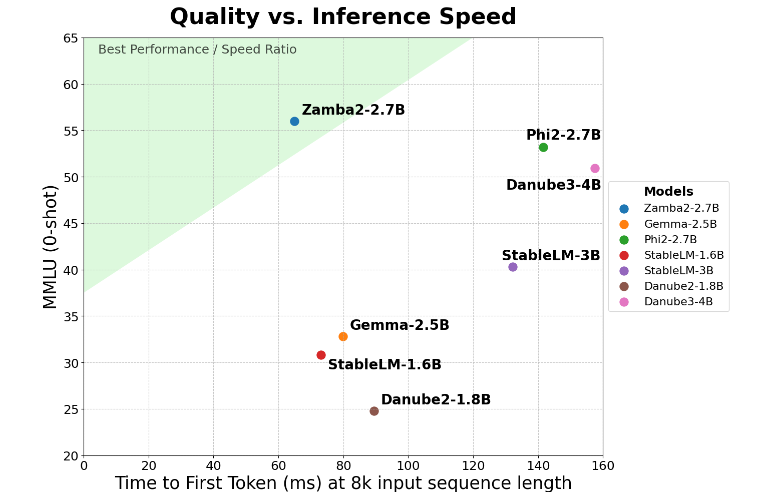

Bei der wichtigen Kennzahl „Zeit bis zur ersten Antwort“ erzielte Zamba2-2-7B eine Verdoppelung der Geschwindigkeit. Dies bedeutet, dass es im Vergleich zu Konkurrenzmodellen deutlich schneller erste Antworten generiert. Für Anwendungen wie virtuelle Assistenten und Chatbots, die Echtzeitinteraktionen erfordern, ist dies von entscheidender Bedeutung.

Neben der Geschwindigkeit überzeugt Zamba2-2.7B auch durch seinen effizienten Umgang mit dem Arbeitsspeicher. Der Speicherbedarf wurde um 27 % reduziert, was es zur idealen Wahl für Geräte mit begrenzten Ressourcen macht. Dieses intelligente Speichermanagement sorgt für einen effizienten Betrieb des Modells auch unter eingeschränkten Rechenressourcen und erweitert seinen Einsatzbereich auf diverse Geräte und Plattformen.

Ein weiterer wichtiger Vorteil von Zamba2-2.7B ist die niedrigere Latenz. Im Vergleich zu Phi3-3.8B ist die Latenz um das 1,29-fache geringer, was zu einem flüssigeren Benutzererlebnis führt. Die niedrige Latenz ist besonders wichtig für Anwendungen, die einen nahtlosen und kontinuierlichen Austausch erfordern, wie z. B. Kundendienst-Bots und interaktive Lerntools. Daher ist Zamba2-2.7B für Entwickler die erste Wahl, um die Benutzerfreundlichkeit zu verbessern.

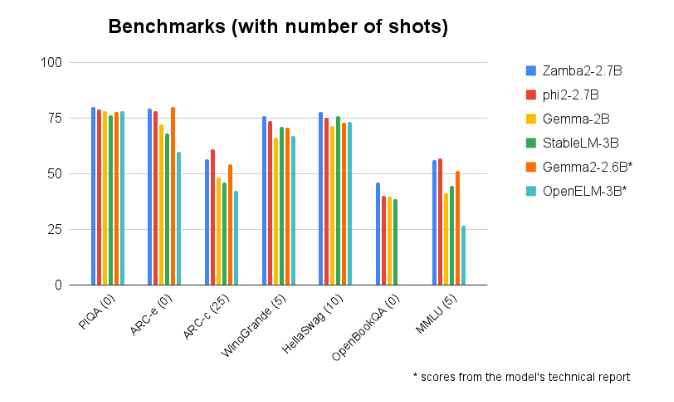

In Benchmark-Vergleichen mit anderen Modellen ähnlicher Größe schneidet Zamba2-2.7B durchweg hervorragend ab. Seine überragende Leistung beweist die Innovationskraft und das Engagement von Zyphra bei der Weiterentwicklung der KI-Technologie. Das Modell verwendet einen verbesserten, verflochtenen Shared-Attention-Mechanismus und ist mit LoRA-Projektoren auf den gemeinsam genutzten MLP-Modulen ausgestattet, um eine hocheffiziente Ausgabe bei der Bearbeitung komplexer Aufgaben zu gewährleisten.

Modellzugang: https://huggingface.co/Zyphra/Zamba2-2.7B

Wichtigste Punkte:

🌟 Zamba2-2.7B verdoppelt die Geschwindigkeit der ersten Antwort und eignet sich daher ideal für Echtzeit-Anwendungen.

💾 Das Modell reduziert den Speicherbedarf um 27 % und ist somit auch für Geräte mit begrenzten Ressourcen geeignet.

🚀 Zamba2-2.7B bietet im Vergleich zu Konkurrenzmodellen eine geringere Latenz und verbessert so das Benutzererlebnis.