Das multimodalen Großmodell Shusheng · Puyulingbi (InternLM-XComposer) wurde kürzlich auf Version 2.5 aktualisiert. Dieses vom Shanghaier Labor für Künstliche Intelligenz entwickelte Modell bietet durch seine herausragende Fähigkeit zur Verarbeitung langer Kontexte im Input und Output revolutionäre Fortschritte für die Text- und Bildverarbeitung sowie kreative Anwendungen.

IXC-2.5 meistert mühelos Kontexte mit einer Länge von bis zu 96K. Dies ist auf die während des Trainings verwendeten 24K verflochtenen Bild-Text-Daten zurückzuführen. Diese Fähigkeit zur Verarbeitung langer Kontexte ermöglicht IXC-2.5 eine hervorragende Leistung bei Aufgaben, die umfangreiche Input- und Output-Kontexte erfordern.

Im Vergleich zur Vorgängerversion bietet IXC-2.5 drei wesentliche Verbesserungen im Bereich des visuell-sprachlichen Verständnisses:

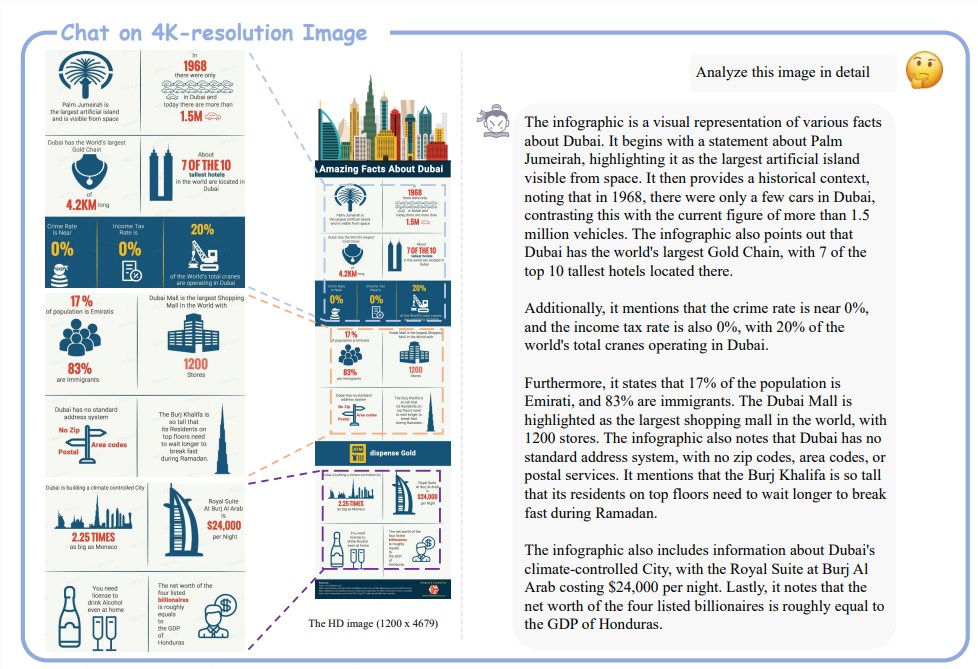

Sehr hohe Auflösungsfähigkeit: IXC-2.5 unterstützt dank seines integrierten 560×560 ViT-Bildencoders Bilder mit hoher Auflösung und beliebigem Seitenverhältnis.

Feingranulares Videoverständnis: Videos werden als hochauflösende zusammengesetzte Bilder aus Dutzenden bis Hunderten von Einzelbildern betrachtet. Durch dichtes Sampling und höhere Auflösung werden Details präzise erfasst.

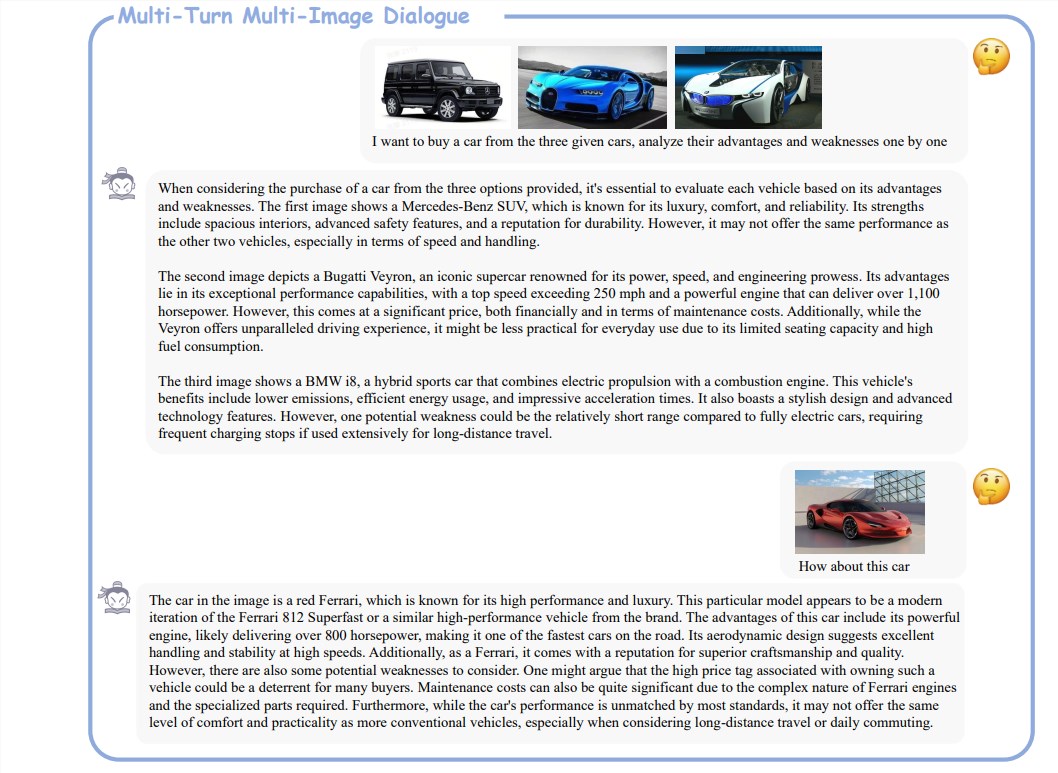

Mehrstufige Dialoge mit mehreren Bildern: Es werden frei formulierte mehrstufige Dialoge mit mehreren Bildern unterstützt, die eine natürliche Interaktion mit Menschen ermöglichen.

Neben der verbesserten Verständnisleistung bietet IXC-2.5 zwei bemerkenswerte neue Anwendungen, die mithilfe zusätzlicher LoRA-Parameter zur Erstellung von Text- und Bildinhalten dienen:

Webseitenerstellung: Basierend auf Text- und Bildanweisungen kann IXC-2.5 HTML-, CSS- und JavaScript-Quellcode schreiben und Webseiten erstellen.

Erstellung hochwertiger Bild-Text-Artikel: Durch speziell entwickelte Chain-of-Thought (CoT)- und Direct Preference Optimization (DPO)-Techniken wird die Qualität der erstellten Texte deutlich verbessert.

IXC-2.5 wurde anhand von 28 Benchmarks bewertet und übertraf in 16 Benchmarks die bestehenden Open-Source-Spitzenmodelle. Darüber hinaus erreichte es in 16 wichtigen Aufgaben eine vergleichbare oder sogar bessere Leistung als GPT-4V und Gemini Pro. Diese Ergebnisse belegen die hohe Leistungsfähigkeit und das breite Anwendungspotenzial von IXC-2.5.

Paper-Adresse: https://arxiv.org/pdf/2407.03320

Projekt-Adresse: https://github.com/InternLM/InternLM-XComposer