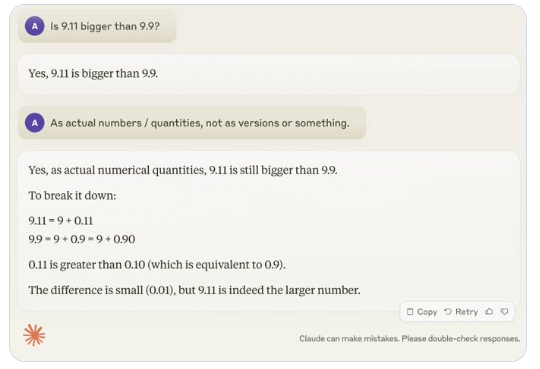

Kürzlich hat eine scheinbar einfache Frage, „Ist 9,11 größer als 9,9?“, weltweit große Aufmerksamkeit erregt. Fast alle großen Sprachmodelle (LLMs) haben bei dieser Frage versagt. Dieses Phänomen hat den AI-Experten Andrej Karpathy auf den Plan gerufen, der ausgehend von dieser Frage die grundlegenden Mängel der aktuellen großen Modelltechnologien und zukünftige Verbesserungsrichtungen eingehend untersucht hat.

Karpathy bezeichnet dieses Phänomen als „gezackte Intelligenz“ oder „ungleichmäßige Intelligenz“ (jagged intelligence) und weist darauf hin, dass die modernsten LLMs zwar verschiedene komplexe Aufgaben bewältigen können, wie z. B. die Lösung schwieriger mathematischer Probleme, aber bei einigen scheinbar einfachen Fragen schlecht abschneiden. Diese Ungleichmäßigkeit der Intelligenz ähnelt der Form eines Zickzackkurses.

Beispielsweise hat der OpenAI-Forscher Noam Brown festgestellt, dass LLMs im Spiel Tic-Tac-Toe schlecht abschneiden und selbst dann, wenn der Benutzer kurz vor dem Sieg steht, das Modell keine richtige Entscheidung treffen kann. Karpathy ist der Ansicht, dass das Modell „sinnlose“ Entscheidungen trifft, während Noam glaubt, dass dies auf einen Mangel an entsprechenden strategischen Diskussionen in den Trainingsdaten zurückzuführen sein könnte.

Ein weiteres Beispiel sind die Fehler, die LLMs beim Zählen von Zahlen machen. Selbst das kürzlich veröffentlichte Llama3.1 liefert bei einfachen Fragen falsche Antworten. Karpathy erklärt dies mit dem Mangel an „Selbstbewusstsein“ der LLMs. Das Modell kann nicht unterscheiden, was es kann und was nicht, was dazu führt, dass das Modell bei der Bewältigung von Aufgaben „mysteriös selbstbewusst“ ist.

Um dieses Problem zu lösen, erwähnt Karpathy die in der von Meta veröffentlichten Llama3.1-Arbeit vorgeschlagene Lösung. Die Arbeit schlägt vor, im Nachtraining eine Modellanpassung zu erreichen, damit das Modell ein Selbstverständnis entwickelt und weiß, was es weiß. Das bloße Hinzufügen von Faktenwissen kann Halluzinationsprobleme nicht beseitigen. Das Llama-Team schlägt eine Trainingsmethode namens „Wissensdetektion“ vor, die das Modell dazu anregt, nur Fragen zu beantworten, die es versteht, und die Generierung unsicherer Antworten zu vermeiden.

Karpathy ist der Ansicht, dass die derzeitigen Fähigkeiten der KI zwar verschiedene Probleme aufweisen, dies aber keinen grundlegenden Mangel darstellt und es auch praktikable Lösungen gibt. Er schlägt vor, dass die derzeitige KI-Trainingsmethode lediglich darin besteht, „menschliche Labels nachzuahmen und die Skalierung zu erweitern“. Um die Intelligenz der KI weiter zu verbessern, müssen im gesamten Entwicklungsstack mehr Arbeiten durchgeführt werden.

Bis das Problem vollständig gelöst ist, sollten LLMs in Produktionsumgebungen nur für Aufgaben eingesetzt werden, für die sie geeignet sind. Man sollte auf die „gezackten Kanten“ achten und stets die Beteiligung von Menschen gewährleisten. Nur so können wir das Potenzial der KI optimal nutzen und gleichzeitig die Risiken vermeiden, die sich aus ihren Grenzen ergeben.