Im Bereich der 3D-digitalen Avatare gab es zwar bereits beachtliche Fortschritte, doch bisherigen Methoden mangelte es an konsistenter Mehransichtsdarstellung und emotionaler Ausdruckskraft. Ein Forschungsteam der Nanjing Universität, der Fudan Universität und des Huawei Noah's Ark Labors hat nun einen Durchbruch erzielt, um diese Herausforderungen zu bewältigen.

Produktzugang: https://nju-3dv.github.io/projects/EmoTalk3D/

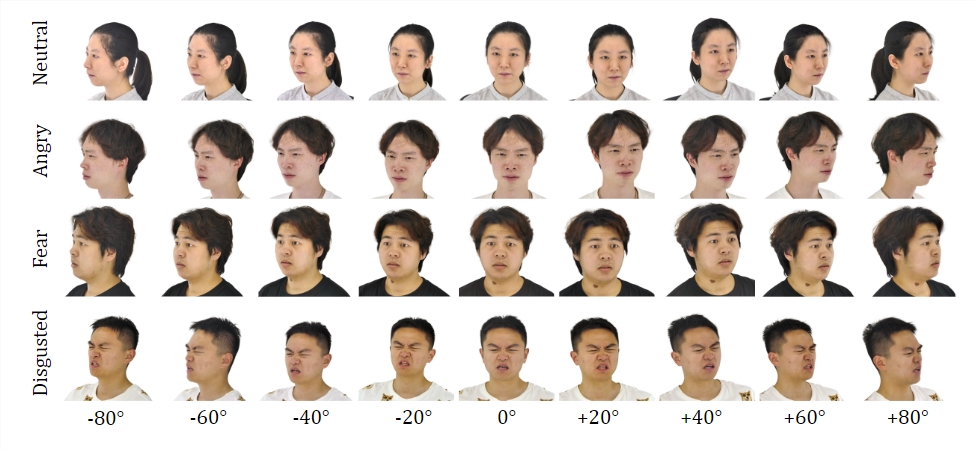

Das Team erstellte den EmoTalk3D-Datensatz, der kalibrierte Mehransichtsvideos, emotionale Markierungen und framegenaue 3D-Geometrie umfasst. Es wurde eine neue Methode zur Synthese von 3D-sprechenden Avataren mit steuerbarer Emotionalität vorgestellt, die sowohl in Bezug auf Lippensynchronität als auch auf Renderqualität eine deutliche Verbesserung aufweist.

Datensatz:

Durch Training auf dem EmoTalk3D-Datensatz erstellte das Forschungsteam ein Mapping-Framework „von Sprache zu Geometrie zu Aussehen“. Zuerst wird aus den Audiomerkmalen eine realistische 3D-Geometriefolge vorhergesagt, dann wird basierend auf der vorhergesagten Geometrie das Aussehen des 3D-sprechenden Avatars synthetisiert, das durch 4D-Gauß-Verteilungen dargestellt wird. Das Aussehen wird weiter in Standard- und dynamische Gauß-Verteilungen zerlegt, die aus Mehransichtsvideos gelernt und zur Darstellung von frei wählbaren Blickwinkeln der sprechenden Avatar-Animation kombiniert werden.

Das Modell ermöglicht die Steuerung der Emotionen im generierten sprechenden Avatar und kann in einem großen Blickwinkelbereich gerendert werden. Gleichzeitig werden dynamische Gesichtsdetails wie Falten und subtile Ausdrücke erfasst und eine verbesserte Renderqualität und Stabilität bei der Lippensynchronisation gezeigt. Die Beispiele der Ergebnisse zeigen präzise die Emotionen Freude, Ärger und Frustration des 3D-digitalen Avatars.

Der gesamte Ablauf umfasst fünf Module:

Erstens ein Emotionsinhalts-Dekompositions-Encoder, der Inhalts- und Emotionsmerkmale aus der Eingabe-Sprache extrahiert; zweitens ein Sprach-zu-Geometrie-Netzwerk, das dynamische 3D-Punktwolken aus den Merkmalen vorhersagt; drittens ein Gauß-Optimierungs- und Vervollständigungsmodul, das das Standard-Aussehen erstellt; viertens ein Geometrie-zu-Aussehen-Netzwerk, das das Gesichtsaussehen basierend auf der dynamischen 3D-Punktwolke synthetisiert; und fünftens ein Rendermodul, das die dynamischen Gauß-Verteilungen in frei wählbare Blickwinkel-Animationen rendert.

Darüber hinaus wurde der EmoTalk3D-Datensatz erstellt, ein mehransichtiger Datensatz sprechender Avatare mit emotionalen Markierungen und framegenauer 3D-Gesichtsform, der für nicht-kommerzielle Forschungszwecke öffentlich zugänglich gemacht wird.

Wichtigste Punkte:

💥 Eine neue Methode zur Synthese von digitalen Avataren mit steuerbarer Emotionalität wurde vorgestellt.

🎯 Ein Mapping-Framework „von Sprache zu Geometrie zu Aussehen“ wurde erstellt.

👀 Der EmoTalk3D-Datensatz wurde erstellt und wird veröffentlicht.