In der heutigen Zeit entwickelt sich das Gebiet der Verarbeitung natürlicher Sprache (NLP) rasant. Große Sprachmodelle (LLMs) können komplexe sprachbezogene Aufgaben mit hoher Genauigkeit ausführen und eröffnen neue Möglichkeiten für die Mensch-Maschine-Interaktion. Ein erhebliches Problem in der NLP ist jedoch die Abhängigkeit der Modellbewertung von menschlichen Annotationen.

Von Menschen generierte Daten sind für das Training und die Validierung von Modellen unerlässlich, doch die Erfassung dieser Daten ist teuer und zeitaufwendig. Darüber hinaus können sich mit der ständigen Verbesserung der Modelle zuvor gesammelte Annotationen veralten und an Nützlichkeit verlieren, wenn es um die Bewertung neuer Modelle geht. Dies führt zu einem kontinuierlichen Bedarf an neuen Daten und stellt die Skalierbarkeit und Nachhaltigkeit einer effektiven Modellbewertung vor Herausforderungen.

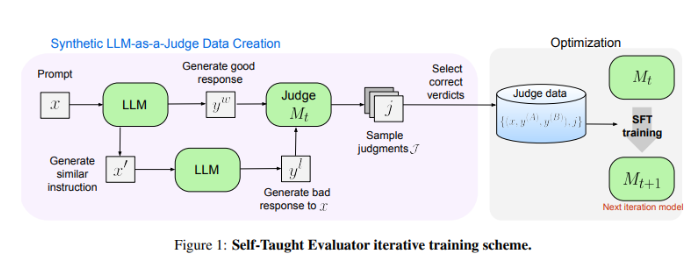

Forscher von Meta FAIR präsentieren eine innovative Lösung: den „Self-Taught Evaluator“ (Selbstlernender Bewerter). Diese Methode verzichtet auf menschliche Annotationen und nutzt stattdessen synthetisch generierte Daten für das Training. Zunächst werden durch ein Seed-Modell kontrastierende synthetische Präferenzpaare generiert. Das Modell bewertet dann diese Paare und verbessert sich iterativ, indem es sein eigenes Urteil nutzt, um die Leistung in nachfolgenden Iterationen zu steigern. Dies reduziert die Abhängigkeit von menschlichen Annotationen erheblich.

Die Forscher testeten die Leistung des „Self-Taught Evaluator“ mit dem Llama-3-70B-Instruct Modell. Die Methode verbesserte die Genauigkeit des Modells auf dem RewardBench-Benchmark von 75,4 auf 88,7 und erreichte sogar die Leistung von Modellen, die mit menschlichen Annotationen trainiert wurden. Nach mehreren Iterationen erreichte das endgültige Modell eine Genauigkeit von 88,3 bei der Einzelinferenz und 88,7 bei Mehrheitsentscheidungen, was seine hohe Stabilität und Zuverlässigkeit unterstreicht.

Der „Self-Taught Evaluator“ bietet eine skalierbare und effiziente Lösung für die Bewertung von NLP-Modellen. Durch die Nutzung synthetischer Daten und iterativer Selbstverbesserung begegnet er den Herausforderungen der Abhängigkeit von menschlichen Annotationen und fördert die Entwicklung von Sprachmodellen.

论文地址:https://arxiv.org/abs/2408.02666

Wichtigste Punkte:

- 😃Die Bewertung von NLP-Modellen hängt von menschlichen Annotationen ab, was zu hohen Kosten, hohem Zeitaufwand und einem Verlust an Nützlichkeit führt.

- 🤖Meta FAIR präsentiert den „Self-Taught Evaluator“, der synthetische Daten zum Training nutzt und die Abhängigkeit von menschlichen Annotationen reduziert.

- 💪Der „Selbstlernende Bewerter“ zeigt eine hervorragende Leistung und verbessert die Modellgenauigkeit in Tests deutlich. Er ist stabil und zuverlässig.