In einer von Daten und Algorithmen dominierten digitalen Welt ist ein Schlüsselelement für das Wachstum der künstlichen Intelligenz der Checkpoint. Stellen Sie sich vor, Sie trainieren ein großes Sprachmodell, das Gedanken lesen und fließend konversieren kann. Dieses Modell ist extrem intelligent, aber auch ein „Vielfraß“, der enorme Rechenressourcen benötigt, um „gesättigt“ zu werden. Bei einem plötzlichen Stromausfall oder Hardwarefehler während des Trainings wären die Verluste enorm. Hier fungiert der Checkpoint wie eine „Zeitmaschine“, die alles in den vorherigen sicheren Zustand zurückversetzen und die unvollendete Aufgabe fortsetzen kann.

Diese „Zeitmaschine“ muss jedoch sorgfältig konstruiert sein. Wissenschaftler von ByteDance und der Universität Hongkong präsentieren in ihrer Arbeit „ByteCheckpoint: A Unified Checkpointing System for LLM Development“ ein völlig neues Checkpoint-System – ByteCheckpoint. Es ist nicht nur ein einfaches Backup-Tool, sondern ein Werkzeug, das die Trainingseffizienz großer Sprachmodelle erheblich steigert.

Zunächst müssen wir die Herausforderungen verstehen, denen große Sprachmodelle (LLMs) gegenüberstehen. Diese Modelle sind „groß“, weil sie riesige Datenmengen verarbeiten und speichern müssen. Dies führt zu hohen Trainingskosten, hohem Ressourcenverbrauch und geringer Fehlertoleranz. Ein Ausfall kann zu einem vollständigen Verlust der langen Trainingszeit führen.

Das Checkpoint-System ist wie eine „Momentaufnahme“ des Modells, die während des Trainings regelmäßig den Status speichert. So kann im Fehlerfall schnell der letzte Status wiederhergestellt und der Verlust minimiert werden. Bestehende Checkpoint-Systeme sind jedoch bei der Verarbeitung großer Modelle oft aufgrund von I/O-Engpässen (Eingabe/Ausgabe) ineffizient.

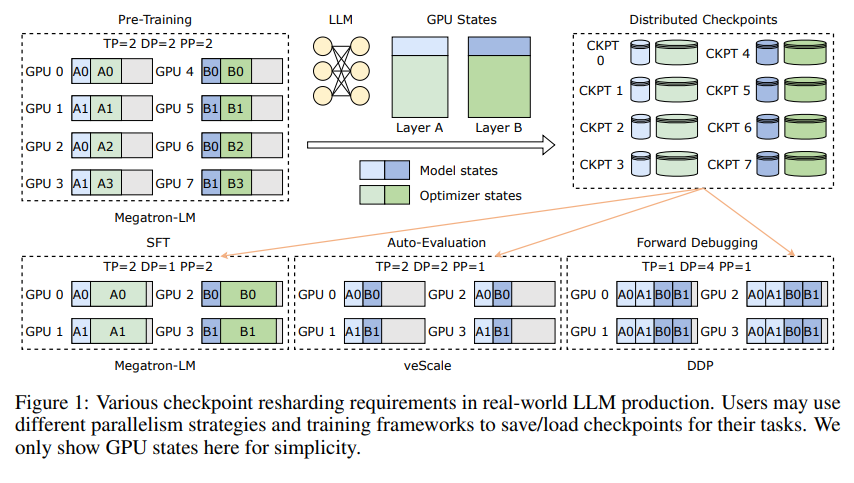

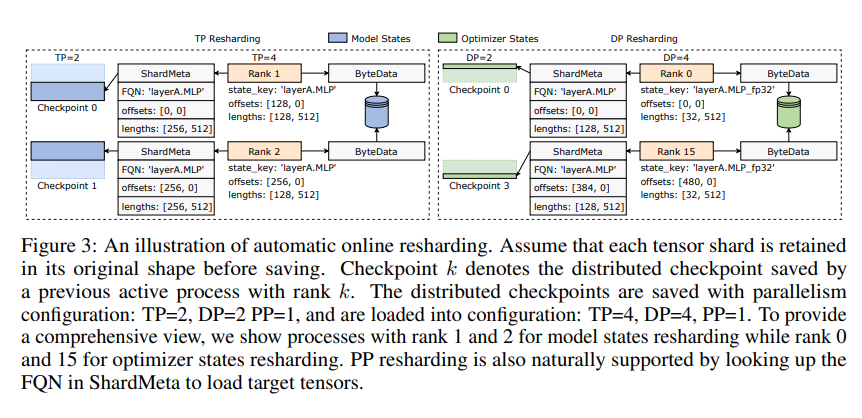

Die Innovation von ByteCheckpoint liegt in einer neuartigen Speicherarchitektur, die Daten und Metadaten trennt und Checkpoints flexibler in verschiedenen parallelen Konfigurationen und Trainingsframeworks verarbeitet. Besonders clever ist die Unterstützung der automatischen Online-Checkpoint-Resharding, die es ermöglicht, Checkpoints dynamisch an verschiedene Hardwareumgebungen anzupassen, ohne das Training zu unterbrechen.

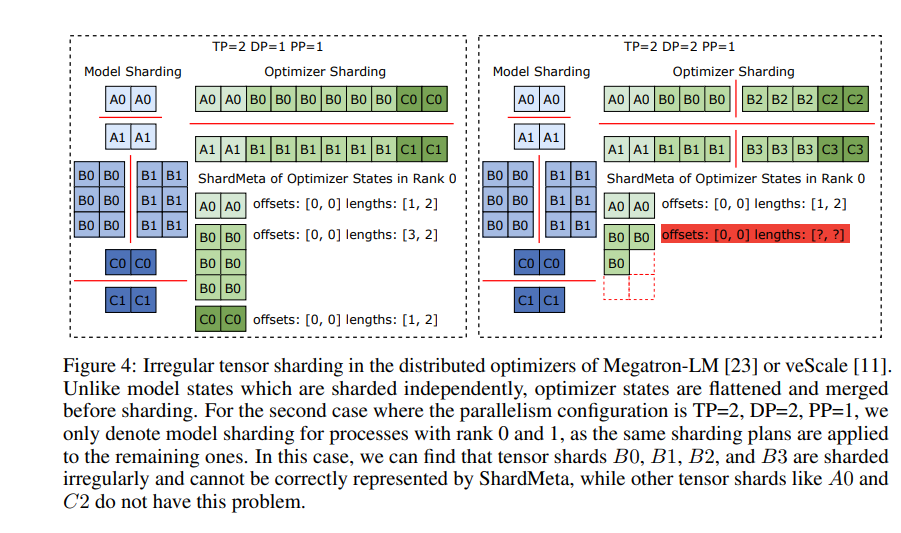

ByteCheckpoint führt außerdem eine Schlüsseltechnologie ein – die asynchrone Tensor-Fusion. Dies ermöglicht die effiziente Verarbeitung von Tensoren, die ungleichmäßig auf verschiedenen GPUs verteilt sind, und stellt sicher, dass die Integrität und Konsistenz des Modells beim Checkpoint-Resharding nicht beeinträchtigt wird.

Um die Geschwindigkeit des Speicherns und Ladens von Checkpoints zu verbessern, integriert ByteCheckpoint eine Reihe von I/O-Performance-Optimierungen, wie z. B. eine feine Save/Load-Pipeline, einen Ping-Pong-Speicherpool, lastenausgeglichenes Speichern und redundanzfreies Laden, wodurch die Wartezeiten während des Trainings erheblich reduziert werden.

Experimentelle Ergebnisse zeigen, dass ByteCheckpoint im Vergleich zu herkömmlichen Methoden die Geschwindigkeit des Speicherns und Ladens von Checkpoints um das Dutzende oder sogar Hunderte Male erhöht und die Trainingseffizienz großer Sprachmodelle deutlich verbessert.

ByteCheckpoint ist nicht nur ein Checkpoint-System, sondern auch ein wertvoller Assistent im Training großer Sprachmodelle und ein Schlüssel zu einem effizienteren und stabileren KI-Training.

论文地址:https://arxiv.org/pdf/2407.20143