Kürzlich hat Alibaba Cloud die bahnbrechende Qwen2-Math-Serie von großen Sprachmodellen vorgestellt, ein auf Mathematik spezialisiertes KI-Talent, das seit seinem Erscheinen große Aufmerksamkeit in der Branche erregt.

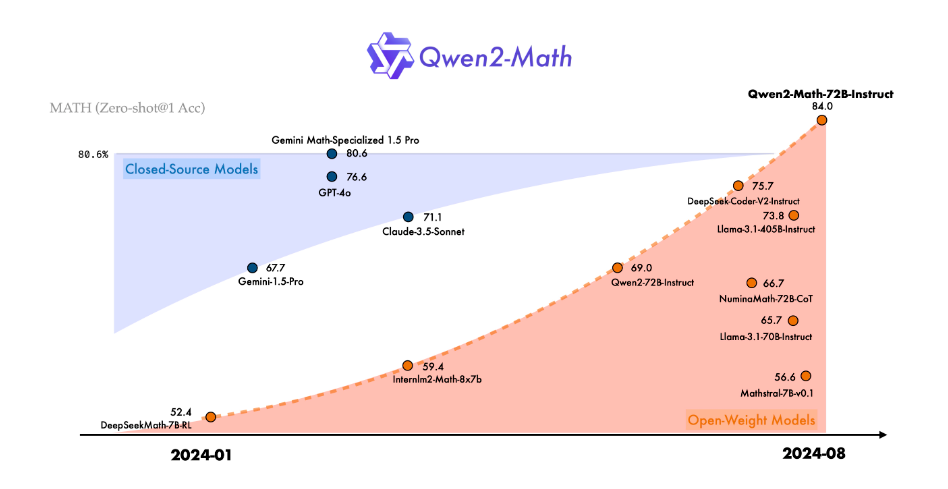

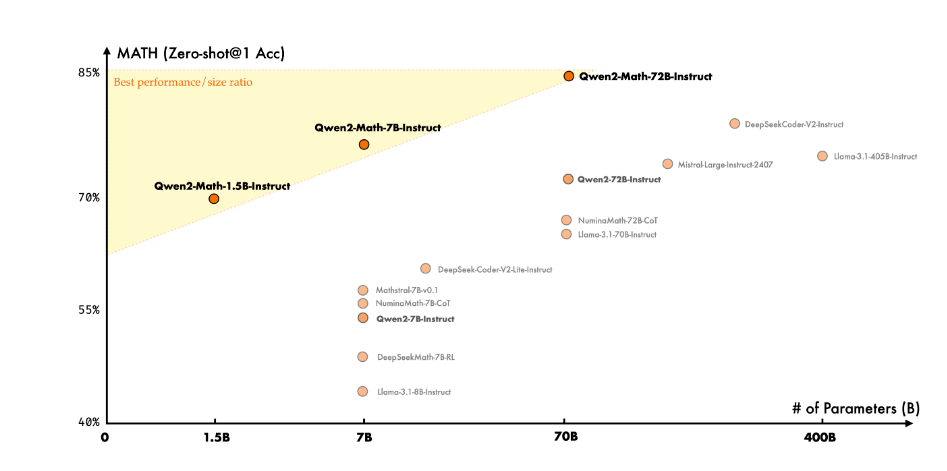

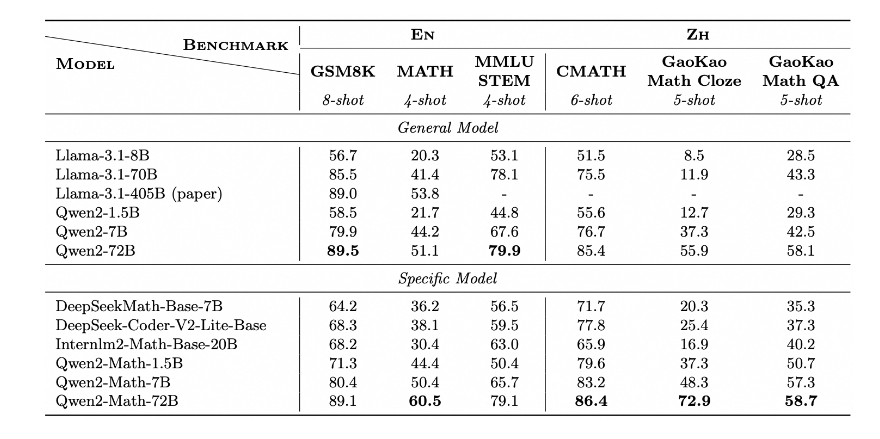

Als jüngstes Mitglied der Qwen2-Serie zeigen die Modelle Qwen2-Math und Qwen2-Math-Instruct-1.5B/7B/72B beeindruckende Fähigkeiten im Lösen mathematischer Probleme. Berichten zufolge übertrifft diese Modellreihe nicht nur bestehende Open-Source-Modelle in mehreren mathematischen Benchmark-Tests, sondern übertrifft in einigen Bereichen sogar bekannte Closed-Source-Modelle wie GPT-4o, Claude-3.5-Sonnet, Gemini-1.5-Pro und Llama-3.1-405B – ein wahres „Dark Horse“ der KI-Mathematik.

Der Erfolg von Qwen2-Math ist kein Zufall. Das Alibaba Cloud-Team hat im letzten Jahr viel Zeit und Mühe investiert, um die Fähigkeit großer Sprachmodelle zur Lösung arithmetischer und mathematischer Probleme zu verbessern. Die Basis dieser Modellreihe bilden Qwen2-1.5B/7B/72B. Darauf aufbauend hat das Entwicklungsteam mithilfe eines sorgfältig zusammengestellten mathematischen Fachkorpus ein Deep-Pre-Training durchgeführt. Dieser einzigartige Korpus umfasst umfangreiche, hochwertige mathematische Online-Texte, Fachbücher, Codebeispiele und eine riesige Anzahl von Prüfungsaufgaben, sogar von Qwen2 selbst generierte mathematische Pre-Training-Daten.

Besonders erwähnenswert ist das Qwen2-Math-Instruct-Modell. Dieses auf Qwen2-Math-72B trainierte mathematische Belohnungsmodell verwendet innovative Trainingsmethoden. Das Entwicklungsteam kombinierte geschickt dichte Belohnungssignale und binäre Signale, die die Richtigkeit der Modellantworten anzeigen. Dieses kombinierte Signal wurde als Überwachungssignal verwendet, um SFT (Supervised Fine-Tuning)-Daten durch Ablehnungsabtastung zu erstellen, und in der Verstärkungslernphase nach SFT wurde die GRPO-Technik (Group Relative Policy Optimization) angewendet. Diese einzigartige Trainingsmethode verbesserte die Fähigkeit des Modells zum Lösen mathematischer Probleme erheblich.

In der Praxis zeigt Qwen2-Math-Instruct beeindruckende Leistungen. Sowohl bei der AIME (American Invitational Mathematics Examination) 2024 als auch bei der AMC (American Mathematics Competition) 2023 erzielte das Modell unter verschiedenen Bedingungen, einschließlich Greedy-Suche, Mehrheitsentscheid und Risikominimierung, hervorragende Ergebnisse.

Noch spannender ist, dass Qwen2-Math auch bei der Lösung einiger Aufgaben auf dem Niveau der Internationalen Mathematikolympiade (IMO) beachtliche Fähigkeiten zeigt. Durch die Analyse einer Reihe von Testfällen stellten die Forscher fest, dass Qwen2-Math nicht nur einfache mathematische Wettbewerbsaufgaben problemlos bewältigen kann, sondern auch bei komplexen Problemen überzeugende Lösungsansätze liefert.

Das Alibaba Cloud-Team ruht sich jedoch nicht auf seinen Lorbeeren aus. Sie gaben bekannt, dass die aktuelle Qwen2-Math-Serie nur Englisch unterstützt, aber sie entwickeln aktiv ein zweisprachiges Modell, das Englisch und Chinesisch unterstützt, und planen, in naher Zukunft eine mehrsprachige Version herauszubringen. Darüber hinaus optimiert das Team das Modell kontinuierlich, um seine Fähigkeit zur Lösung komplexerer und herausfordernder mathematischer Probleme weiter zu verbessern.

Das Erscheinen von Qwen2-Math eröffnet zweifellos neue Möglichkeiten für den Einsatz von KI im Bereich Mathematik. Es wird nicht nur revolutionäre Veränderungen im Bildungsbereich bringen und Schülern helfen, mathematische Kenntnisse besser zu verstehen und zu beherrschen, sondern könnte auch in der Forschung, im Ingenieurwesen und anderen Bereichen, die komplexe mathematische Berechnungen erfordern, eine wichtige Rolle spielen.

Projektseite: https://top.aibase.com/tool/qwen2-math

Modell-Download: https://huggingface.co/Qwen