Der bekannte KI-Forscher Andrej Karpathy hat kürzlich eine kontroverse These aufgestellt: Die derzeit beliebte Technik des Reinforcement Learning from Human Feedback (RLHF) ist möglicherweise kein notwendiger Weg zu einer echten Problemlösungsfähigkeit auf menschlichem Niveau. Diese Aussage hat die aktuelle KI-Forschung stark beeinflusst.

RLHF galt als Schlüsselfaktor für den Erfolg von großen Sprachmodellen (LLMs) wie ChatGPT und wurde als die „Geheimwaffe“ gepriesen, die der KI Verständnis, Gehorsam und natürliche Interaktion verleiht. In traditionellen KI-Trainingsabläufen wird RLHF üblicherweise als letzter Schritt nach dem Pretraining und dem Supervised Fine-Tuning (SFT) eingesetzt. Karpathy hingegen bezeichnet RLHF als „Engpass“ und „Notlösung“ und glaubt, dass es bei weitem nicht die ultimative Lösung für die KI-Entwicklung ist.

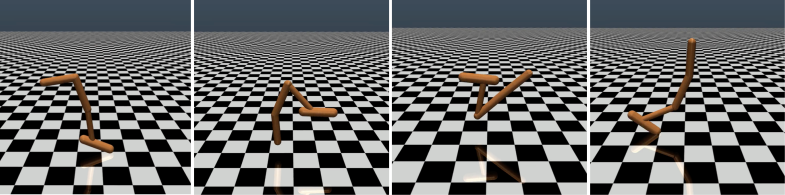

Karpathy vergleicht RLHF geschickt mit DeepMinds AlphaGo. AlphaGo nutzte, wie er es nennt, „echtes RL“ (Reinforcement Learning), indem es ständig gegen sich selbst spielte und seine Gewinnrate maximierte, um schließlich ohne menschliches Eingreifen Top-Spieler zu übertreffen. Diese Methode lernte durch die Optimierung des neuronalen Netzes direkt aus den Spielergebnissen und erreichte eine übermenschliche Leistung.

Im Gegensatz dazu sieht Karpathy RLHF eher als Nachahmung menschlicher Präferenzen denn als echte Problemlösung. Er stellt sich vor, dass bei AlphaGo mit RLHF menschliche Bewerter eine große Anzahl von Spielsituationen vergleichen und ihre Präferenzen auswählen müssten – möglicherweise 100.000 Vergleiche, um ein „Belohnungsmodell“ zu trainieren, das die menschliche „Atmosphäre“ nachahmt. Diese auf „Atmosphäre“ basierende Bewertung könnte jedoch in einem präzisen Spiel wie Go zu irreführenden Ergebnissen führen.

Ähnlich verhält es sich mit den aktuellen Belohnungsmodellen von LLMs – sie tendieren dazu, Antworten höher zu bewerten, die statistisch gesehen den menschlichen Bewertern zu gefallen scheinen. Dies ähnelt eher einer Anpassung an oberflächliche menschliche Vorlieben als einer echten Problemlösungsfähigkeit. Besorgniserregender ist, dass das Modell schnell lernen könnte, diese Belohnungsfunktion auszunutzen, anstatt seine eigenen Fähigkeiten zu verbessern.

Karpathy weist darauf hin, dass Reinforcement Learning in geschlossenen Umgebungen wie Go hervorragend funktioniert, aber für offene Sprach-Aufgaben echtes Reinforcement Learning immer noch schwer zu implementieren ist. Dies liegt vor allem daran, dass in offenen Aufgaben klare Ziele und Belohnungsmechanismen schwer zu definieren sind. „Wie kann man objektive Belohnungen für Aufgaben wie das Zusammenfassen eines Artikels, das Beantworten einer vagen Frage zur Pip-Installation, das Erzeugen eines Witzes oder das Umschreiben von Java-Code in Python definieren?“, fragt Karpathy nachdenklich. „Diese Richtung ist prinzipiell nicht unmöglich, aber auch alles andere als einfach; sie erfordert kreatives Denken.“

Dennoch glaubt Karpathy, dass Sprachmodelle, wenn dieses Problem gelöst werden kann, die Problemlösungsfähigkeit von Menschen tatsächlich erreichen oder sogar übertreffen könnten. Diese Ansicht deckt sich mit einer kürzlich von Google DeepMind veröffentlichten Arbeit, die besagt, dass Offenheit die Grundlage für Künstliche Allgemeine Intelligenz (AGI) ist.

Als einer von mehreren hochrangigen KI-Experten, die OpenAI in diesem Jahr verlassen haben, arbeitet Karpathy derzeit an seinem eigenen KI-Bildungs-Startup. Seine Aussagen haben der KI-Forschung zweifellos neue Denkansätze hinzugefügt und wertvolle Einblicke in die zukünftige KI-Entwicklung geliefert.

Karpathys Ansicht hat in der Branche eine breite Diskussion ausgelöst. Befürworter meinen, er habe ein zentrales Problem der aktuellen KI-Forschung aufgezeigt: wie man KI tatsächlich die Fähigkeit verleiht, komplexe Probleme zu lösen, anstatt nur menschliches Verhalten nachzuahmen. Gegner befürchten, dass ein zu frühes Aufgeben von RLHF zu einer Fehlentwicklung der KI führen könnte.

论文地址:https://arxiv.org/pdf/1706.03741