In Zeiten, in denen Technologieunternehmen das Rennen um die Implementierung von künstlicher Intelligenz auf Geräten machen, entstehen immer mehr kleine Sprachmodelle (SLMs), die auf ressourcenbeschränkten Geräten laufen können. Kürzlich hat das Nvidia-Forschungsteam mit Hilfe modernster Techniken zum Modellbeschneiden und zur Destillation Llama-3.1-Minitron4B vorgestellt, eine komprimierte Version des Llama3-Modells. Dieses neue Modell kann nicht nur mit größeren Modellen mithalten, sondern auch mit gleich großen kleinen Modellen konkurrieren und ist gleichzeitig effizienter in der Ausbildung und Bereitstellung.

Beschneiden und Destillation sind zwei Schlüsseltechniken zur Erstellung kleinerer, effizienterer Sprachmodelle. Beschneiden bedeutet, unwichtige Teile des Modells zu entfernen, einschließlich „Tiefenbeschneidung“ – das Entfernen ganzer Schichten – und „Breitenbeschneidung“ – das Entfernen bestimmter Elemente wie Neuronen und Attention Heads. Modelldestillation hingegen überträgt Wissen und Fähigkeiten von einem großen Modell (dem „Lehrermodell“) auf ein kleineres, einfacheres „Schülermodell“.

Es gibt hauptsächlich zwei Arten der Destillation: Erstens das „SGD-Training“, bei dem das Schülermodell die Eingaben und Antworten des Lehrermodells lernt, und zweitens die „klassische Wissensdestillation“, bei der das Schülermodell neben dem Ergebnis auch die internen Aktivierungen des Lehrermodells lernt.

In einer früheren Studie gelang es den Nvidia-Forschern, das Nemotron15B-Modell durch Beschneiden und Destillation auf ein Modell mit 800 Millionen Parametern zu reduzieren und es dann weiter auf 400 Millionen Parameter zu verkleinern. Dieser Prozess verbesserte nicht nur die Leistung im bekannten MMLU-Benchmark um 16 %, sondern benötigte auch 40-mal weniger Trainingsdaten als ein Training von Grund auf.

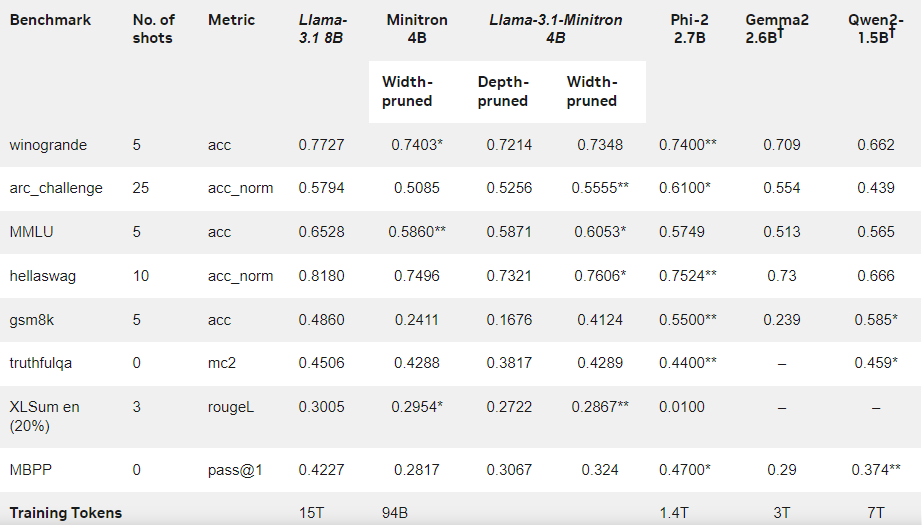

Diesmal hat das Nvidia-Team auf der Grundlage des Llama3.18B-Modells mit der gleichen Methode ein Modell mit 400 Millionen Parametern erstellt. Zuerst haben sie ein unbeschnittenes 8B-Modell auf einem Datensatz mit 940 Milliarden Token feinabgestimmt, um Unterschiede in der Verteilung zwischen Trainingsdaten und Destillationsdatensatz zu berücksichtigen. Anschließend wurden Tiefenbeschneidung und Breitenbeschneidung angewendet, um zwei verschiedene Versionen von Llama-3.1-Minitron4B zu erhalten.

Die Forscher haben das beschnittene Modell mit NeMo-Aligner feinabgestimmt und seine Fähigkeiten in Bezug auf Anweisungsfolge, Rollenspiel, Retrieval-Augmented Generation (RAG) und Funktionsaufrufe bewertet.

Die Ergebnisse zeigen, dass Llama-3.1-Minitron4B trotz des geringeren Umfangs der Trainingsdaten eine Leistung erzielt, die anderen kleinen Modellen nahekommt und hervorragende Ergebnisse liefert. Die Breitenbeschneidungsversion des Modells wurde auf Hugging Face veröffentlicht und steht für kommerzielle Zwecke zur Verfügung, damit mehr Benutzer und Entwickler von seiner Effizienz und Leistung profitieren können.

Offizieller Blog: https://developer.nvidia.com/blog/how-to-prune-and-distill-llama-3-1-8b-to-an-nvidia-llama-3-1-minitron-4b-model/

Highlights:

🌟 Llama-3.1-Minitron4B ist ein kleines Sprachmodell von Nvidia, das auf Beschneidungs- und Destillationstechniken basiert und sich durch effizientes Training und Bereitstellung auszeichnet.

📈 Das Modell benötigte im Trainingsprozess 40-mal weniger Token als ein Training von Grund auf, erzielte aber dennoch eine deutlich verbesserte Leistung.

🔓 Die Breitenbeschneidungsversion wurde auf Hugging Face veröffentlicht und steht für kommerzielle Nutzung und Entwicklung zur Verfügung.