Das bekannte chinesische KI-Unternehmen Unisound gab am 23. August 2024 in Peking die Veröffentlichung seines neuesten Entwicklungsergebnisses bekannt – das Shanhai Multimodale Großsprachenmodell.

Das Shanhai Multimodale Großsprachenmodell ist Teil der Unisound Atlas KI-Infrastruktur. Es kann Eingaben in verschiedenen Modalitäten wie Text, Audio und Bildern verarbeiten und in Echtzeit beliebige Kombinationen von Text-, Audio- und Bildausgaben generieren. Diese Fähigkeit ermöglicht es dem Shanhai-Modell nicht nur, effiziente Sprachinteraktionen durchzuführen, sondern auch ein nahezu natürlichsprachliches und flüssiges Gesprächserlebnis zu bieten.

Das Modell verfügt über hochentwickelte Fähigkeiten zur intelligenten Sprachinteraktion. Es reagiert in Echtzeit auf Benutzeranweisungen, unterstützt das Unterbrechen von Gesprächen und kann Emotionen erkennen und ausdrücken, um eine emotionale Verbindung mit dem Benutzer aufzubauen. Darüber hinaus kann das Shanhai-Modell die Stimmlage frei wechseln und so ein individuelles Klangerlebnis nach den Wünschen des Benutzers schaffen.

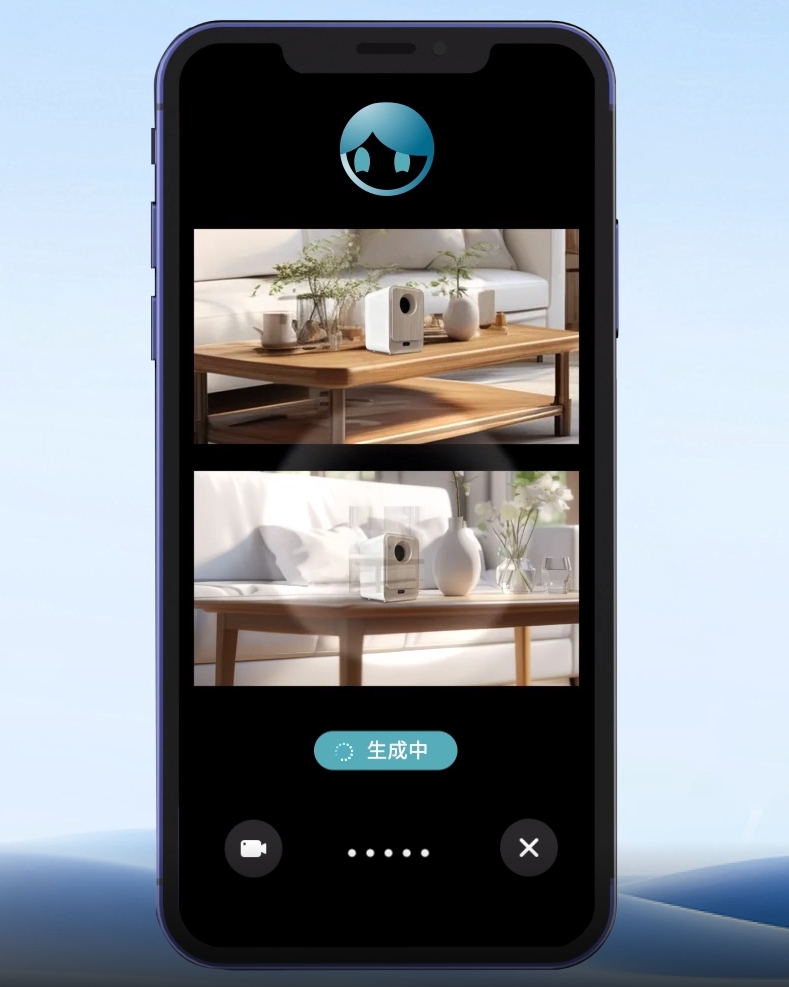

Im Bereich der visuellen Interaktion kann das Shanhai-Modell über eine Kamera die Umgebung verstehen und beschreiben, eine präzise Objekterkennung und Szenenanalyse durchführen. Es kann auch auf Benutzeranweisungen schnell visuelle Inhalte erstellen und ein personalisiertes visuelles Erlebnis bieten.

Unisound erklärte, dass die Einführung des Shanhai multimodalen Großsprachenmodells den neuen Kern der Unternehmenstechnologieplattform „Yunzhi Brain“ bildet und sowohl im Bereich des intelligenten Lebens als auch der intelligenten Medizin reichhaltigere und effizientere Produkte und Lösungen liefern wird. Seit seiner Veröffentlichung im Mai 2023 hat das Shanhai-Modell bei mehreren renommierten Wettbewerben zahlreiche Preise gewonnen und seine umfassenden allgemeinen und hervorragenden Fachkenntnisse unter Beweis gestellt.

Testversion:https://shanhai.unisound.com/