Kürzlich haben NVIDIA und ein Forschungsteam der Georgia Tech, UMD und HKPU ein neues visuell-sprachliches Modell vorgestellt – NVEagle. Es kann Bilder verstehen und mit Ihnen chatten, was es zu einem überaus hilfreichen Assistenten macht, der sehen und sprechen kann.

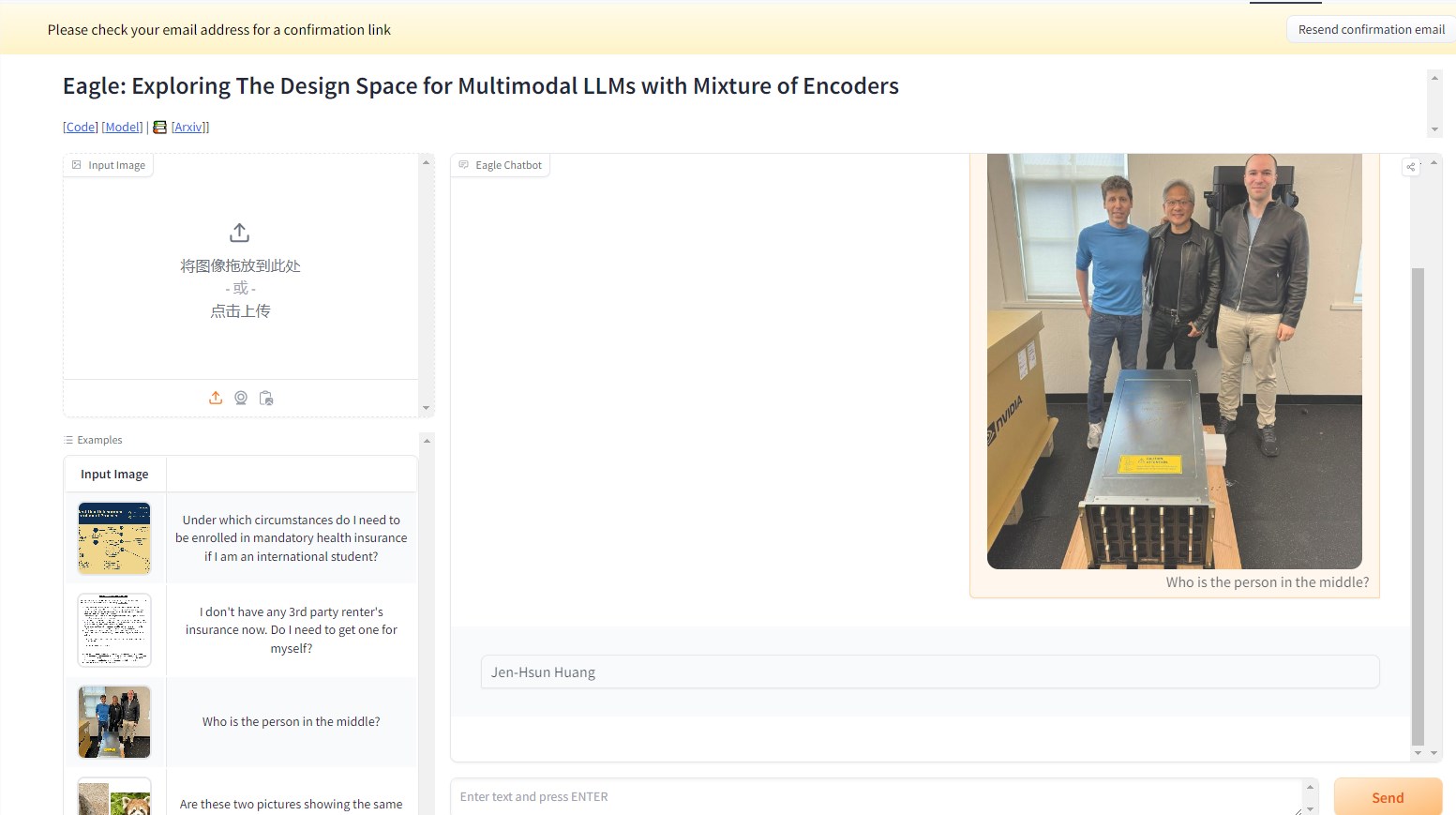

Im folgenden Beispiel wird das NVEagle-Modell gefragt, wer die Person auf dem Bild ist. Das Modell interpretiert das Bild und antwortet korrekt: Jensen Huang.

Dieses multimodale große Sprachmodell (MLLM) stellt einen wichtigen Schritt in der Kombination von visuellen und sprachlichen Informationen dar. NVEagle kann komplexe reale Szenarien verstehen und durch visuelle Eingaben besser interpretieren und darauf reagieren. Kern seiner Gestaltung ist die Umwandlung von Bildern in visuelle Markierungen, die dann mit Text-Einbettungen kombiniert werden, um das Verständnis visueller Informationen zu verbessern.

Der Aufbau eines so leistungsstarken Modells ist jedoch mit einigen Herausforderungen verbunden, insbesondere bei der Verbesserung der visuellen Wahrnehmung. Studien zeigen, dass viele bestehende Modelle bei der Verarbeitung hochauflösender Bilder „Halluzinationen“ aufweisen, d. h. ungenaue oder sinnlose Ausgaben erzeugen. Dies ist bei Aufgaben, die eine detaillierte Analyse erfordern, wie z. B. optische Zeichenerkennung (OCR) und Dokumentenverständnis, besonders deutlich. Um diese Schwierigkeiten zu überwinden, hat das Forschungsteam verschiedene Methoden erforscht, darunter das Testen verschiedener visueller Encoder und Fusionsstrategien.

NVEagle ist das Ergebnis dieser Forschung und umfasst drei Versionen: Eagle-X5-7B, Eagle-X5-13B und Eagle-X5-13B-Chat. Die 7B- und 13B-Versionen werden hauptsächlich für allgemeine visuell-sprachliche Aufgaben verwendet, während die 13B-Chat-Version speziell für dialogorientierte KI optimiert wurde und eine bessere Interaktion auf der Grundlage visueller Eingaben ermöglicht.

Ein Highlight von NVEagle ist die Verwendung eines Mixture-of-Experts (MoE)-Mechanismus, der es ermöglicht, je nach Aufgabe den am besten geeigneten visuellen Encoder dynamisch auszuwählen. Dies verbessert die Verarbeitung komplexer visueller Informationen erheblich. Das Modell wurde auf Hugging Face veröffentlicht und steht Forschern und Entwicklern zur Verfügung.

In verschiedenen Benchmark-Tests zeigte das Eagle-Modell eine hervorragende Leistung. Beispielsweise erzielte das Eagle-Modell im OCR-Benchmark auf OCRBench einen Durchschnitt von 85,9 Punkten und übertraf damit andere führende Modelle wie InternVL und LLaVA-HR. Im TextVQA-Test erreichte es einen Wert von 88,8 und zeigte auch bei komplexen visuellen Frage-Antwort-Aufgaben eine gute Leistung mit einem GQA-Testwert von 65,7. Darüber hinaus verbesserte sich die Leistung des Modells durch Hinzufügen zusätzlicher visueller Experten weiter.

Die NVEagle-Modellreihe hat durch systematische Designforschung und -optimierung mehrere wichtige Herausforderungen in der visuellen Wahrnehmung erfolgreich gelöst und neue Wege für die Entwicklung visuell-sprachlicher Modelle eröffnet.

Projektseite: https://top.aibase.com/tool/eagle

Demo: https://huggingface.co/spaces/NVEagle/Eagle-X5-13B-Chat

Wichtigste Punkte:

🌟 NVEagle ist ein neues visuell-sprachliches Modell von NVIDIA, das darauf abzielt, das Verständnis komplexer visueller Informationen zu verbessern.

📈 Das Modell umfasst drei Versionen für verschiedene Aufgaben, wobei die 13B-Chat-Version auf dialogorientierte KI ausgerichtet ist.

🏆 In mehreren Benchmark-Tests übertraf das Eagle-Modell viele bestehende führende Modelle und zeigte eine herausragende Leistung.