Das kürzlich erschienene Open-Source-KI-Modell Reflection70B ist in der Branche auf breite Kritik gestoßen.

Das von dem New Yorker Startup HyperWrite veröffentlichte Modell, das sich selbst als eine Variante von Metas Llama 3.1 bezeichnet, hatte zuvor durch seine hervorragenden Ergebnisse in Drittanbieter-Tests Aufmerksamkeit erregt. Mit der Veröffentlichung weiterer Testergebnisse wurde der Ruf von Reflection70B jedoch in Frage gestellt.

Auslöser war eine Ankündigung von Matt Shumer, Mitbegründer und CEO von HyperWrite, am 6. September auf X (ehemals Twitter), in der er Reflection70B als „stärkstes Open-Source-Modell der Welt“ bezeichnete.

Shumer stellte auch die „Reflexion-Optimierungstechnik“ des Modells vor und behauptete, diese Methode ermögliche es dem Modell, sich selbst vor der Generierung von Inhalten zu überprüfen und so die Genauigkeit zu verbessern.

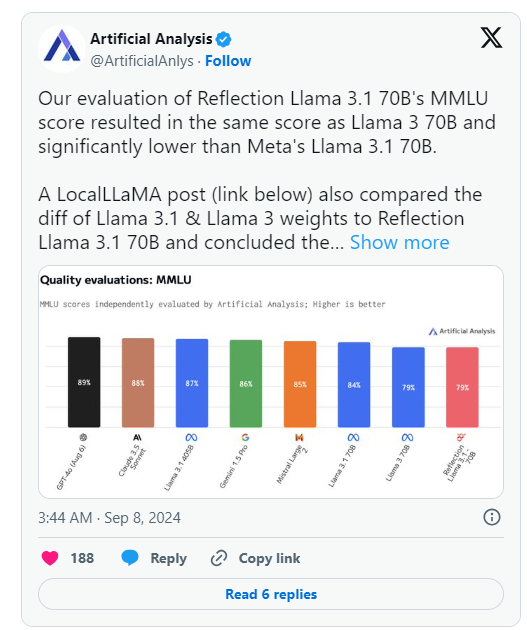

Am Tag nach der Ankündigung von HyperWrite veröffentlichte jedoch Artificial Analysis, eine Organisation, die „unabhängige Analysen von KI-Modellen und Hosting-Anbietern“ durchführt, auf X eine eigene Analyse. Diese ergab, dass der MMLU-Score (Massive Multitask Language Understanding) des von ihnen bewerteten Reflection Llama 3.1 70B mit dem von Llama 3 70B identisch, aber deutlich niedriger als der von Metas Llama 3.1 70B war. Dies widersprach stark den ursprünglich von HyperWrite/Shumer veröffentlichten Ergebnissen.

Shumer erklärte daraufhin, dass es bei der Übertragung der Gewichte (oder der Einstellungen des Open-Source-Modells) auf Hugging Face (ein Drittanbieter-Repository und Unternehmen für KI-Code) zu Problemen gekommen sei, was möglicherweise zu einer geringeren Leistung im Vergleich zur „internen API“-Version von HyperWrite geführt habe.

Artificial Analysis erklärte in einer späteren Stellungnahme, dass sie Zugriff auf die private API erhalten hätten und eine beeindruckende Leistung gesehen hätten, die jedoch nicht dem ursprünglichen Anspruch entsprach. Da dieser Test über die private API durchgeführt wurde, konnten sie den getesteten Inhalt nicht unabhängig verifizieren.

Die Organisation stellte zwei Schlüsselfragen, die die ursprünglichen Leistungsangaben von HyperWrite und Shumer stark in Frage stellen:

- Warum wurde nicht die Version veröffentlicht, die sie über die private Reflection-API getestet hatten?

- Warum wurden die Modellgewichte der von ihnen getesteten Version noch nicht veröffentlicht?

Gleichzeitig stellten mehrere Benutzer in den Machine-Learning- und KI-Communitys auf Reddit die behauptete Leistung und die Herkunft von Reflection70B in Frage. Einige wiesen darauf hin, dass Reflection70B nach Vergleichen von Modellen, die von Drittanbietern auf Github veröffentlicht wurden, scheinbar eine Variante von Llama 3 und nicht von Llama 3.1 ist, was die ursprünglichen Behauptungen von Shumer und HyperWrite weiter in Zweifel zieht.

Dies führte dazu, dass mindestens ein X-Nutzer, Shin Megami Boson, am 8. September um 20:07 Uhr MESZ öffentlich Shumer des „Betrugs“ in der KI-Forschungsgemeinschaft beschuldigte und eine lange Reihe von Screenshots und anderer Beweise veröffentlichte.

Andere beschuldigten das Modell, tatsächlich ein „Wrapper“ oder eine Anwendung zu sein, die auf dem proprietären/geschlossenen Quellcode des Konkurrenzprodukts Anthropic Claude 3 basiert.

Es gab jedoch auch andere X-Nutzer, die sich für Shumer und Reflection70B einsetzten, und einige veröffentlichten auch beeindruckende Leistungsdaten des Modells von ihrer Seite.

Derzeit wartet die KI-Forschungsgemeinschaft auf eine Antwort Shumers auf diese Betrugsvorwürfe und auf aktualisierte Modellgewichte auf Hugging Face.

🚀 Nach der Veröffentlichung des Reflection70B-Modells wurde dessen Leistung in Frage gestellt, da die Testergebnisse die anfänglichen Leistungsangaben nicht bestätigten.

⚙️ Der Gründer von HyperWrite erklärte, dass Probleme beim Hochladen des Modells zu Leistungseinbußen geführt hätten, und forderte zur Beachtung der aktualisierten Version auf.

👥 Die Diskussionen über das Modell in den sozialen Medien sind lebhaft, mit sowohl Kritik als auch Verteidigung, was die Situation komplex macht.