Vor dem Hintergrund der schnell fortschreitenden Technologie der Sprachsynthese nimmt die Sprachfälschung immer mehr zu und stellt eine erhebliche Bedrohung für die Privatsphäre der Nutzer und die öffentliche Sicherheit dar. Kürzlich haben das Labor für intelligente Systemsicherheit der Zhejiang-Universität und die Tsinghua-Universität gemeinsam einen neuartigen Rahmen zur Erkennung von Sprachfälschungen namens „SafeEar“ veröffentlicht.

Dieser Rahmen zielt darauf ab, eine effiziente Fälschungserkennung bei gleichzeitigem Schutz der Privatsphäre von Sprachinhalten zu gewährleisten und den Herausforderungen der Sprachsynthese zu begegnen.

Die Idee von SafeEar besteht darin, durch die Entwicklung eines entkoppelten Modells auf Basis neuronaler Audio-Codec die akustischen und semantischen Informationen der Sprache geschickt voneinander zu trennen. Das bedeutet, dass SafeEar zur Fälschungserkennung nur auf akustische Informationen angewiesen ist und nicht auf den vollständigen Inhalt des Tons zugreifen muss, wodurch ein effektiver Schutz vor Datenschutzverletzungen gewährleistet wird.

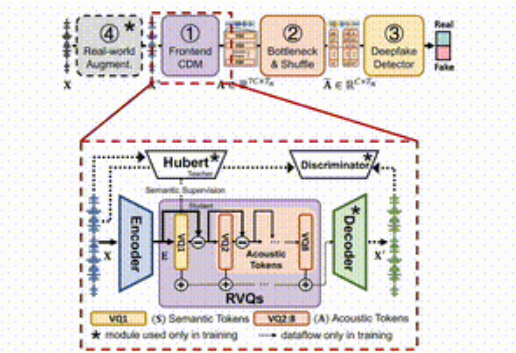

Der gesamte Rahmen besteht aus vier Hauptteilen.

Zuerst extrahiert das Frontend-Entkopplungsmodell die Ziel-Akustikmerkmale aus der eingegebenen Sprache; zweitens erhöhen die Engpass- und die Verschleierungsschicht durch Dimensionsreduktion und das Durcheinanderbringen der akustischen Merkmale die Widerstandsfähigkeit gegen den Diebstahl von Inhalten; drittens verwendet der Fälschungserkennungsdetektor einen Transformer-Klassifikator, um zu bestimmen, ob Audio gefälscht wurde; und schließlich verbessert der Modul zur Verstärkung der realen Umgebung durch die Simulation verschiedener Audio-Umgebungen die Erkennungsleistung des Modells.

Projekt-Link:https://github.com/LetterLiGo/SafeEar?tab=readme-ov-file

In Experimenten mit mehreren Benchmark-Datensätzen stellte das Forschungsteam fest, dass die Fehlerrate von SafeEar bei nur 2,02 % liegt. Das bedeutet, dass es bei der Erkennung von Deepfake-Audios sehr effektiv ist! Darüber hinaus kann SafeEar Audioinhalte in fünf Sprachen schützen, so dass sie weder von Maschinen noch von menschlichen Ohren leicht analysiert werden können, mit einer Wortfehlerrate von bis zu 93,93 %. Gleichzeitig stellten die Forscher durch Tests fest, dass Angreifer die geschützten Sprachinhalte nicht wiederherstellen können, was die Vorteile dieser Technologie im Hinblick auf den Datenschutz zeigt.

Darüber hinaus hat das SafeEar-Team einen Datensatz mit 1,5 Millionen mehrsprachigen Audiodaten erstellt, der Englisch, Chinesisch, Deutsch, Französisch und Italienisch umfasst und eine reiche Grundlage für zukünftige Forschung und Erkennung von Sprachfälschungen bietet.

Die Einführung von SafeEar bietet nicht nur neue Lösungen für die Erkennung von Sprachfälschungen, sondern ebnet auch den Weg zum Schutz der Privatsphäre der Nutzer.

Wichtigste Punkte:

- 🎤 **Innovativer Rahmen von SafeEar**: Erkennt Deepfake-Audios, ohne Sprachinhalte preiszugeben und schützt so die Privatsphäre der Nutzer.

- 🔍 **Multi-Head-Self-Attention-Mechanismus**: Verbessert die Fähigkeit zur Erkennung von Deepfake-Audios ohne semantische Hinweise, mit einer Fehlerrate von nur 2,02 %.

- 🔒 **Schutz von Audioinhalten**: Schützt effektiv Audioinhalte in mehreren Sprachen vor der Analyse, mit einer Wortfehlerrate von bis zu 93,93 %.