Kürzlich hat Google ein neues Modell namens „gemma-2-2b-jpn-it“ vorgestellt, das jüngste Mitglied der Gemma-Serie von Sprachmodellen. Dieses Modell wurde speziell für die japanische Sprache optimiert und zeigt das anhaltende Engagement von Google im Bereich der großen Sprachmodelle (LLM).

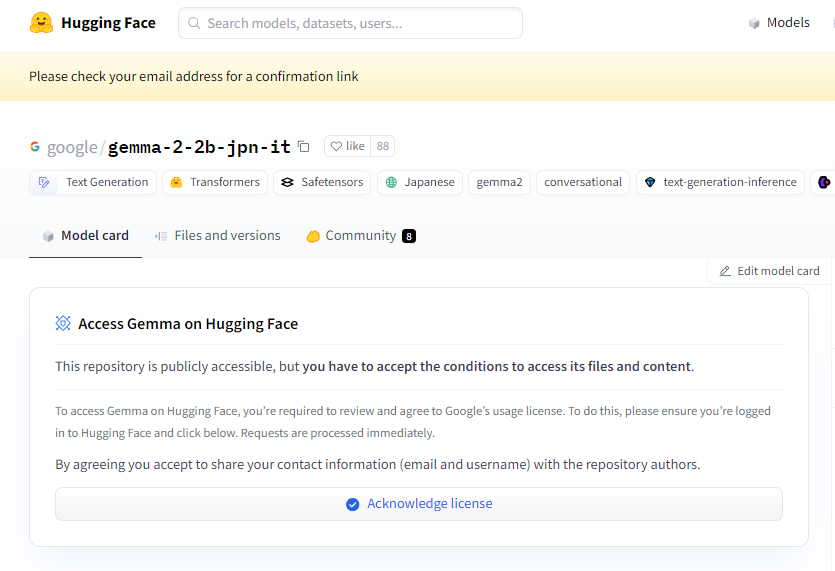

Projektseite: https://huggingface.co/google/gemma-2-2b-jpn-it

gemma-2-2b-jpn-it ist ein Decoder-basiertes großes Sprachmodell für Text-zu-Text-Aufgaben mit offenen Gewichten. Dies bedeutet, dass es öffentlich zugänglich ist und für verschiedene Textgenerierungsaufgaben feinabgestimmt werden kann, wie z. B. Frage-Antwort-Systeme, Zusammenfassung und Schlussfolgerungen.

Das neue Modell verfügt über 2,61 Milliarden Parameter und verwendet den BF16-Tensortyp. Es basiert auf der Google Gemini-Modellarchitektur und bietet fortschrittliche technische Dokumentation und Ressourcen. Entwickler können es einfach über Inferenz in verschiedene Anwendungen integrieren. Besonders erwähnenswert ist die Kompatibilität mit Googles neuester TPU-Hardware, insbesondere der TPUv5p. Diese Hardware bietet eine enorme Rechenleistung, die zu schnelleren Trainingszeiten und besserer Leistung führt, verglichen mit traditionellen CPU-Infrastrukturen.

Softwareseitig wird gemma-2-2b-jpn-it mit den Frameworks JAX und ML Pathways trainiert. JAX ist speziell für Hochleistungs-Machine-Learning-Anwendungen optimiert, während ML Pathways eine flexible Plattform für die Organisation des gesamten Trainingsprozesses bietet. Diese Kombination ermöglicht Google einen effizienten Trainingsworkflow.

Mit der Veröffentlichung von gemma-2-2b-jpn-it wird sein Anwendungspotenzial in verschiedenen Bereichen stark beachtet. Das Modell kann in der Inhaltserstellung und Kommunikation glänzen, z. B. bei der Generierung von Gedichten, Drehbüchern, Code, Marketingtexten oder Antworten für Chatbots. Seine Textgenerierungsfähigkeiten eignen sich auch hervorragend für Zusammenfassungen, um große Textmengen in prägnante Zusammenfassungen zu kondensieren – ideal für Forschung, Bildung und Wissensfindung.

gemma-2-2b-jpn-it hat jedoch auch Einschränkungen, die Benutzer kennen sollten. Die Leistung des Modells hängt von der Vielfalt und Qualität seiner Trainingsdaten ab. Vorurteile oder Lücken in den Daten können die Antworten des Modells beeinflussen. Da große Sprachmodelle keine integrierte Wissensdatenbank besitzen, können bei der Bearbeitung komplexer Anfragen ungenaue oder veraltete Fakten generiert werden.

Während der Entwicklung hat Google ethische Aspekte stark berücksichtigt und gemma-2-2b-jpn-it einer strengen Bewertung unterzogen, um Probleme im Zusammenhang mit der Sicherheit von Inhalten, Repräsentationsverletzungen und dem Erinnern von Trainingsdaten zu bewältigen. Google hat außerdem Filtertechniken implementiert, um schädliche Inhalte auszuschließen, und einen transparenten und rechenschaftspflichtigen Rahmen geschaffen, der Entwickler dazu ermutigt, die Einhaltung der Datenschutzbestimmungen durch kontinuierliche Überwachung und den Einsatz von Datenschutztechnologien zu gewährleisten.

Wichtigste Punkte:

🌟 Das von Google entwickelte Modell gemma-2-2b-jpn-it ist speziell für die japanische Sprache optimiert und verfügt über 2,61 Milliarden Parameter sowie eine fortschrittliche Architektur.

💡 Das Modell hat ein großes Anwendungspotenzial in der Inhaltserstellung und der Verarbeitung natürlicher Sprache und unterstützt verschiedene Textgenerierungsaufgaben.

🔒 Google hat bei der Modellentwicklung ethische Aspekte berücksichtigt und Sicherheitsfilter für Inhalte sowie Datenschutzmaßnahmen implementiert, um Risiken zu minimieren.