In der Welt der KI sind Daten wie Goldminen – je reicher, desto glänzender. LLM360 hat kürzlich einen bemerkenswerten Datensatz namens TxT360 vorgestellt, der speziell für das Training großer Sprachmodelle entwickelt wurde. Dieser Gigant enthält nicht nur hochwertige Textdaten aus allen Branchen, sondern wurde auch einer umfassenden Bereinigung unterzogen und umfasst schließlich 5,7 Billionen hochwertige Tokens – eine wahre „Schatzkiste der Daten“!

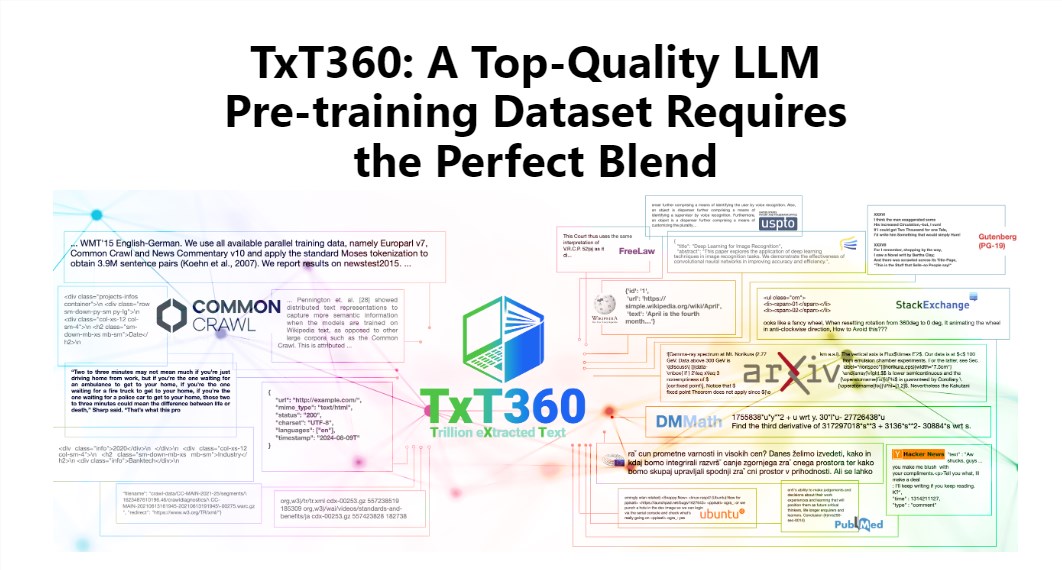

Der Reiz von TxT360 liegt in seiner enormen Größe und hohen Qualität, womit er bestehende Datensätze wie FineWeb und RedPajama übertrifft. Dieser Datensatz extrahiert die Essenz des Internets aus 99 Common Crawl-Snapshots und enthält zusätzlich 14 sorgfältig ausgewählte hochwertige Datenquellen, wie z. B. juristische Dokumente und Enzyklopädien. Dadurch ist der Inhalt nicht nur vielfältig, sondern auch äußerst zuverlässig.

Noch beeindruckender ist, dass TxT360 den Benutzern eine „Datengewichtungsformel“ bietet, mit der sie die Gewichtung verschiedener Datenquellen nach ihren Bedürfnissen anpassen können. Das ist vergleichbar mit dem Kochen, bei dem man verschiedene Zutaten nach Geschmack kombinieren kann, um sicherzustellen, dass jedes Gericht köstlich ist.

Die Deduplizierungstechnologie ist natürlich auch ein Highlight von TxT360. Durch komplexe Deduplizierungsverfahren behebt dieser Datensatz effektiv Datenredundanz und Informationswiederholungen im Trainingsprozess und stellt sicher, dass jedes Token einzigartig ist. Gleichzeitig hat das Projektteam mithilfe regulärer Ausdrücke geschickt persönliche Informationen wie E-Mail-Adressen und IP-Adressen aus den Dokumenten entfernt, um die Datenprivatsphäre und -sicherheit zu gewährleisten.

Das Design von TxT360 konzentriert sich nicht nur auf die Größe, sondern auch auf die Qualität. Durch die Kombination der Vorteile von Webdaten und ausgewählten Datenquellen können Forscher die Verwendung und Verteilung der Daten präzise steuern – wie mit einer Fernbedienung, mit der man die Datenverhältnisse beliebig anpassen kann.

Auch in Bezug auf die Trainingsergebnisse steht TxT360 seinen Konkurrenten in nichts nach. Durch eine einfache Oversampling-Strategie wurde die Datenmenge erheblich erhöht und letztendlich ein Datensatz mit über 15 Billionen Tokens erstellt. In einer Reihe wichtiger Bewertungsmetriken übertrifft TxT360 FineWeb, insbesondere in Bereichen wie MMLU und NQ, und zeigt damit außergewöhnliche Lernfähigkeiten. In Kombination mit Code-Daten (wie Stack V2) ist die Lernkurve stabiler und die Modellleistung deutlich verbessert.

Detaillierte Informationen: https://huggingface.co/spaces/LLM360/TxT360