OpenAI hat kürzlich eine bahnbrechende Technologie namens sCM (vereinfachtes, stabiles und skalierbares Konsistenzmodell) vorgestellt, die die Art und Weise, wie KI-Bildmodelle trainiert werden, grundlegend verändert. Diese Technologie stellt einen bedeutenden Fortschritt gegenüber bestehenden Konsistenzmodellen (CMs) dar und eröffnet neue Wege für die schnelle Bilderzeugung.

Kernvorteile der Technologie:

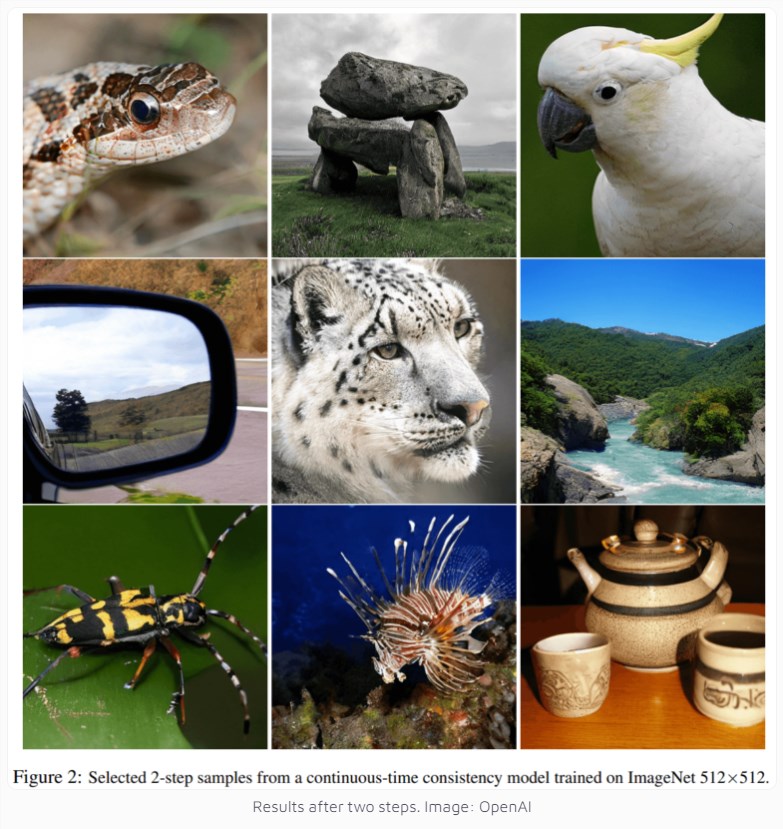

Erzeugung hochwertiger Bilder mit nur zwei Berechnungsschritten

Erzeugung eines Bildes auf einer A100-GPU in nur 0,11 Sekunden

50-fache Geschwindigkeitssteigerung im Vergleich zu herkömmlichen Diffusionsmodellen

Maximal 1,5 Milliarden Parameter – ein neuer Rekord

In praktischen Tests zeigte sCM beeindruckende Ergebnisse. Auf dem CIFAR-10-Datensatz erzielte es einen FID-Score von 2,06, und auf ImageNet erreichte es bei der Erzeugung von 512x512 Pixel-Bildern einen hervorragenden Score von 1,88. Diese Werte liegen nur etwa 10 % hinter den besten bestehenden Diffusionsmodellen zurück, bieten aber einen enormen Geschwindigkeitsvorteil.

Der Schlüssel zur technologischen Innovation liegt in der Lösung grundlegender Probleme herkömmlicher Konsistenzmodelle. Bisherige Modelle verwendeten diskrete Zeitschritte, was nicht nur zusätzliche Parameter erforderte, sondern auch zu Fehlern führte. Das OpenAI-Forschungsteam hat durch die Entwicklung eines vereinfachten theoretischen Rahmens verschiedene Methoden vereinheitlicht und erfolgreich die Hauptursachen für instabiles Training identifiziert und behoben.

Noch vielversprechender ist das enorme Skalierungspotenzial dieser Technologie. OpenAI hat erfolgreich ein Modell mit 1,5 Milliarden Parametern auf dem ImageNet-Datensatz trainiert – eine Premiere für Modelle dieser Art. Die Forschung zeigt, dass die Bildqualität mit zunehmender Modellgröße kontinuierlich verbessert wird, was zukünftig die Möglichkeit größerer Modelltrainings eröffnet.