Kürzlich veröffentlichte ein Forschungsteam das Framework namens HelloMeme, das die Mimik einer Person in einem Bild extrem realistisch auf die Mimik einer Person in einem anderen Bild übertragen kann.

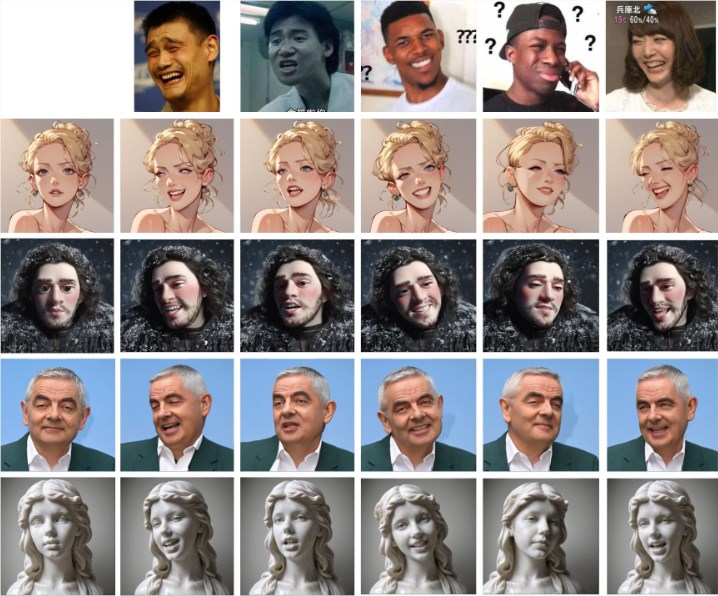

Wie unten gezeigt, kann man mit einem einzigen Mimikbild (erste Zeile) die Mimikdetails auf andere Personen in Bildern übertragen.

Der Kern von HelloMeme liegt in seiner einzigartigen Netzwerkstruktur. Das Framework kann die Merkmale jeder einzelnen Frame aus Fahrvideos extrahieren und diese Merkmale an das HMControlModule weiterleiten. Durch diese Verarbeitung können die Forscher flüssige Videobilder erzeugen. In den anfänglich generierten Videos traten jedoch Flimmerprobleme zwischen den Frames auf, die das gesamte Seherlebnis beeinträchtigten. Um dieses Problem zu lösen, führte das Team das Animatediff-Modul ein. Diese Innovation verbesserte die Kontinuität des Videos deutlich, verringerte aber auch die Bildqualität bis zu einem gewissen Grad.

Um diesen Widerspruch zu lösen, optimierte und passte das Forschungsteam das Animatediff-Modul weiter an und erreichte schließlich eine Verbesserung der Videokontinuität bei gleichzeitiger Beibehaltung einer hohen Bildqualität.

Darüber hinaus bietet das HelloMeme-Framework eine starke Unterstützung für die Bearbeitung von Gesichtsausdrücken. Durch die Anbindung von ARKit Face Blendshapes können Benutzer die Gesichtsausdrücke der Charaktere im generierten Video einfach steuern. Diese Flexibilität ermöglicht es den Erstellern, Videos mit bestimmten Emotionen und Ausdrücken zu generieren, was die Ausdruckskraft von Videoinhalten erheblich bereichert.

In Bezug auf die technische Kompatibilität verwendet HelloMeme ein Hot-Swap-Adapter-Design basierend auf SD1.5. Der größte Vorteil dieses Designs besteht darin, dass die Generalisierungsfähigkeit des T2I-Modells (Text-zu-Bild) nicht beeinträchtigt wird und jedes auf SD1.5 basierende Stilisierungsmodell nahtlos mit HelloMeme integriert werden kann. Dies bietet zahlreiche kreative Möglichkeiten.

Das Forschungsteam stellte fest, dass die Einführung von HMReferenceModule die Bedingungen für die Genauigkeit bei der Videogenerierung deutlich verbessert hat. Dies bedeutet, dass bei der Generierung von hochwertigen Videos die Anzahl der Sampling-Schritte reduziert werden kann. Diese Entdeckung erhöht nicht nur die Effizienz der Generierung, sondern öffnet auch neue Türen für die Echtzeit-Videogenerierung.

Der Vergleich mit anderen Methoden zeigt unten, dass die Mimikübertragung von HelloMeme deutlich natürlicher und der ursprünglichen Mimik ähnlicher ist.

Projekt-Eingang: https://songkey.github.io/hellomeme/

https://github.com/HelloVision/ComfyUI_HelloMeme

Wichtige Punkte:

🌐 HelloMeme erreicht durch seine einzigartige Netzwerkstruktur und das Animatediff-Modul sowohl eine flüssige Videogenerierung als auch eine hohe Bildqualität.

🎭 Das Framework unterstützt ARKit Face Blendshapes, sodass Benutzer die Gesichtsausdrücke der Charaktere flexibel steuern und die Ausdruckskraft von Videoinhalten verbessern können.

⚙️ Durch ein Hot-Swap-Adapter-Design wird die Kompatibilität mit anderen auf SD1.5 basierenden Modellen sichergestellt und die kreativen Möglichkeiten erweitert.