Im Bereich der künstlichen Intelligenz scheint Größe mit Leistungsfähigkeit gleichzusetzen zu sein. Um leistungsstärkere Sprachmodelle zu entwickeln, investieren große Technologieunternehmen massiv in die Erhöhung von Modellparametern und Trainingsdaten, was jedoch zu enorm steigenden Kosten führt. Gibt es keine ökonomischere und effizientere Methode zum Trainieren von Sprachmodellen?

Forscher der Harvard University und der Stanford University veröffentlichten kürzlich eine Studie, in der sie herausfanden, dass die Modellpräzision (Precision) der Schlüssel zur Lösung des „Kostenrätsels“ beim Training von Sprachmodellen ist.

Was ist Modellpräzision? Vereinfacht gesagt, bezieht sie sich auf die Anzahl der Stellen in den Modellparametern und den während der Berechnung verwendeten Zahlen. Traditionelle Deep-Learning-Modelle werden üblicherweise mit 32-Bit-Gleitkommazahlen (FP32) trainiert. Mit der Weiterentwicklung der Hardware ist es jedoch in den letzten Jahren möglich geworden, niedrigere Präzisionsstufen wie 16-Bit-Gleitkommazahlen (FP16) oder 8-Bit-Ganzzahlen (INT8) zu verwenden.

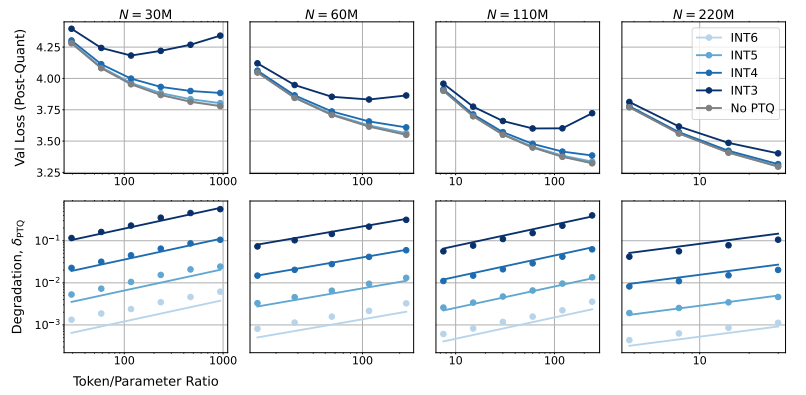

Welche Auswirkungen hat eine niedrigere Modellpräzision auf die Modellleistung? Genau dieser Frage widmet sich die Studie. Die Forscher analysierten durch umfangreiche Experimente die Kosten und Leistungsänderungen beim Training und der Inferenz bei unterschiedlichen Präzisionsstufen und entwickelten ein neuartiges „präzisionsbewusstes“ Skalierungsgesetz.

Sie fanden heraus, dass die Verwendung einer niedrigeren Präzision die „effektive Anzahl von Parametern“ des Modells effektiv reduziert und somit den Rechenaufwand für das Training verringert. Das bedeutet, dass bei gleichem Rechenbudget größere Modelle trainiert werden können oder bei gleicher Größe durch niedrigere Präzision erhebliche Rechenressourcen eingespart werden können.

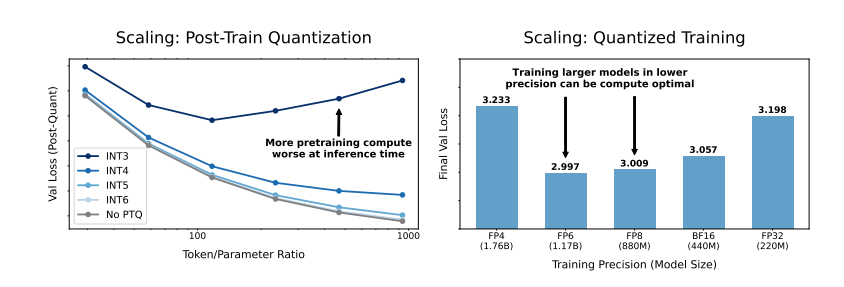

Noch überraschender ist, dass die Forscher in einigen Fällen feststellten, dass die Verwendung einer niedrigeren Präzision beim Training sogar die Modellleistung verbessern kann! Bei Modellen, die eine „Post-Training-Quantisierung“ benötigen, ist das Modell beispielsweise robuster gegenüber Präzisionsverlusten nach der Quantisierung, wenn während des Trainings eine niedrigere Präzision verwendet wird, was zu einer besseren Leistung in der Inferenzphase führt.

Welche Präzision sollten wir also für das Training von Modellen wählen? Die Forscher leiteten aus ihrer Skalierungsregel einige interessante Schlussfolgerungen ab:

Das traditionelle Training mit 16-Bit-Präzision ist möglicherweise nicht die optimale Wahl. Ihre Forschung zeigt, dass eine 7-8-Bit-Präzision eine wirtschaftlichere und effizientere Option sein könnte.

Die ausschließliche Verwendung einer sehr niedrigen Präzision (z. B. 4 Bit) ist ebenfalls nicht ratsam. Bei extrem niedriger Präzision sinkt die effektive Anzahl von Parametern des Modells stark ab. Um die Leistung aufrechtzuerhalten, müsste die Modellgröße erheblich erhöht werden, was wiederum zu höheren Rechenkosten führt.

Die optimale Trainingspräzision kann je nach Modellgröße unterschiedlich sein. Für Modelle, die ein starkes „Overtraining“ erfordern, wie z. B. die Serien Llama-3 und Gemma-2, kann ein Training mit höherer Präzision wirtschaftlicher und effizienter sein.

Diese Studie bietet eine völlig neue Perspektive auf das Verständnis und die Optimierung des Trainings von Sprachmodellen. Sie zeigt, dass die Präzisionswahl nicht statisch ist, sondern in Abhängigkeit von der konkreten Modellgröße, der Trainingsdatenmenge und dem Anwendungsfall abgewogen werden muss.

Natürlich weist diese Studie auch einige Einschränkungen auf. Beispielsweise waren die verwendeten Modellgrößen relativ klein, und die Ergebnisse lassen sich möglicherweise nicht direkt auf größere Modelle übertragen. Darüber hinaus konzentrierten sich die Forscher nur auf die Verlustfunktion des Modells und bewerteten die Leistung des Modells in nachgelagerten Aufgaben nicht.

Dennoch ist diese Studie von großer Bedeutung. Sie deckt die komplexe Beziehung zwischen Modellpräzision, Modellleistung und Trainingskosten auf und liefert wertvolle Erkenntnisse für die zukünftige Entwicklung und das Training leistungsstärkerer und wirtschaftlicherer Sprachmodelle.

Studie: https://arxiv.org/pdf/2411.04330