Kürzlich haben große Sprachmodelle (LLMs) der KI in verschiedenen Aufgaben beeindruckende Leistungen gezeigt, vom Schreiben von Gedichten und Code bis hin zu Konversationen – sie scheinen alles zu können! Aber können Sie es glauben? Diese „genialen“ KIs sind in Wirklichkeit „Mathe-Niete“! Bei einfachen Rechenaufgaben scheitern sie oft kläglich und lassen uns staunen.

Eine aktuelle Studie enthüllt das „skurrile“ Geheimnis hinter der arithmetischen Schlussfolgerungsfähigkeit von LLMs: Sie verlassen sich weder auf leistungsstarke Algorithmen noch vollständig auf das Gedächtnis, sondern verwenden eine Strategie, die als „heuristischer Eintopf“ bezeichnet wird! Das ist so, als würde ein Schüler Mathematikformeln und -theoreme nicht ernsthaft lernen, sondern mit ein paar „Schummeleien“ und „Faustregeln“ versuchen, die Antworten zu erraten.

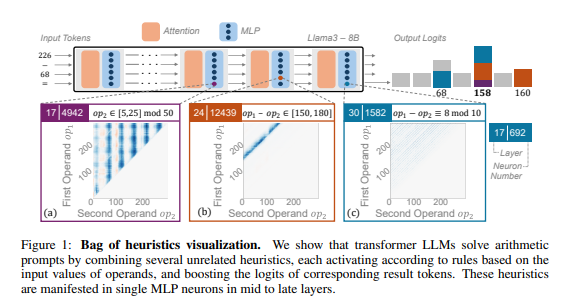

Forscher analysierten verschiedene LLMs wie Llama3, Pythia und GPT-J eingehend, wobei sie die arithmetische Schlussfolgerung als typische Aufgabe verwendeten. Sie fanden heraus, dass der Teil der LLM-Modelle, der für arithmetische Berechnungen zuständig ist (als „Schaltkreis“ bezeichnet), aus vielen einzelnen Neuronen besteht. Jedes Neuron ist wie ein „Mini-Rechner“, der nur bestimmte Zahlenmuster erkennt und die entsprechenden Antworten ausgibt. Zum Beispiel könnte ein Neuron darauf spezialisiert sein, „Zweierpotenzen“ zu erkennen, während ein anderes Neuron Subtraktionen erkennt, deren Ergebnis zwischen 150 und 180 liegt.

Diese „Mini-Rechner“ sind wie ein Haufen ungeordneter Werkzeuge. Der LLM verwendet sie nicht nach einem bestimmten Algorithmus, sondern kombiniert diese „Werkzeuge“ willkürlich, basierend auf den eingegebenen Zahlenmustern, um eine Antwort zu berechnen. Das ist wie ein Koch, der kein festes Rezept hat, sondern nach den verfügbaren Zutaten improvisiert und am Ende ein „Kurioses Gericht“ zaubert.

Noch überraschender ist, dass diese „heuristische Eintopf“-Strategie bereits in einem frühen Stadium des LLM-Trainings auftritt und sich im Laufe des Trainings weiter verbessert. Das bedeutet, dass LLMs von Anfang an auf diese „zusammengebastelte“ Schlussfolgerungsmethode angewiesen sind und diese Strategie nicht erst später entwickeln.

Welche Probleme verursacht diese „skurrile“ Methode der arithmetischen Schlussfolgerung? Die Forscher fanden heraus, dass die „heuristische Eintopf“-Strategie eine begrenzte Generalisierungsfähigkeit hat und leicht zu Fehlern führt. Dies liegt daran, dass die Anzahl der „Schummeleien“, die der LLM beherrscht, begrenzt ist und diese „Schummeleien“ selbst fehlerhaft sein können, was dazu führt, dass sie bei neuen Zahlenmustern keine korrekte Antwort liefern können. Wie ein Koch, der nur „Tomaten-Eier-Pfanne“ zubereiten kann und plötzlich ein „Süß-Sauer-Huhn“ kochen soll – er wird sicherlich überfordert sein.

Diese Studie zeigt die Grenzen der arithmetischen Schlussfolgerungsfähigkeit von LLMs auf und weist den Weg zur Verbesserung der mathematischen Fähigkeiten von LLMs in der Zukunft. Die Forscher sind der Meinung, dass die alleinigen bestehenden Trainingsmethoden und Modellarchitekturen möglicherweise nicht ausreichen, um die arithmetische Schlussfolgerungsfähigkeit von LLMs zu verbessern. Es müssen neue Methoden erforscht werden, um LLMs dabei zu helfen, leistungsfähigere und allgemeinere Algorithmen zu lernen, damit sie wirklich zu „Mathe-Experten“ werden.

论文地址:https://arxiv.org/pdf/2410.21272