Meta hat kürzlich einen neuen Benchmark namens Multi-IF veröffentlicht, der die Fähigkeit großer Sprachmodelle (LLMs) zur Befolgung von Anweisungen in mehrstufigen Dialogen und mehrsprachigen Umgebungen bewertet. Dieser Benchmark umfasst acht Sprachen und beinhaltet 4501 dreistufige Dialogaufgaben. Der Schwerpunkt liegt auf der Leistung aktueller Modelle in komplexen, mehrstufigen und mehrsprachigen Szenarien.

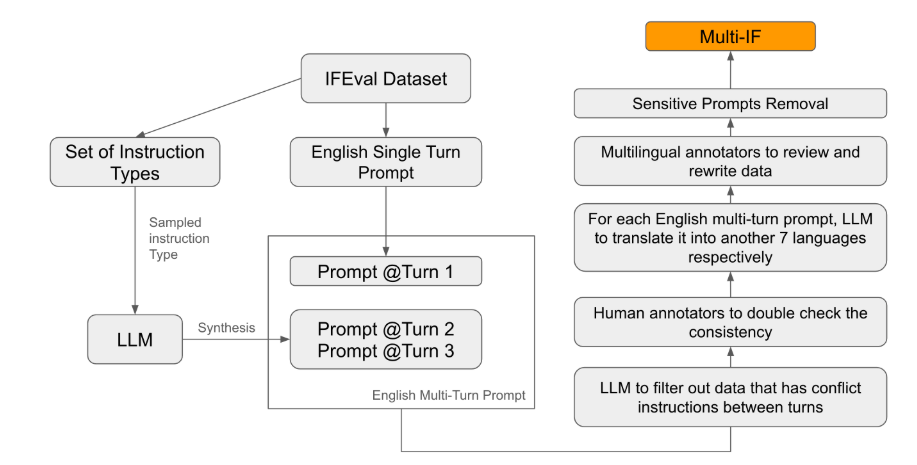

Die meisten bestehenden Bewertungsstandards konzentrieren sich auf einstufige Dialoge und einsprachige Aufgaben und können die Leistung von Modellen in realen Anwendungen nur unzureichend widerspiegeln. Multi-IF soll diese Lücke schließen. Das Forschungsteam hat komplexe Dialogszenarien generiert, indem es einstufige Anweisungen zu mehrstufigen Anweisungen erweitert und dabei sichergestellt, dass jede Anweisung logisch kohärent und progressiv ist. Darüber hinaus wurde die Mehrsprachigkeit des Datensatzes durch automatische Übersetzung und manuelle Korrektur erreicht.

Die Ergebnisse zeigen, dass die Leistung der meisten LLMs in mehrstufigen Dialogen deutlich abnimmt. Am Beispiel des o1-preview-Modells: Die durchschnittliche Genauigkeit liegt in der ersten Runde bei 87,7 %, sinkt aber in der dritten Runde auf 70,7 %. Besonders in nicht-lateinischen Schriften wie Hindi, Russisch und Chinesisch ist die Leistung der Modelle im Allgemeinen schlechter als in Englisch, was die Einschränkungen bei mehrsprachigen Aufgaben aufzeigt.

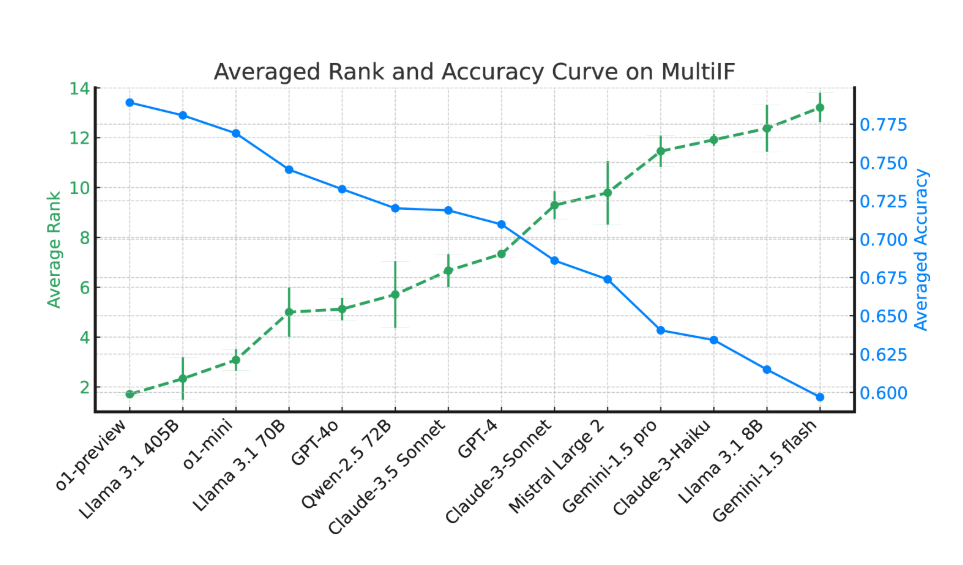

Bei der Bewertung von 14 führenden Sprachmodellen schnitten o1-preview und Llama3.1405B am besten ab, mit einer durchschnittlichen Genauigkeit von 78,9 % bzw. 78,1 % bei dreistufigen Anweisungen. In mehrstufigen Dialogen nahm jedoch die Fähigkeit aller Modelle zur Anweisungsbefolgung allgemein ab, was die Herausforderungen für Modelle bei komplexen Aufgaben verdeutlicht. Das Forschungsteam hat außerdem die „Anweisungs-Vergessenheit-Rate“ (IFR) eingeführt, um das Vergessen von Anweisungen in mehrstufigen Dialogen zu quantifizieren. Die Ergebnisse zeigen, dass leistungsstarke Modelle in dieser Hinsicht relativ gut abschneiden.

Multi-IF bietet Forschern einen anspruchsvollen Benchmark und fördert die Entwicklung von LLMs für globale und mehrsprachige Anwendungen. Die Einführung dieses Benchmarks deckt nicht nur die Schwächen aktueller Modelle bei mehrstufigen, mehrsprachigen Aufgaben auf, sondern gibt auch klare Hinweise für zukünftige Verbesserungen.

Artikel:https://arxiv.org/html/2410.15553v2

Wichtigste Punkte:

🌍 Der Multi-IF-Benchmark umfasst acht Sprachen und 4501 dreistufige Dialogaufgaben zur Bewertung der Leistung von LLMs in komplexen Szenarien.

📉 Die Experimente zeigen, dass die Genauigkeit der meisten LLMs in mehrstufigen Dialogen deutlich abnimmt, insbesondere in Sprachen mit nicht-lateinischer Schrift.

🔍 Die Modelle o1-preview und Llama3.1405B zeigen die beste Leistung, mit einer durchschnittlichen Genauigkeit von 78,9 % bzw. 78,1 % bei dreistufigen Anweisungen.