Haben Sie schon von ChatGPT, Wenxin Yiyin und anderen hochentwickelten KI-Systemen gehört? Das Kernstück dieser Technologien sind „Large Language Models“ (LLMs), also große Sprachmodelle. Klingt kompliziert und unverständlich? Keine Sorge! Selbst mit dem mathematischen Wissen eines Zweitklässlers werden Sie nach diesem Artikel die Funktionsweise von LLMs verstehen!

Neuronale Netze: Die Magie der Zahlen

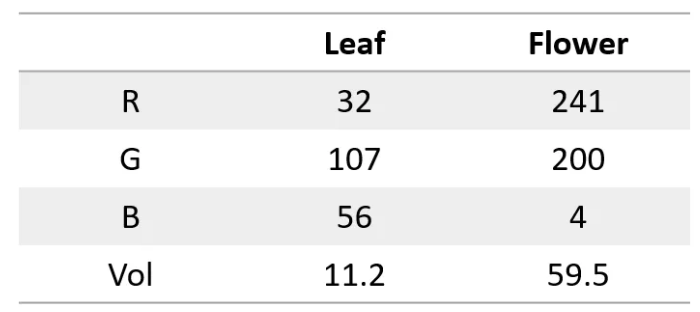

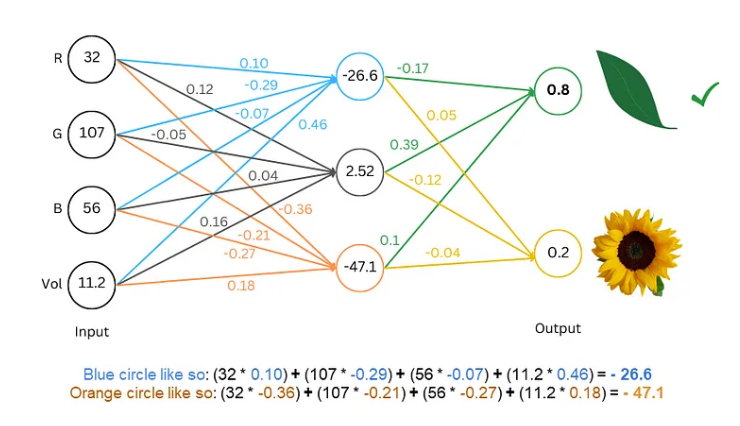

Zunächst einmal sollten wir wissen, dass neuronale Netze wie Superrechner funktionieren und nur mit Zahlen arbeiten. Sowohl die Eingabe als auch die Ausgabe müssen numerisch sein. Aber wie bringen wir ihnen bei, Texte zu verstehen?

Der Trick besteht darin, Texte in Zahlen umzuwandeln! Wir können beispielsweise jedem Buchstaben eine Zahl zuordnen, z. B. a=1, b=2 usw. So kann das neuronale Netz „Texte lesen“.

Modelltraining: Das Netzwerk lernt Sprache

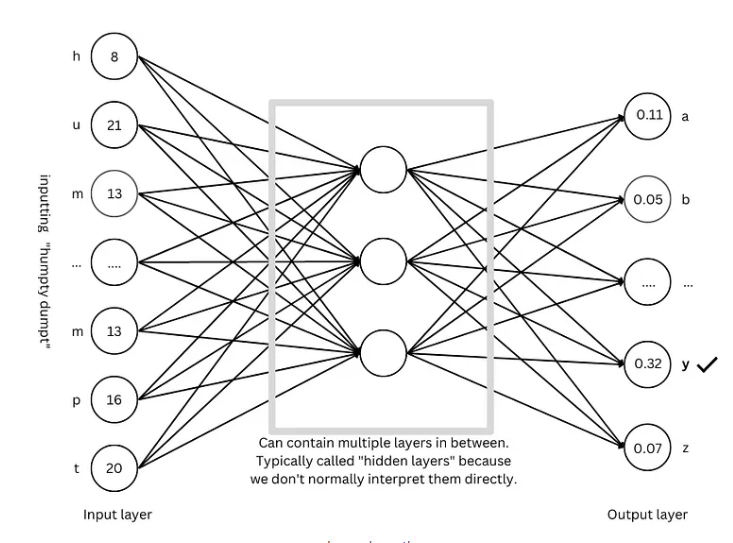

Nachdem wir Texte digitalisiert haben, müssen wir das Modell trainieren, damit das neuronale Netz die Gesetzmäßigkeiten der Sprache lernt.

Das Training ähnelt einem Ratespiel. Wir zeigen dem Netzwerk einige Texte, z. B. „Humpty Dumpty“, und lassen es den nächsten Buchstaben erraten. Bei richtiger Antwort gibt es eine Belohnung, bei falscher Antwort eine Bestrafung. Durch ständiges Raten und Anpassen kann das Netzwerk immer genauer den nächsten Buchstaben vorhersagen und schließlich ganze Sätze generieren, z. B. „Humpty Dumpty sat on a wall“.

Fortgeschrittene Techniken: Das Modell wird „klüger“

Um das Modell „klüger“ zu machen, haben Forscher verschiedene fortgeschrittene Techniken entwickelt, wie z. B.:

Wort-Einbettungen (Word Embeddings): Anstatt Buchstaben einfach durch Zahlen darzustellen, verwenden wir nun einen Satz von Zahlen (Vektoren), um jedes Wort zu repräsentieren. Dies ermöglicht eine umfassendere Beschreibung der Wortbedeutung.

Subword-Tokenizer: Wörter werden in kleinere Einheiten (Subwörter) zerlegt, z. B. „cats“ in „cat“ und „s“. Dies reduziert den Wortschatz und erhöht die Effizienz.

Selbstaufmerksamkeitsmechanismus (Self-Attention): Bei der Vorhersage des nächsten Wortes berücksichtigt das Modell alle Wörter im Kontext und passt die Vorhersagegewichte entsprechend an, ähnlich wie wir beim Lesen die Wortbedeutung aus dem Kontext erschließen.

Residuenverbindungen (Residual Connections): Um Schwierigkeiten beim Training durch zu viele Netzwerkebenen zu vermeiden, wurden Residuenverbindungen entwickelt, die das Lernen erleichtern.

Mehrköpfiger Selbstaufmerksamkeitsmechanismus (Multi-Head Attention): Durch parallele Ausführung mehrerer Selbstaufmerksamkeitsmechanismen kann das Modell den Kontext aus verschiedenen Perspektiven verstehen und die Vorhersagegenauigkeit verbessern.

Positionscodierung (Positional Encoding): Um die Wortreihenfolge zu berücksichtigen, werden Positionsinformationen in die Worteinbettungen integriert, ähnlich wie wir beim Lesen die Wortreihenfolge beachten.

GPT-Architektur: Die „Blaupause“ für große Sprachmodelle

Die GPT-Architektur ist eine der derzeit beliebtesten Architekturen für große Sprachmodelle. Sie dient als „Blaupause“ für Design und Training. Die GPT-Architektur kombiniert geschickt die oben genannten fortgeschrittenen Techniken, um ein effizientes Lernen und Generieren von Sprache zu ermöglichen.

Transformer-Architektur: Die „Revolution“ der Sprachmodelle

Die Transformer-Architektur ist ein bedeutender Durchbruch im Bereich der Sprachmodelle der letzten Jahre. Sie verbessert nicht nur die Vorhersagegenauigkeit, sondern vereinfacht auch das Training und bildet die Grundlage für die Entwicklung großer Sprachmodelle. Die GPT-Architektur basiert ebenfalls auf der Transformer-Architektur.

Referenzen: https://towardsdatascience.com/understanding-llms-from-scratch-using-middle-school-math-e602d27ec876