Die gemeinnützige KI-Forschungsorganisation Ai2 hat kürzlich ihre neue OLMo2-Serie veröffentlicht, die zweite Generation ihres „Open Language Model“ (OLMo)-Modells. Die Veröffentlichung von OLMo2 bietet der KI-Community nicht nur eine starke technologische Unterstützung, sondern repräsentiert mit ihrem vollständig offenen Quellcode auch die jüngste Entwicklung im Bereich Open-Source-KI.

Im Gegensatz zu anderen „offenen“ Sprachmodellen auf dem Markt, wie der Llama-Serie von Meta, entspricht OLMo2 der strengen Definition der Open-Source-Initiative. Das bedeutet, dass die für die Entwicklung verwendeten Trainingsdaten, Tools und Codes öffentlich zugänglich sind und von jedermann genutzt werden können. Gemäß der Definition der Open Source Initiative erfüllt OLMo2 die Anforderungen der Organisation an einen „Open-Source-KI“-Standard, der im Oktober dieses Jahres finalisiert wurde.

Ai2 erwähnt in seinem Blog, dass bei der Entwicklung von OLMo2 alle Trainingsdaten, der Code, die Trainingspläne, die Bewertungsmethoden und die Zwischen-Checkpoints vollständig offen gelegt wurden. Ziel ist es, durch die gemeinsame Nutzung von Ressourcen Innovationen und Entdeckungen in der Open-Source-Community zu fördern. „Durch das offene Teilen unserer Daten, Methoden und Erkenntnisse möchten wir der Open-Source-Community Ressourcen zur Verfügung stellen, um neue Methoden und innovative Technologien zu entdecken“, so Ai2.

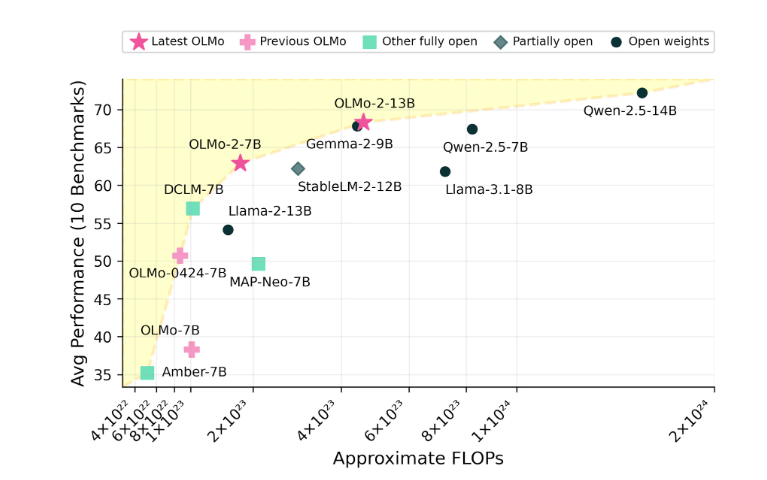

Die OLMo2-Serie umfasst zwei Versionen: OLMo7B mit 7 Milliarden Parametern und OLMo13B mit 13 Milliarden Parametern. Die Anzahl der Parameter beeinflusst die Leistung des Modells direkt, wobei Versionen mit mehr Parametern in der Regel komplexere Aufgaben bewältigen können. Bei gängigen Text-Aufgaben zeigt OLMo2 eine hervorragende Leistung und kann Aufgaben wie das Beantworten von Fragen, das Zusammenfassen von Dokumenten und das Schreiben von Code erledigen.

Bildquelle: Das Bild wurde mit KI generiert, Bildlizenzgeber Midjourney

Für das Training von OLMo2 verwendete Ai2 einen Datensatz mit fünf Billionen Tokens. Tokens sind die kleinsten Einheiten in Sprachmodellen; eine Million Tokens entsprechen etwa 750.000 Wörtern. Die Trainingsdaten umfassen Inhalte von hochwertigen Websites, wissenschaftlichen Arbeiten, Frage-und-Antwort-Foren und synthetischen Mathematik-Übungsheften. Diese Daten wurden sorgfältig ausgewählt, um die Effizienz und Genauigkeit des Modells zu gewährleisten.

Ai2 ist von der Leistung von OLMo2 überzeugt und behauptet, dass es in Bezug auf die Leistung mit Open-Source-Modellen wie Metas Llama3.1 konkurriert. Ai2 weist darauf hin, dass OLMo27B sogar Llama3.18B übertrifft und damit zu den derzeit leistungsstärksten vollständig offenen Sprachmodellen gehört. Alle OLMo2-Modelle und ihre Komponenten können kostenlos über die Ai2-Website heruntergeladen werden und unterliegen der Apache2.0-Lizenz. Das bedeutet, dass diese Modelle sowohl für Forschungszwecke als auch für kommerzielle Anwendungen verwendet werden können.