Die Nachfrage nach Machine-Learning-Modellen für visuelle und sprachliche Aufgaben ist in den letzten Jahren stark gestiegen. Die meisten Modelle benötigen jedoch immense Rechenressourcen und lassen sich nicht effizient auf persönlichen Geräten einsetzen. Besonders kleine Geräte wie Laptops, Consumer-GPUs und mobile Endgeräte stehen vor großen Herausforderungen bei der Verarbeitung von visuellen und sprachlichen Aufgaben.

Qwen2-VL ist beispielsweise zwar leistungsstark, setzt aber hohe Anforderungen an die Hardware, was seine Einsatzfähigkeit in Echtzeitanwendungen einschränkt. Daher besteht ein wichtiger Bedarf an leichtgewichtigen Modellen, die auch mit geringen Ressourcen effizient arbeiten.

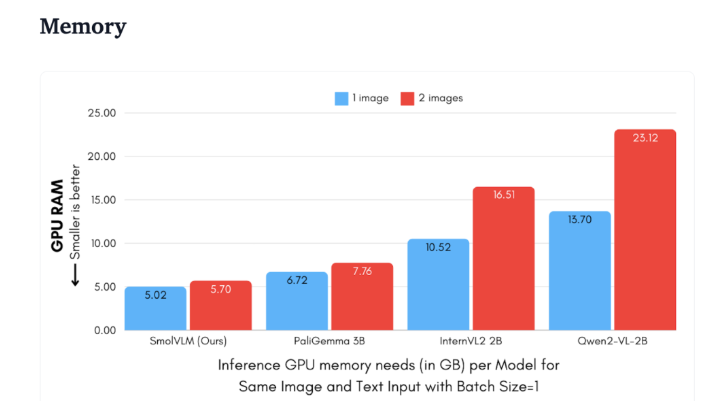

Hugging Face hat kürzlich SmolVLM veröffentlicht, ein 2B-Parameter-visuell-sprachliches Modell, das speziell für die Inferenz auf Endgeräten entwickelt wurde. SmolVLM übertrifft andere vergleichbare Modelle in Bezug auf GPU-Speicherverbrauch und Token-Generierungsgeschwindigkeit. Sein Hauptmerkmal ist die effiziente Ausführung auf kleineren Geräten wie Laptops oder Consumer-GPUs, ohne dabei an Leistung einzubüßen. SmolVLM findet einen idealen Ausgleich zwischen Leistung und Effizienz und löst damit ein Problem, das bisherige Modelle nicht bewältigen konnten.

Im Vergleich zu Qwen2-VL 2B ist SmolVLM 7,5- bis 16-mal schneller bei der Token-Generierung. Dies ist seiner optimierten Architektur zu verdanken, die leichtgewichtige Inferenz ermöglicht. Diese Effizienz bietet nicht nur praktische Vorteile für den Endbenutzer, sondern verbessert auch das Benutzererlebnis erheblich.

Technisch gesehen verfügt SmolVLM über eine optimierte Architektur, die eine effiziente Inferenz auf Endgeräten unterstützt. Benutzer können es sogar einfach auf Google Colab feinabstimmen, was den Aufwand für Experimente und Entwicklung erheblich reduziert.

Aufgrund des geringen Speicherbedarfs kann SmolVLM auf Geräten laufen, die bisher keine vergleichbaren Modelle unterstützen konnten. Bei Tests mit 50 Bildern eines YouTube-Videos erzielte SmolVLM eine hervorragende Punktzahl von 27,14 % und übertraf dabei zwei ressourcenintensivere Modelle im Ressourcenverbrauch. Dies zeigt seine hohe Anpassungsfähigkeit und Flexibilität.

SmolVLM stellt einen wichtigen Meilenstein im Bereich der visuell-sprachlichen Modelle dar. Durch seine Einführung können komplexe visuell-sprachliche Aufgaben auf alltäglichen Geräten ausgeführt werden, wodurch eine wichtige Lücke in den aktuellen AI-Tools geschlossen wird.

SmolVLM zeichnet sich nicht nur durch Geschwindigkeit und Effizienz aus, sondern bietet Entwicklern und Forschern auch ein leistungsstarkes Werkzeug für die Verarbeitung visuell-sprachlicher Daten, ohne hohe Hardwarekosten. Mit der zunehmenden Verbreitung von KI-Technologien werden Modelle wie SmolVLM leistungsstarke Machine-Learning-Funktionen für eine breitere Nutzerschaft zugänglich machen.

Demo: https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

Highlights:

🌟 SmolVLM ist ein von Hugging Face entwickeltes 2B-Parameter-visuell-sprachliches Modell, das speziell für die Inferenz auf Endgeräten konzipiert wurde. Es arbeitet effizient und benötigt keine High-End-Hardware.

⚡ Seine Token-Generierungsgeschwindigkeit ist 7,5- bis 16-mal höher als bei vergleichbaren Modellen, was die Benutzererfahrung und Anwendungseffizienz deutlich verbessert.

📊 In Tests zeigte SmolVLM eine hohe Anpassungsfähigkeit und erzielte auch ohne Training mit Videodaten gute Ergebnisse.