Im Zeitalter des rasanten Fortschritts in der künstlichen Intelligenz steigt das Intelligenzlevel großer Modelle stetig an, doch gleichzeitig werden die Herausforderungen an die Effizienz von Inferenzsystemen immer größer. Die Bewältigung hoher Inferenzlasten, die Senkung der Inferenzkosten und die Verkürzung der Antwortzeiten sind zu wichtigen Problemen geworden, vor denen die Branche steht.

Kimi, in Zusammenarbeit mit dem MADSys-Labor der Tsinghua-Universität, hat das auf KVCache basierende Mooncake-Inferenzsystemdesign vorgestellt, das im Juni 2024 offiziell veröffentlicht wurde.

Das Mooncake-Inferenzsystem verbessert durch seine innovative PD-getrennte Architektur und das Konzept des „Speicher-statt-Rechen“-Ansatzes die Durchsatzleistung der Inferenz deutlich und hat breite Aufmerksamkeit in der Branche auf sich gezogen. Um die Anwendung und Verbreitung dieses Technologie-Frameworks weiter voranzutreiben, haben Kimi und das MADSys-Labor der Tsinghua-Universität zusammen mit mehreren Unternehmen wie 9#AISoft, Alibaba Cloud und Huawei Storage das Open-Source-Projekt Mooncake ins Leben gerufen. Am 28. November wurde der Technologie-Framework von Mooncake auf der GitHub-Plattform offiziell veröffentlicht.

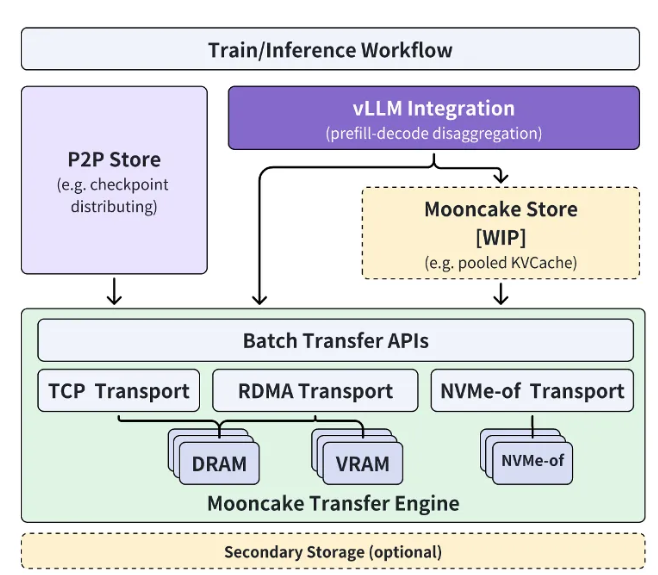

Das Mooncake Open-Source-Projekt konzentriert sich auf einen extrem großen KVCache-Cache-Pool und zielt darauf ab, schrittweise einen hochleistungsfähigen mehrstufigen KVCache-Cache, den Mooncake Store, in mehreren Phasen als Open Source bereitzustellen. Gleichzeitig wird das Projekt verschiedene Inferenz-Engines und zugrunde liegende Speicher- und Übertragungsressourcen unterstützen.

Derzeit ist ein Teil der Transfer Engine bereits auf GitHub weltweit als Open Source verfügbar. Das letztendliche Ziel des Mooncake-Projekts ist es, eine neue, hochleistungsfähige Schnittstelle für die semantische Speicherung im Arbeitsspeicher für das Zeitalter großer Modelle zu schaffen und entsprechende Referenzimplementierungen bereitzustellen.

Xu Xinran, Engineering Vice President bei Kimi, erklärt: „Durch die enge Zusammenarbeit mit dem MADSys-Labor der Tsinghua-Universität haben wir gemeinsam die getrennte Architektur für das Inferenzsystem großer Modelle, Mooncake, entwickelt und eine optimale Nutzung der Inferenzressourcen erreicht.

Mooncake verbessert nicht nur die Benutzererfahrung, sondern senkt auch die Kosten und bietet eine effektive Lösung für die Verarbeitung langer Texte und hoher gleichzeitiger Anforderungen.“ Er hofft, dass sich weitere Unternehmen und Forschungseinrichtungen dem Mooncake-Projekt anschließen werden, um gemeinsam effizientere Architekturen für Inferenzsysteme zu erforschen und so Produkte auf Basis großer Modelle, wie z. B. KI-Assistenten, für ein breiteres Publikum zugänglich zu machen.

Projekt-Link:https://github.com/kvcache-ai/Mooncake

Wichtigste Punkte:

🌟 Kimi und die Tsinghua-Universität veröffentlichen gemeinsam das Mooncake-Inferenzsystem zur Steigerung der KI-Inferenz-Effizienz.

🔧 Das Mooncake-Projekt ist auf GitHub als Open Source verfügbar und zielt darauf ab, eine Standard-Schnittstelle für die hochleistungsfähige semantische Speicherung im Arbeitsspeicher zu schaffen.

🤝 Wir erwarten die Beteiligung weiterer Unternehmen und Forschungseinrichtungen, um gemeinsam den Fortschritt der KI-Technologie voranzutreiben.