Ein wichtiger Maßstab im Bereich der künstlichen Intelligenz, ARC-AGI (Abstraction and Reasoning Corpus for General Artificial Intelligence), steht kurz vor einem Durchbruch. Der Schöpfer des Tests, François Chollet, warnt jedoch, dass trotz Verbesserungen der Ergebnisse dies nicht bedeutet, dass wir der Entwicklung einer Allgemeinen Künstlichen Intelligenz (AGI) näher kommen. Er weist darauf hin, dass der Test selbst designbedingt Mängel aufweist und keine echten Forschungsdurchbrüche aufzeigt.

Seit Chollet ARC-AGI im Jahr 2019 einführte, haben KI-Systeme in dem Test stets schlecht abgeschnitten. Bis heute konnte das beste System weniger als ein Drittel der Aufgaben lösen. Chollet führt dies hauptsächlich auf die übermäßige Abhängigkeit der aktuellen KI-Forschung von großen Sprachmodellen (LLMs) zurück. Er betont, dass LLMs zwar Mustererkennung bei der Verarbeitung großer Datenmengen ermöglichen, aber auf Gedächtnis statt auf Schlussfolgerungen beruhen und daher Schwierigkeiten haben, unbekannte Situationen zu bewältigen oder wirklich zu „schließen“.

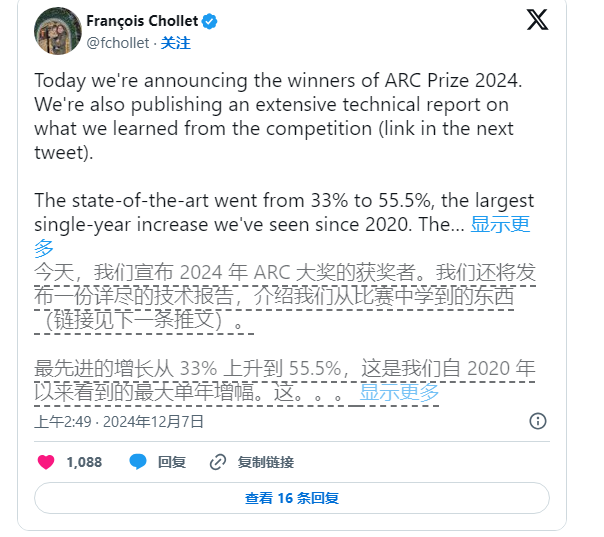

„LLM-Modelle verlassen sich darauf, Muster aus den Trainingsdaten zu extrahieren, anstatt eigenständig zu schließen. Sie ‚merken‘ sich lediglich die Muster, anstatt neue Schlussfolgerungen zu generieren“, erklärte Chollet in einer Reihe von Beiträgen auf der Social-Media-Plattform X.

Dennoch treibt Chollet die KI-Forschung weiter voran. Zusammen mit Mike Knoop, dem Gründer von Zapier, initiierte er im Juni dieses Jahres einen Wettbewerb mit einem Preisgeld von 1 Million US-Dollar, um Open-Source-KI-Lösungen zur Bewältigung des ARC-AGI-Maßstabs zu fördern. Obwohl das beste KI-System unter 17.789 Einsendungen nur 55,5 % der Punkte erreichte – weit unter den 85 %, die für „menschliches Niveau“ erforderlich sind – sehen Chollet und Knoop dies als einen wichtigen Schritt nach vorne.

Knoop weist in einem Blogbeitrag darauf hin, dass dieses Ergebnis nicht bedeutet, dass wir der AGI näher gekommen sind, sondern vielmehr die Tatsache unterstreicht, dass einige Aufgaben in ARC-AGI zu sehr auf „Brute-Force“-Lösungen angewiesen sind und möglicherweise kein aussagekräftiges Signal für echte allgemeine Intelligenz liefern. ARC-AGI soll die Generalisierungsfähigkeit von KI durch die Bereitstellung komplexer, noch nie gesehener Aufgaben testen. Ob diese Aufgaben jedoch AGI effektiv bewerten können, ist fraglich.

Bildquelle: Das Bild wurde mit KI generiert, Bildrechte: Midjourney

Die Aufgaben im ARC-AGI-Benchmark umfassen beispielsweise Puzzles, bei denen die KI aus bekannten Informationen unbekannte Antworten ableiten muss. Obwohl diese Aufgaben scheinbar die Anpassungsfähigkeit der KI an neue Situationen fördern sollen, zeigen die Ergebnisse, dass die bestehenden Modelle die Lösungen eher durch umfangreiche Berechnungen finden, anstatt echte Intelligenz und Anpassungsfähigkeit zu demonstrieren.

Darüber hinaus sehen sich die Schöpfer von ARC-AGI Kritik von Kollegen gegenüber, insbesondere hinsichtlich der Unklarheit bei der Definition von AGI. Ein Mitarbeiter von OpenAI äußerte kürzlich, dass AGI bereits erreicht sei, wenn man AGI als eine KI definiert, die in den meisten Aufgaben besser abschneidet als die meisten Menschen. Chollet und Knoop sind jedoch der Ansicht, dass das derzeitige Design des ARC-AGI-Benchmarks dieses Ziel noch nicht vollständig erreicht hat.

Für die Zukunft planen Chollet und Knoop die Veröffentlichung eines ARC-AGI-Benchmarks der zweiten Generation und werden 2025 einen neuen Wettbewerb veranstalten, um die Mängel des aktuellen Tests zu beheben. Sie geben an, dass der neue Benchmark sich stärker darauf konzentrieren wird, die KI-Forschung in wichtigere Richtungen zu lenken und den Entwicklungsprozess von AGI zu beschleunigen.

Die Verbesserung des bestehenden Benchmarks ist jedoch keine leichte Aufgabe. Die Bemühungen von Chollet und Knoop zeigen, dass die Definition von Intelligenz bei künstlicher Intelligenz, insbesondere im Bereich der allgemeinen Intelligenz, immer noch eine schwierige und komplexe Aufgabe ist.