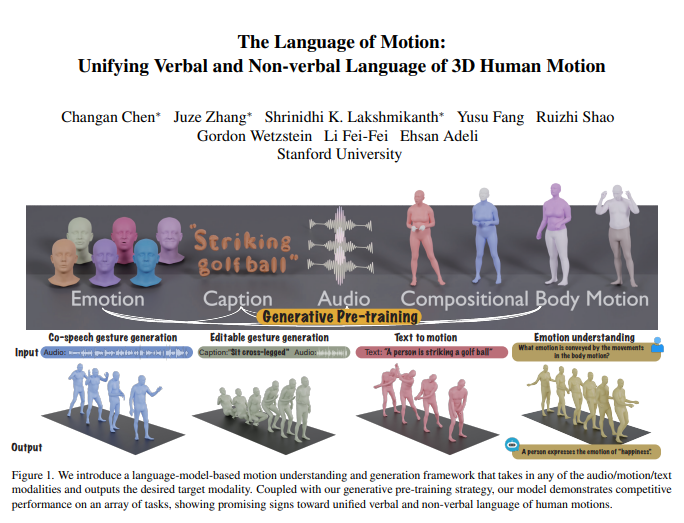

Das Team von Li Feifei hat ein neues multimodales Modell vorgestellt, das menschliche Aktionen verstehen und generieren kann und durch die Kombination mit einem Sprachmodell eine einheitliche Verarbeitung von verbaler und nonverbaler Sprache ermöglicht. Diese bahnbrechende Forschung ermöglicht es Maschinen nicht nur, menschliche Anweisungen zu verstehen, sondern auch die in Aktionen enthaltenen Emotionen zu erkennen, um so eine natürlichere Mensch-Maschine-Interaktion zu ermöglichen.

Der Kern des Modells ist sein multimodales Sprachmodell-Framework, das verschiedene Eingaben wie Audio, Aktionen und Text empfangen und die benötigten Modalitätsdaten ausgeben kann. In Kombination mit einer generativen Pre-Training-Strategie zeigt das Modell in mehreren Aufgaben eine hervorragende Leistung. Beispielsweise übertrifft das Modell im Bereich der koordinierten Sprachgeste-Generierung nicht nur den aktuellen Stand der Technik, sondern reduziert auch den Bedarf an Trainingsdaten deutlich. Darüber hinaus erschließt das Modell neue Anwendungsszenarien, wie z. B. die editierbare Gestengenerierung und die Emotionsvorhersage anhand von Aktionen.

Menschliche Kommunikation ist im Wesentlichen multimodal und umfasst verbale und nonverbale Hinweise wie Sprache, Gesichtsausdrücke und Körperhaltung. Die Fähigkeit dieses Modells, diese multimodales Verhalten zu verstehen, ist entscheidend für die Erstellung von virtuellen Charakteren, die in Anwendungen wie Spielen, Filmen und Virtual Reality natürlich kommunizieren können. Bisherige Aktionsgenerierungsmodelle beschränken sich jedoch meist auf spezifische Eingabemodalitäten (Sprach-, Text- oder Bewegungsdaten) und können die Vielfalt der verfügbaren Daten nicht vollständig nutzen.

Das Modell nutzt ein Sprachmodell, um verbale und nonverbale Sprache zu vereinheitlichen, hauptsächlich aus drei Gründen:

Sprachmodelle verbinden verschiedene Modalitäten auf natürliche Weise.

Sprache ist hochgradig semantisch, und die Modellierung von Aufgaben wie der Reaktion auf Witze erfordert starke semantische Schlussfolgerungsfähigkeiten.

Sprachmodelle erhalten durch umfangreiches Pretraining starke semantische Verständnisfähigkeiten.

Um dieses Ziel zu erreichen, unterteilt das Forschungsteam den Körper zunächst in verschiedene Teile (Gesicht, Hände, Oberkörper, Unterkörper) und markiert die Aktionen jedes Teils separat. In Kombination mit Tokenizern für Text und Sprache kann jede Modalitätseingabe als Folge von Token dargestellt werden, die vom Sprachmodell verwendet werden können. Das Modell verwendet einen zweistufigen Trainingsprozess: Zuerst wird ein Pretraining durchgeführt, um verschiedene Modalitäten und kombinierte Körperbewegungen sowie Audio und Text aufeinander abzustimmen. Anschließend werden Downstream-Aufgaben in Anweisungen umgewandelt, und das Modell wird auf diesen Anweisungen trainiert, um verschiedene Aufgabenanweisungen zu befolgen.

Das Modell zeigt im BEATv2-Benchmark für die koordinierte Sprachgeste-Generierung eine hervorragende Leistung und übertrifft deutlich bestehende Modelle. Die Wirksamkeit der Pretraining-Strategie wurde ebenfalls bestätigt, insbesondere bei Datenknappheit, wobei eine starke Generalisierungsfähigkeit gezeigt wurde. Durch Fine-tuning auf Sprach-Aktions- und Text-Aktions-Aufgaben kann das Modell nicht nur Audio- und Text-Prompts befolgen, sondern auch neue Funktionen wie die Emotionsvorhersage aus Aktionsdaten realisieren.

In Bezug auf die technischen Details verarbeitet das Modell verschiedene Eingabemodalitäten mit modalitätsspezifischen Tokenizern. Konkret trainiert das Modell ein kombiniertes Körperbewegungs-VQ-VAE, das die Aktionen von Gesicht, Händen, Oberkörper und Unterkörper in diskrete Token umwandelt. Diese modalitätsspezifischen Vokabulare (Audio und Text) werden in einem einheitlichen multi-modalen Vokabular zusammengeführt. Während des Trainings werden gemischte Token verschiedener Modalitäten als Eingabe verwendet, und ein Encoder-Decoder-Sprachmodell generiert die Ausgabe.

Das Modell nutzt auch das multimodale Vokabular, um verschiedene Modalitätsdaten in ein einheitliches Format zur Verarbeitung umzuwandeln. In der Pretraining-Phase lernt das Modell die Korrespondenz zwischen verschiedenen Modalitäten, indem es Modalitätsübersetzungsaufgaben ausführt. Beispielsweise kann das Modell lernen, Oberkörperbewegungen in Unterkörperbewegungen umzuwandeln oder Audio in Text umzuwandeln. Darüber hinaus lernt das Modell die zeitliche Entwicklung von Aktionen, indem es zufällig einige Aktionsframes maskiert.

In der Fine-tuning-Phase wird das Modell mit gepaarten Daten feinabgestimmt, um Downstream-Aufgaben wie die koordinierte Sprachgeste-Generierung oder die Text-zu-Aktions-Generierung auszuführen. Um das Modell in der Lage zu machen, natürlichen menschlichen Anweisungen zu folgen, haben die Forscher eine Multi-Task-Anweisungsfolgevorlage erstellt, die Aufgaben wie Audio-zu-Aktions, Text-zu-Aktions und Emotion-zu-Aktions in Anweisungen umwandelt. Das Modell verfügt auch über die Fähigkeit, Gesten zu bearbeiten und kann auf der Grundlage von Text- und Audio-Prompts koordinierte Ganzkörperbewegungen generieren.

Schließlich erschließt das Modell auch die neue Fähigkeit, Emotionen aus Aktionen vorherzusagen. Dies ist für Bereiche wie psychische Gesundheit oder Psychiatrie von großer Bedeutung. Im Vergleich zu anderen Modellen kann dieses Modell Emotionen, die in Aktionen ausgedrückt werden, genauer vorhersagen und zeigt ein starkes Verständnis von Körpersprache.

Diese Studie zeigt, dass die Vereinheitlichung der verbalen und nonverbalen Sprache menschlicher Aktionen für praktische Anwendungen entscheidend ist, und Sprachmodelle dafür einen leistungsstarken Rahmen bieten.

论文地址:https://arxiv.org/pdf/2412.10523v1