Nur sechs Monate nach der Veröffentlichung von GB200 und B200 bringt Nvidia die neuen GPUs GB300 und B300 auf den Markt. Obwohl es sich um ein scheinbar geringfügiges Upgrade handelt, birgt es tiefgreifende Veränderungen, insbesondere eine deutliche Steigerung der Inferenzleistung, die die gesamte Branche nachhaltig beeinflussen wird.

B300/GB300: Ein Quantensprung in der Inferenzleistung

Die B300 GPU nutzt den 4N-Prozessknoten von TSMC und wurde speziell für Rechenchips optimiert. Dadurch bietet die B300 eine um 50 % höhere FLOPS-Leistung als die B200. Ein Teil dieser Leistungssteigerung resultiert aus der erhöhten TDP; GB300 und B300HGX erreichen 1,4 kW bzw. 1,2 kW (GB200 und B200 hatten 1,2 kW bzw. 1 kW). Der Rest der Leistungssteigerung ist auf Architekturverbesserungen und Systemoptimierungen zurückzuführen, z. B. die dynamische Leistungsverteilung zwischen CPU und GPU.

Neben der FLOPS-Steigerung wurde der Speicher auf 12-Hi HBM3E aufgerüstet, wodurch die HBM-Kapazität pro GPU auf 288 GB erhöht wurde. Die Pin-Geschwindigkeit bleibt jedoch unverändert, sodass die Speicherbandbreite pro GPU weiterhin bei 8 TB/s liegt. Bemerkenswert ist, dass Samsung nicht in die Lieferkette von GB200 oder GB300 eingebunden ist.

Nvidia hat außerdem die Preisgestaltung angepasst. Dies wird die Gewinnmarge der Blackwell-Produkte zwar teilweise beeinflussen, aber die Leistungssteigerung von B300/GB300 wird sich vor allem bei Inferenzmodellen bemerkbar machen.

Maßgeschneidert für Inferenzmodelle

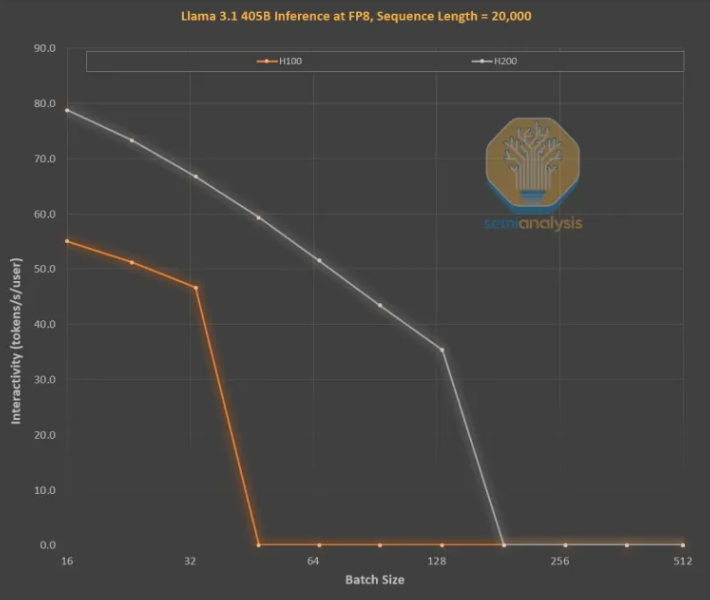

Die Speicherverbesserungen sind für das LLM-Inferenztraining im OpenAI O3-Stil von entscheidender Bedeutung, da lange Sequenzen den KV-Cache vergrößern und so die kritische Batchgröße und die Latenz begrenzen. Das Upgrade von H100 auf H200 (hauptsächlich durch die Speichererhöhung) brachte folgende Verbesserungen:

Die höhere Speicherbandbreite (4,8 TB/s bei H200 gegenüber 3,35 TB/s bei H100) führte zu einer allgemeinen Verbesserung der Interaktivität aller vergleichbaren Batchgrößen um 43 %.

Da H200 größere Batchgrößen als H100 verarbeitet, erhöhte sich die Anzahl der pro Sekunde generierten Token um das Dreifache, während die Kosten um etwa das Dreifache gesenkt wurden. Dieser Unterschied ist hauptsächlich auf die KV-Cache-Begrenzung der Gesamt-Batchgröße zurückzuführen.

Die größere Speicherkapazität wirkt sich enorm auf die Leistungssteigerung aus. Der Leistungs- und Kostenunterschied zwischen den beiden GPUs ist deutlich größer als die Spezifikationen vermuten lassen:

Die Benutzererfahrung bei Inferenzmodellen kann durch spürbare Wartezeiten zwischen Anfrage und Antwort beeinträchtigt werden. Eine deutliche Beschleunigung der Inferenzzeit würde die Akzeptanz und Zahlungsbereitschaft der Nutzer erhöhen.

Eine dreifache Leistungssteigerung durch ein Mid-Generation-Speicher-Upgrade ist erstaunlich und übertrifft das Mooresche Gesetz, das Huangsche Gesetz oder jede andere von uns beobachtete Geschwindigkeit von Hardware-Verbesserungen bei weitem.

Die leistungsstärksten Modelle können einen deutlich höheren Preisaufschlag erzielen als Modelle mit geringerer Leistung. Spitzmodelle weisen eine Bruttomarge von über 70 % auf, während die Marge bei nachrangigen Modellen mit Open-Source-Konkurrenz unter 20 % liegt. Inferenzmodelle müssen nicht nur einen Chain-of-Thought-Prozess durchführen. Die Suchfunktion kann erweitert werden, um die Leistung zu verbessern, wie dies bei O1Pro und O3 der Fall ist. Dies ermöglicht es intelligenteren Modellen, mehr Probleme zu lösen und mehr Umsatz pro GPU zu generieren.

Natürlich ist Nvidia nicht das einzige Unternehmen, das die Speicherkapazität erhöhen kann. Auch ASICs können dies; tatsächlich könnte AMD in einer günstigeren Position sein, da die Speicherkapazität von MI300X, MI325X und MI350X in der Regel höher ist als bei Nvidia (192 GB, 256 GB bzw. 288 GB). Nvidia verfügt jedoch über eine Geheimwaffe namens NVLink.

Die Bedeutung von NVL72 liegt darin, dass 72 GPUs an derselben Aufgabe zusammenarbeiten, den Speicher gemeinsam nutzen und eine extrem niedrige Latenz aufweisen können. Kein anderer Beschleuniger weltweit verfügt über eine voll vermaschte Switching-Fähigkeit.

Nvidia's GB200NVL72 und GB300NVL72 sind für viele wichtige Funktionen unerlässlich:

Höhere Interaktivität, wodurch die Latenz pro Denkprozesskette reduziert wird.

72 GPUs können den KV-Cache verteilen und so längere Denkprozesse ermöglichen (höhere Intelligenz).

Die Skalierbarkeit der Batchgröße ist deutlich besser als bei typischen 8-GPU-Servern, was die Kosten senkt.

Eine größere Stichprobengröße, die an derselben Aufgabe arbeitet, um die Genauigkeit und die Modellleistung zu verbessern.

Daher verbessert NVL72 die Tokenomics um mehr als das Zehnfache, insbesondere bei langen Inferenzketten. Der KV-Cache-Speicherverbrauch ist für die Wirtschaftlichkeit tödlich, aber NVL72 ist die einzige Möglichkeit, die Inferenzlänge auf über 100.000 Token zu erweitern.

GB300: Umgestaltung der Lieferkette

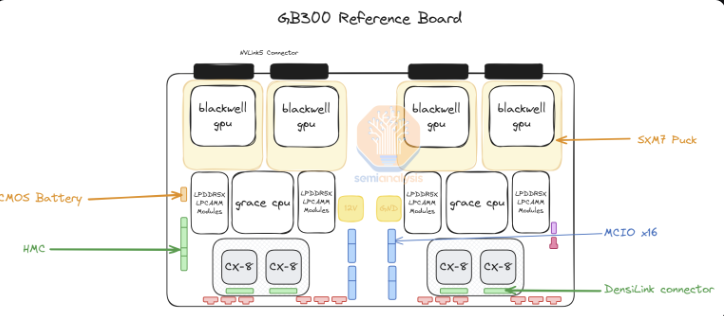

Bei GB300 hat Nvidia die angebotene Lieferkette und den Inhalt stark verändert. Bei GB200 lieferte Nvidia die gesamte Bianca-Platine (einschließlich Blackwell-GPU, Grace-CPU, 512 GB LPDDR5X, VRM-Inhalt) sowie das Switching-Tray und die Kupferrückplatte.

Bei GB300 liefert Nvidia nur noch das B300 auf dem „SXM Puck“-Modul, die BGA-gekapselte Grace-CPU und den HMC, der von dem US-amerikanischen Startup Axiado stammt und nicht mehr wie beim GB200 von Aspeed. Endkunden werden nun die restlichen Komponenten der Rechenplatine direkt beziehen; der zweite Speicherpegel wird LPCAMM-Module anstelle von gelöteten LPDDR5X-Modulen verwenden. Micron wird der Hauptlieferant dieser Module sein. Das Switching-Tray und die Kupferrückplatte bleiben unverändert und werden vollständig von Nvidia geliefert.

Die Umstellung auf SXM Puck bietet mehr OEMs und ODMs die Möglichkeit, an der Rechenplatine mitzuwirken. Früher konnten nur Wistron und Foxconn Bianca-Rechenplatinen herstellen, jetzt können mehr OEMs und ODMs beteiligt sein. Wistron ist der größte Verlierer in Form von ODMs, da sie Marktanteile bei Bianca-Platinen verloren haben. Für Foxconn wird der Verlust von Marktanteilen bei Bianca-Platinen durch die Tatsache ausgeglichen, dass sie der exklusive Hersteller von SXM Puck und SXM Puck-Sockets sind. Nvidia versucht, weitere Anbieter für Puck und Sockets zu gewinnen, hat aber noch keine weiteren Aufträge erteilt.

Eine weitere große Änderung betrifft den VRM-Inhalt. Obwohl sich einige VRM-Inhalte auf dem SXM Puck befinden, wird der größte Teil des Onboard-VRM-Inhalts von Hyperscalern/OEMs direkt von VRM-Anbietern bezogen. Monolithic Power Systems wird aufgrund des Geschäftsmodellwechsels Marktanteile verlieren.

Nvidia bietet mit dem GB300-System auch 800G ConnectX-8 NICs an, die die doppelte Erweiterungsbandbreite über InfiniBand und Ethernet bieten. Nvidia hatte ConnectX-8 für GB200 aufgrund von Herausforderungen beim Markteinführungszeitpunkt und der Aufgabe, PCIe Gen6 auf der Bianca-Platine zu aktivieren, gestrichen.

ConnectX-8 ist eine enorme Verbesserung gegenüber ConnectX-7. Es bietet nicht nur die doppelte Bandbreite, sondern auch 48 PCIe-Lanes anstelle von 32 PCIe-Lanes, was einzigartige Architekturen wie die luftgekühlte MGX B300A ermöglicht. Darüber hinaus verfügt ConnectX-8 über SpectrumX-Funktionen, während bei den vorherigen 400G-Produkten SpectrumX eine weniger effiziente Bluefield3 DPU benötigte.

Auswirkungen von GB300 auf Hyperscaler

Die Auswirkungen der Latenz von GB200 und GB300 auf Hyperscaler bedeuten, dass viele Bestellungen ab Q3 auf die neuen, teureren GPUs von Nvidia umgestellt werden. Bis letzte Woche hatten sich alle Hyperscaler für GB300 entschieden. Dies liegt teilweise an der höheren Leistung von GB300, aber auch daran, dass sie ihr Schicksal selbst in die Hand nehmen können.

Aufgrund von Herausforderungen beim Markteinführungszeitpunkt und erheblichen Änderungen bei Rack, Kühlung und Stromversorgung/Dichte konnten Hyperscaler bei GB200 keine großen Änderungen auf Serverebene vornehmen. Dies führte dazu, dass Meta die Hoffnung auf Multi-Source-NICs von Broadcom und Nvidia aufgab und vollständig auf Nvidia setzte. In anderen Fällen, wie bei Google, gaben sie ihre internen NICs auf und verwenden nur noch Nvidia.

Für Tausende von Mitarbeitern in Hyperscaler-Organisationen, die daran gewöhnt sind, alle Kosten zu optimieren – von der CPU über das Netzwerk bis hin zu Schrauben und Metallplatten – ist dies einfach unglaublich.

Das schockierendste Beispiel ist Amazon, das sich für eine sehr ungünstige Konfiguration entschieden hat, deren Gesamtbetriebskosten (TCO) schlechter sind als beim Referenzdesign. Da Amazon PCIe-Switches und weniger effiziente 200G-Elastische-Faser-Adapter-NICs verwendet, ist Luftkühlung erforderlich, sodass keine NVL72-Racks wie bei Meta, Google, Microsoft, Oracle, X.AI und Coreweave eingesetzt werden können. Aufgrund seiner internen NICs musste Amazon NVL36 verwenden, was aufgrund des höheren Backplane- und Switch-Inhalts auch höhere Kosten pro GPU verursacht. Zusammenfassend lässt sich sagen, dass die Konfiguration von Amazon aufgrund der Einschränkungen bei der Anpassung nicht optimal ist.

Mit GB300 können Hyperscaler nun mehr Komponenten wie Motherboards, Kühlung usw. anpassen. Dies ermöglicht es Amazon, ein eigenes kundenspezifisches Motherboard zu entwickeln, das mit Wasserkühlung ausgestattet ist und zuvor luftgekühlte Komponenten wie den Astera Labs PCIe-Switch integriert. Da mehr Komponenten wassergekühlt sind und HVM im dritten Quartal 2025 endlich auf dem K2V6400G-NIC verfügbar ist, bedeutet dies, dass Amazon zur NVL72-Architektur zurückkehren und seine TCO deutlich verbessern kann.

Der größte Nachteil ist, dass Hyperscaler mehr Inhalte entwerfen, validieren und bestätigen müssen. Dies könnte leicht die komplexeste Plattform werden, die Hyperscaler jemals entwickeln mussten (mit Ausnahme des TPU-Systems von Google). Einige Hyperscaler werden in der Lage sein, schnell zu entwickeln, aber andere Teams, die langsamer sind, werden zurückfallen. Obwohl es Marktberichte über Stornierungen gibt, gehen wir davon aus, dass Microsoft aufgrund seiner langsameren Entwicklungsgeschwindigkeit zu den langsamsten Unternehmen beim Einsatz von GB300 gehört und im vierten Quartal noch einige GB200 kaufen wird.

Die Preisdifferenz, die Kunden zahlen, ist sehr unterschiedlich, da Komponenten aus dem Gewinnstapel von Nvidia entnommen und an ODMs weitergegeben werden. Die Einnahmen der ODMs werden beeinträchtigt, und vor allem die Bruttomarge von Nvidia wird sich im Laufe des Jahres ändern.