Am 26. Dezember 2024 veröffentlichte das chinesische KI-Startup DeepSeek sein neuestes großes Sprachmodell, DeepSeek-V3. Dieses Modell zeichnet sich durch seinen Open-Source-Charakter und seine innovativen Herausforderungen an etablierte KI-Anbieter aus.

DeepSeek-V3 verfügt über 671 Milliarden Parameter und nutzt eine Mixture-of-Experts-Architektur (MoE), um spezifische Parameter zu aktivieren und Aufgaben präzise und effizient zu bewältigen. Laut DeepSeks Benchmark-Tests übertrifft das neue Modell führende Open-Source-Modelle wie Metas Llama 3.1-405B und erreicht eine ähnliche Leistung wie geschlossene Modelle von Anthropic und OpenAI.

Die Veröffentlichung von DeepSeek-V3 verkürzt die Lücke zwischen Open-Source- und Closed-Source-KI. DeepSeek, ursprünglich ein Ableger des chinesischen quantitativen Hedgefonds High-Flyer Capital Management, hofft, dass diese Entwicklungen den Weg für Künstliche Allgemeine Intelligenz (AGI) ebnen, bei der Modelle in der Lage sind, jede intellektuelle Aufgabe zu verstehen oder zu lernen, die ein Mensch ausführen kann.

Die Hauptmerkmale von DeepSeek-V3 umfassen:

Ähnlich wie sein Vorgänger DeepSeek-V2 basiert das neue Modell auf der grundlegenden Architektur von Multi-Head Latent Attention (MLA) und DeepSeekMoE, was ein effizientes Training und Inferenz gewährleistet.

Das Unternehmen führte außerdem zwei Innovationen ein: eine verlustfreie Lastenausgleichsstrategie und die Multi-Token-Prediction (MTP). Letztere ermöglicht es dem Modell, mehrere zukünftige Tokens gleichzeitig vorherzusagen, was die Trainingseffizienz steigert und die Modellgeschwindigkeit verdreifacht (60 Tokens pro Sekunde).

In der Pre-Training-Phase wurde DeepSeek-V3 mit 14,8 Billionen hochwertigen und diversen Tokens trainiert und durchlief eine zweistufige Erweiterung der Kontextlänge. Anschließend folgte ein Supervised Fine-Tuning (SFT) und Reinforcement Learning (RL), um das Modell an menschliche Präferenzen anzupassen und sein Potenzial weiter auszuschöpfen.

Während des Trainings setzte DeepSeek verschiedene Hardware- und Algorithmusoptimierungen ein, darunter ein FP8-Mixed-Precision-Trainingsframework und den DualPipe-Algorithmus für Pipeline-Parallelität, wodurch die Trainingskosten gesenkt wurden. Der gesamte Trainingsprozess von DeepSeek-V3 soll innerhalb von 2788K H800-GPU-Stunden oder etwa 5,57 Millionen US-Dollar abgeschlossen worden sein – deutlich weniger als die üblicherweise für das Pre-Training großer Sprachmodelle benötigten Hunderte von Millionen US-Dollar.

DeepSeek-V3 hat sich als eines der leistungsstärksten Open-Source-Modelle auf dem Markt etabliert. Mehrere Benchmark-Tests des Unternehmens zeigen, dass es in den meisten Benchmarks das Closed-Source-Modell GPT-4o übertrifft, mit Ausnahme von SimpleQA und FRAMES (beide englischsprachig fokussiert), wo das OpenAI-Modell mit 38,2 bzw. 80,5 Punkten (DeepSeek-V3: 24,9 bzw. 73,3) vorne liegt. Besonders hervorzuheben ist die Leistung von DeepSeek-V3 bei chinesischen und mathematischen Benchmark-Tests, mit einem Score von 90,2 im Math-500-Test, gefolgt von Qwen mit 80 Punkten.

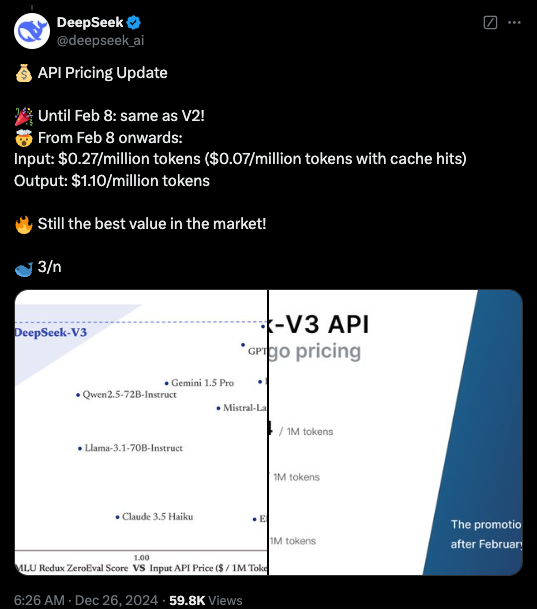

Derzeit ist der Code von DeepSeek-V3 unter der MIT-Lizenz auf GitHub verfügbar, das Modell wird unter der Modelllizenz des Unternehmens bereitgestellt. Unternehmen können das neue Modell auch über DeepSeek Chat (eine ChatGPT-ähnliche Plattform) testen und über eine API für kommerzielle Zwecke nutzen. DeepSeek wird bis zum 8. Februar die gleichen API-Preise wie für DeepSeek-V2 anbieten. Danach werden 0,27 US-Dollar pro Million Eingabe-Tokens (0,07 US-Dollar pro Million Tokens bei Cache-Treffern) und 1,10 US-Dollar pro Million Ausgabe-Tokens berechnet.

Highlights:

🌟 DeepSeek-V3 veröffentlicht, übertrifft Llama und Qwen.

🔧 671 Milliarden Parameter und Mixture-of-Experts-Architektur für höhere Effizienz.

🚀 Innovationen wie verlustfreie Lastenausgleichsstrategie und Multi-Token-Prediction für höhere Geschwindigkeit.

💼 Deutlich reduzierte Trainingskosten, fördert die Entwicklung von Open-Source-KI.