Am 26. Dezember veröffentlichte Huanfang Quantization sein neues großes Sprachmodell DeepSeek-V3, das einen bemerkenswerten technologischen Durchbruch darstellt. Dieses Modell, das auf der MoE-Architektur (Mixture of Experts) basiert, erreicht nicht nur eine Leistung, die mit den besten proprietären Modellen vergleichbar ist, sondern zeichnet sich auch durch seine kostengünstige und effiziente Funktionsweise aus, was in der Branche großes Interesse geweckt hat.

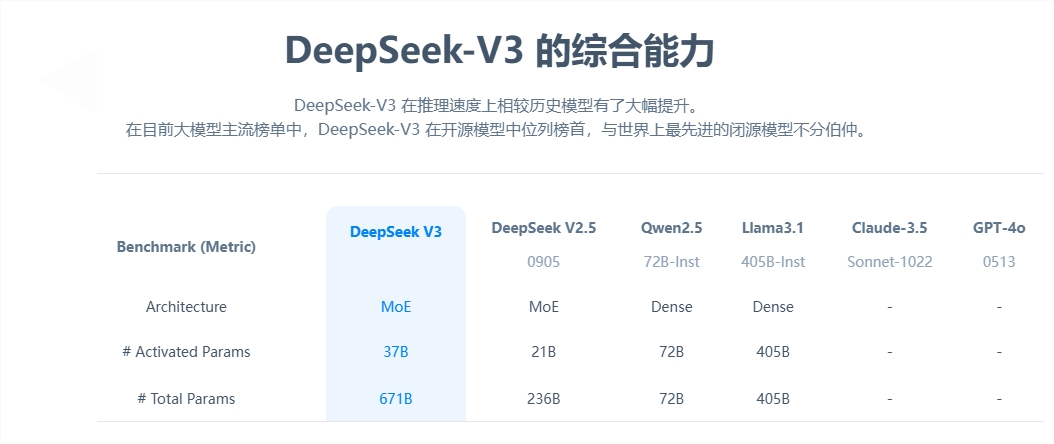

Betrachtet man die Kernparameter, so verfügt DeepSeek-V3 über 671 Milliarden Parameter, davon 37 Milliarden Aktivierungsparameter. Das Modell wurde mit 14,8 Billionen Tokens trainiert. Im Vergleich zum Vorgängermodell ist die Generierungsgeschwindigkeit um das Dreifache gestiegen und erreicht nun 60 Tokens pro Sekunde, was die Effizienz in der praktischen Anwendung deutlich verbessert.

In Leistungstests hat DeepSeek-V3 seine herausragende Leistungsfähigkeit unter Beweis gestellt. Es übertrifft nicht nur bekannte Open-Source-Modelle wie Qwen2.5-72B und Llama-3.1-405B, sondern erreicht in vielen Tests auch ein vergleichbares Niveau wie GPT-4 und Claude-3.5-Sonnet. Besonders im Mathematiktest übertraf das Modell alle bestehenden Open-Source- und proprietären Modelle.

Am bemerkenswertesten ist der kostengünstige Aspekt von DeepSeek-V3. Laut der veröffentlichten Open-Source-Arbeit betrugen die gesamten Trainingskosten bei einem Preis von 2 US-Dollar pro GPU-Stunde nur 5,576 Millionen US-Dollar. Dieser bahnbrechende Erfolg ist der synergetischen Optimierung von Algorithmus, Framework und Hardware zu verdanken. OpenAI-Mitgründer Karpathy lobte dies und betonte, dass DeepSeek-V3 mit nur 2,8 Millionen GPU-Stunden eine Leistung erreicht hat, die Llama3 übertrifft, was eine Steigerung der Rechenleistung um etwa das 11-fache bedeutet.

Im Hinblick auf die Kommerzialisierung ist der Preis für den DeepSeek-V3 API-Dienst zwar im Vergleich zur vorherigen Generation gestiegen, bietet aber immer noch ein hohes Preis-Leistungs-Verhältnis. Der neue Preis liegt bei 0,5 bis 2 Yuan pro Million Eingabe-Tokens und 8 Yuan pro Million Ausgabe-Tokens, die Gesamtkosten betragen ca. 10 Yuan. Im Vergleich dazu kostet ein vergleichbarer Service von GPT-4 ca. 140 Yuan, was einen deutlichen Preisunterschied darstellt.

Als vollständig Open-Source-Großmodell zeigt die Veröffentlichung von DeepSeek-V3 nicht nur den Fortschritt der chinesischen KI-Technologie, sondern bietet Entwicklern und Unternehmen auch eine leistungsstarke und kostengünstige KI-Lösung.