Zum Jahresabschluss 2024 veröffentlichte die Beijing Zhihu Zhang Technology Co., Ltd. die erste Version ihres auf erweitertem verstärktem Lernen basierenden Inferenzmodells – GLM-Zero-Preview. Dieses Modell konzentriert sich auf die Verbesserung der Inferenzfähigkeit von künstlicher Intelligenz, insbesondere in den Bereichen mathematische Logik, Code-Erstellung und komplexer Problemlösung, die tiefes Denken erfordern. Im Vergleich zum Basismodell zeigt GLM-Zero-Preview eine deutliche Verbesserung der Expertenfähigkeiten bei gleichzeitiger Beibehaltung der Fähigkeiten für allgemeine Aufgaben. Seine Leistung in den Benchmarks AIME2024, MATH500 und LiveCodeBench ist vergleichbar mit OpenAI o1-preview.

Benutzer können GLM-Zero-Preview jetzt kostenlos auf der Plattform „Zhihu Qingyan“ im „Zero Inferenzmodell“-Agenten testen. Die Plattform unterstützt das Hochladen von Text und Bildern, wobei das Modell den vollständigen Inferenzprozess ausgibt. Entwickler können das Modell auch über die API der Zhihu Open Platform aufrufen.

Obwohl GLM-Zero-Preview noch eine gewisse Lücke zu OpenAIs o3-Modell aufweist, plant die Beijing Zhihu Zhang Technology Co., Ltd., die Technologie des verstärkten Lernens kontinuierlich zu optimieren und zu iterieren und wird in Kürze die offizielle Version von GLM-Zero veröffentlichen, um die Fähigkeit zum tiefen Denken von der mathematischen Logik auf weitere allgemeine technische Bereiche auszuweiten.

In Bezug auf die Modellleistung zeigt GLM-Zero-Preview die Bedeutung des verstärkten Lernens für die Verbesserung der Fähigkeit von Modellen zum tiefen Denken. Mit zunehmender Trainingsmenge verbessert sich die Leistung des Modells in Bereichen wie dem tiefen Denken stetig. Das Scaling Law des Modells in der Inferenzphase wurde ebenfalls bestätigt, d. h. mit zunehmender Anzahl der Token, über die das Modell nachdenken kann, und größerem Rechenaufwand verbessert sich auch die Qualität der vom Modell gelieferten Ergebnisse stetig. GLM-Zero-Preview kann im Inferenzprozess selbstständig Entscheidungen treffen, Probleme zerlegen und verschiedene Lösungsansätze ausprobieren, ähnlich dem Denk- und Entscheidungsprozess eines Menschen.

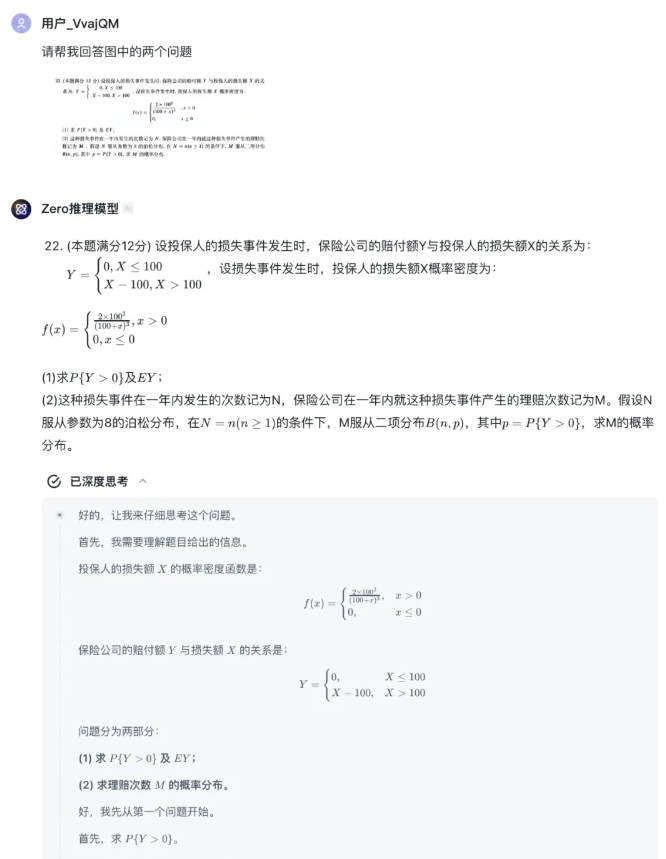

In praktischen Beispielen zeigt GLM-Zero-Preview im Bereich der logischen Inferenz die Fähigkeit, logische Fehler zu erkennen und verschiedene Hypothesen zu simulieren. Im mathematischen Bereich verfügt das Modell über starke induktive und deduktive Fähigkeiten, kann komplexe mathematische Berechnungen schnell verarbeiten und erreichte im Mathematik-Eingangstest für die Zulassung zum Masterstudium 2025 das Niveau eines exzellenten Studenten.

Im Bereich der Programmierung kann GLM-Zero-Preview mehrere Programmiersprachen fließend verwenden und Entwicklern helfen, schnell Code zu schreiben.

Zhihu Qingyan:

https://chatglm.cn/main/gdetail/676411c38945bbc58a905d31?lang=zh

Zhihu Open Platform: