Im Bereich der Künstlichen Intelligenz hat das ByteDance Commercialization Technology Team mit seinem neuesten Modell Infinity, dank seiner herausragenden Leistung und innovativen Technologie, einen neuen Meilenstein im Bereich der autoregressiven Text-zu-Bild-Generierung gesetzt. Dieses neuartige Open-Source-Modell übertrifft Stable Diffusion 3 nicht nur in der Qualität der Bilderzeugung, sondern zeigt auch eine deutlich höhere Inferenzgeschwindigkeit.

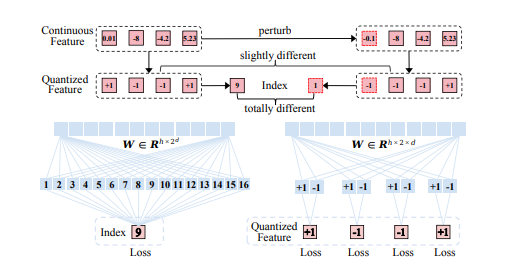

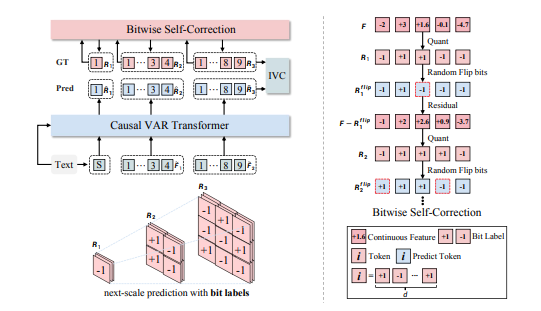

Die Kerninnovation von Infinity liegt in der Verwendung eines autoregressiven Frameworks mit Bitwise Tokens. Dieses Framework verbessert die Erfassung hochfrequenter Signale durch die Vorhersage von „Bitwise Tokens“, die aus +1 oder -1 in der nächsten Auflösungsstufe bestehen, wodurch detailreichere Bilder erzeugt werden. Darüber hinaus erweitert Infinity den Vokabularumfang auf unendlich, wodurch der Repräsentationsraum des Image Tokenizers erheblich verbessert und die Leistungsgrenze der autoregressiven Text-zu-Bild-Generierung erhöht wird.

Im Leistungsvergleich zeigt Infinity unter den autoregressiven Methoden eine herausragende Performance und übertrifft Methoden wie HART, LlamaGen und Emu3 deutlich. In menschlichen Bewertungen erzielte es eine Siegquote von fast 90% gegen das HART-Modell. Gleichzeitig besiegte Infinity SOTA-Diffusionsmodelle wie PixArt-Sigma, SD-XL und SD3-Medium mit Siegquoten von 75%, 80% und 65%, was seine Vorteile bei Modellen vergleichbarer Größe unterstreicht.

Ein weiteres wichtiges Merkmal von Infinity ist seine gute Skalierbarkeit. Mit zunehmender Modellgröße und steigendem Ressourceneinsatz sinken die Validierungsverluste stetig, und die Validierungsgenauigkeit verbessert sich kontinuierlich. Darüber hinaus wurde die Bit-Selbstkorrekturtechnik eingeführt, um die Selbstkorrekturfähigkeit des Modells zu verbessern und das Problem der kumulativen Fehler bei der autoregressiven Inferenz zu reduzieren.

In Bezug auf die Inferenzgeschwindigkeit profitiert Infinity von den Geschwindigkeitsvorteilen von VAR. Das 2B-Modell benötigt nur 0,8 Sekunden, um ein 1024x1024-Bild zu generieren – dreimal schneller als das gleichgroße SD3-Medium und 14-mal schneller als das 12B Flux Dev-Modell. Das 8B-Modell ist siebenmal schneller als das gleichgroße SD3.5, und das 20B-Modell benötigt 3 Sekunden für ein 1024x1024-Bild, fast viermal schneller als das 12B Flux Dev-Modell.

Derzeit sind der Trainings- und Inferenzcode, Demos und Modellgewichte von Infinity auf GitHub verfügbar. Eine Website-Demo ermöglicht Nutzern einen einfachen Zugriff zum Testen und Bewerten des Modells.

Projektseite: https://foundationvision.github.io/infinity.project/