Das Forschungsteam des Alibaba DAMO Academy hat kürzlich ein wichtiges Forschungsergebnis mit dem Titel „SHMT: Self-Supervised Hierarchical Makeup Transfer“ veröffentlicht, das auf der renommierten internationalen Konferenz NeurIPS2024 angenommen wurde. Diese Studie präsentiert eine neue Technik zur Übertragung von Make-up-Effekten, die latente Diffusionsmodelle (Latent Diffusion Models) nutzt, um eine präzise Generierung von Make-up-Bildern zu ermöglichen und so neue Impulse für Make-up-Anwendungen und die Bildverarbeitung bietet.

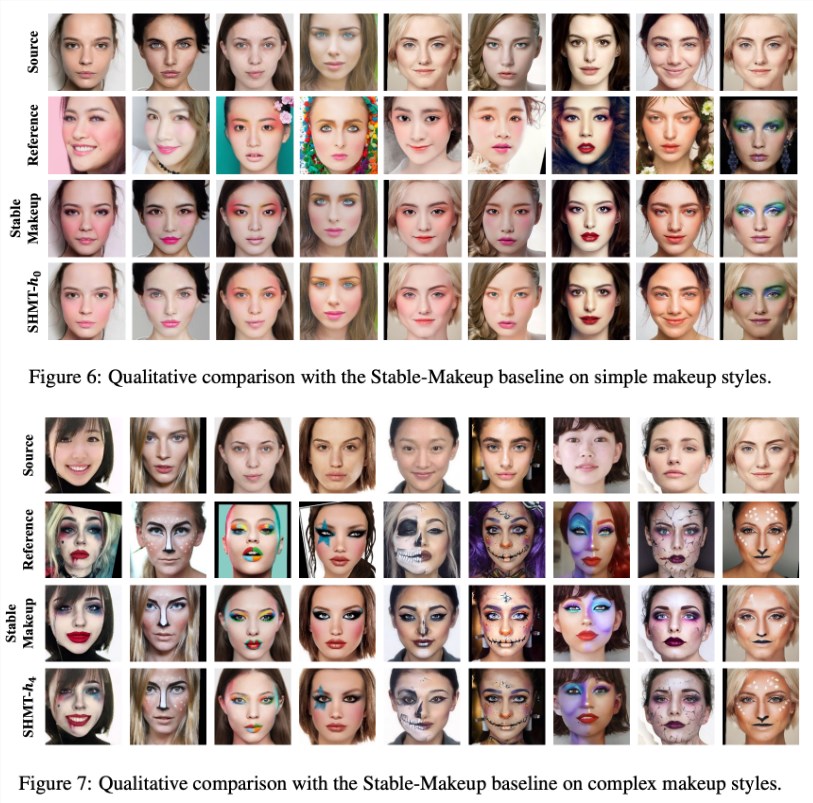

Vereinfacht gesagt, ist SHMT eine Make-up-Übertragungstechnik. Mit nur einem Referenzbild mit Make-up und einem Foto des Zielobjekts kann der Make-up-Effekt auf das Gesicht des Zielobjekts übertragen werden.

Das Team hat das Projekt Open Source veröffentlicht, inklusive Trainingscode, Testcode und vortrainierten Modellen, um Forschern die Arbeit zu erleichtern.

Für den Modellaufbau empfiehlt das Team, eine conda-Umgebung namens „ldm“ zu erstellen und die Einrichtung mithilfe der bereitgestellten Umgebungsdatei zu beschleunigen. Darüber hinaus wurde VQ-f4 als vortrainiertes Autoencoder-Modell verwendet. Dieses muss heruntergeladen und in den angegebenen Checkpoint-Ordner gelegt werden, um die Inferenz zu starten.

Die Datenvorbereitung ist entscheidend für den erfolgreichen Betrieb des SHMT-Modells. Das Forschungsteam empfiehlt, den von „BeautyGAN“ bereitgestellten Make-up-Übertragungsdatensatz herunterzuladen und verschiedene Make-up- und Nicht-Make-up-Bilder zu kombinieren. Die Vorbereitung der Gesichtsanalyse und 3D-Gesichtsdaten ist ebenfalls unerlässlich. Die entsprechenden Tools und Datenpfade werden in der Studie detailliert beschrieben, um eine effiziente Datenvorbereitung zu gewährleisten.

Für das Modelltraining und die Inferenz stellt das Team detaillierte Kommandozeilen-Skripte bereit, deren Parameter nach Bedarf angepasst werden können. Die Bedeutung der Datenstruktur wird besonders hervorgehoben, und es wird ein klares Beispiel für die Verzeichnisstruktur gegeben, um die Datenvorbereitung zu leiten.

Die Einführung des SHMT-Modells markiert die erfolgreiche Anwendung des selbstüberwachten Lernens im Bereich der Make-up-Effektübertragung und könnte zukünftig in der Schönheits-, Kosmetik- und Bildverarbeitungsindustrie breite Anwendung finden. Diese Studie zeigt nicht nur das Potenzial der Technologie, sondern legt auch ein solides Fundament für weiterführende Forschung in diesem Bereich.

Projekt-Link:https://github.com/Snowfallingplum/SHMT

Wichtigste Punkte:

1. 🎓 Das SHMT-Modell nutzt latente Diffusionsmodelle zur Übertragung von Make-up-Effekten und wurde von NeurIPS2024 angenommen.

2. 🔧 Das Team stellt vollständigen Open-Source-Code und vortrainierte Modelle bereit, um Forschern die Anwendung und Verbesserung zu erleichtern.

3. 📂 Die Datenvorbereitung und Parameteranpassung sind entscheidend. Die Studie enthält detaillierte Anleitungen zum Ablauf und zur Verzeichnisstruktur.