ByteDance hat kürzlich LatentSync veröffentlicht, ein neuartiges Framework für die Lippensynchronisation, das ein auf Audio bedingtes latentes Diffusionsmodell nutzt, um eine präzisere Lippensynchronisation zu erreichen. Das Framework basiert auf Stable Diffusion und wurde hinsichtlich der zeitlichen Konsistenz optimiert.

Im Gegensatz zu bisherigen Methoden, die auf der Diffusion im Pixelraum oder zweistufiger Generierung basieren, verwendet LatentSync einen End-to-End-Ansatz. Es benötigt keine Zwischenrepräsentation der Bewegung und kann die komplexe Beziehung zwischen Audio und visuellen Daten direkt modellieren.

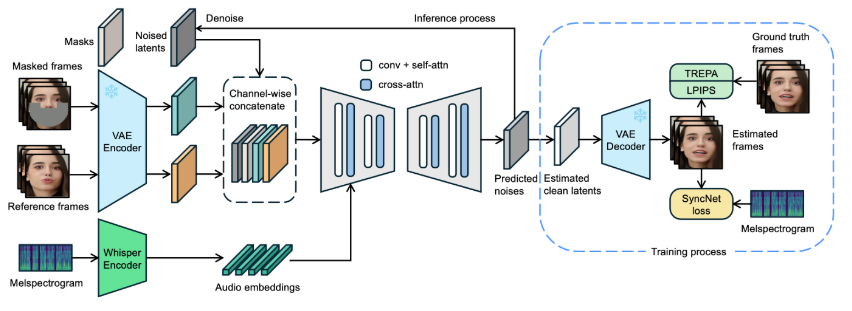

In LatentSync wird zunächst mithilfe von Whisper ein Audio-Spektrogramm in eine Audio-Einbettung umgewandelt und über eine Cross-Attention-Schicht in das U-Net-Modell integriert. Das Framework verwendet die Referenzframes und Maskierungsframes, die mit verrauschten latenten Variablen auf Kanalebene verkettet sind, als Eingabe für das U-Net.

Während des Trainings wird in einem einstufigen Verfahren aus dem vorhergesagten Rauschen die saubere latente Variable geschätzt und anschließend decodiert, um einen sauberen Frame zu generieren. Gleichzeitig führt das Modell den Temporal REPresentation Alignment (TREPA)-Mechanismus ein, um die zeitliche Konsistenz zu verbessern und sicherzustellen, dass das generierte Video bei genauer Lippensynchronisation auch zeitlich kohärent bleibt.

Um die Effektivität dieser Technologie zu demonstrieren, bietet das Projekt eine Reihe von Beispielvideos, die das Originalvideo und das nach der Lippensynchronisierung bearbeitete Video zeigen. Anhand dieser Beispiele kann der Benutzer die deutlichen Fortschritte von LatentSync bei der Lippensynchronisierung von Videos visuell erleben.

Originalvideo:

Ausgabevideo:

Darüber hinaus ist geplant, den Inferenzcode und die Checkpoints Open Source bereitzustellen, um Nutzern das Training und Testen zu erleichtern. Für Benutzer, die Inferenz ausprobieren möchten, müssen lediglich die notwendigen Modellgewichtsdateien heruntergeladen werden. Der gesamte Datenverarbeitungsprozess ist bereits konzipiert und umfasst alle Schritte von der Videoverarbeitung bis zur Gesichtsausrichtung, um Nutzern einen einfachen Einstieg zu ermöglichen.

Modellprojekt-Eingang: https://github.com/bytedance/LatentSync

Wichtigste Punkte:

🌟 LatentSync ist ein End-to-End-Lippensynchronisations-Framework, das auf einem auf Audio bedingten latenten Diffusionsmodell basiert und keine Zwischenrepräsentation der Bewegung benötigt.

🎤 Das Framework nutzt Whisper, um Audio-Spektrogramme in Einbettungen umzuwandeln, wodurch die Genauigkeit und zeitliche Konsistenz des Modells während der Lippensynchronisation verbessert werden.

📹 Das Projekt bietet eine Reihe von Beispielvideos und plant, den entsprechenden Code und den Datenverarbeitungsprozess Open Source bereitzustellen, um die Nutzung und das Training für Benutzer zu vereinfachen.