Mit der rasanten Entwicklung der Videotechnologie ist Video zu einem wichtigen Werkzeug für die Informationsbeschaffung und das Verständnis komplexer Konzepte geworden. Videos kombinieren visuelle, zeitliche und kontextuelle Daten und bieten eine multimodale Darstellung, die über statische Bilder und Texte hinausgeht. Die Verbreitung von Videoplattformen und das Aufkommen zahlreicher Bildungs- und Informationsvideos bieten heute beispiellose Möglichkeiten, Videos als Wissensquelle zu nutzen, um Anfragen zu beantworten, die detaillierte Hintergründe, räumliches Verständnis und Prozessdemonstrationen erfordern.

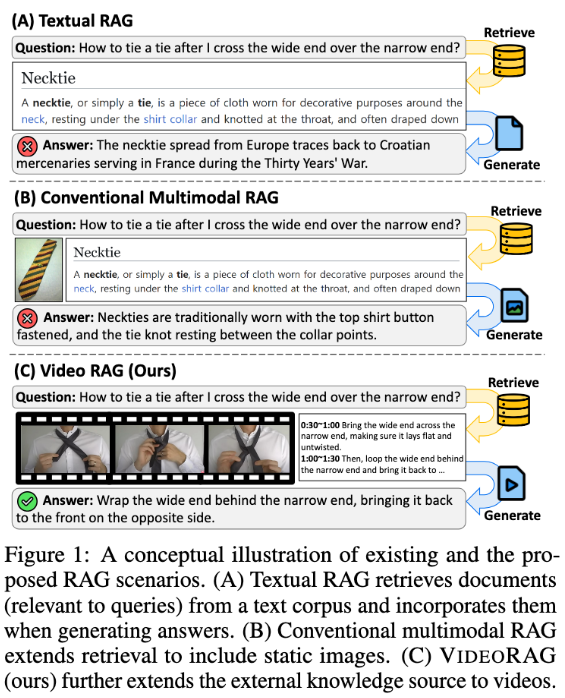

Bestehende Retrieval-Augmented Generation (RAG)-Systeme nutzen jedoch oft nicht das volle Potenzial von Videodaten. Diese Systeme verlassen sich in der Regel auf Textinformationen und verwenden gelegentlich statische Bilder zur Unterstützung der Antwort auf Abfragen, erfassen aber nicht die visuelle Dynamik und multimodale Hinweise, die in Videos enthalten sind und für komplexe Aufgaben entscheidend sind. Traditionelle Methoden definieren entweder abfragebezogene Videos ohne Retrieval vor oder wandeln Videos in Textformate um, wodurch wichtige visuelle Kontexte und zeitliche Dynamiken verloren gehen und die Fähigkeit, genaue und informative Antworten zu liefern, eingeschränkt wird.

Um diese Probleme zu lösen, hat ein Forschungsteam des Korea Advanced Institute of Science and Technology (KAIST) und von DeepAuto.ai einen neuartigen Rahmen namens VideoRAG vorgestellt. Dieser Rahmen kann dynamisch abfragebezogene Videos abrufen und visuelle und textuelle Informationen in den Generierungsprozess integrieren. VideoRAG nutzt fortschrittliche große Video-Sprachmodelle (LVLMs) für eine nahtlose Integration multimodaler Daten, um sicherzustellen, dass die abgerufenen Videos kontextuell mit der Benutzerabfrage übereinstimmen und die zeitliche Reichhaltigkeit des Videomaterials erhalten bleibt.

Der Workflow von VideoRAG besteht aus zwei Hauptphasen: Retrieval und Generierung. In der Retrieval-Phase identifiziert der Rahmen Videos, die visuell und textuell ähnliche Merkmale aufweisen wie die Abfrage.

In der Generierungsphase werden mithilfe der automatischen Spracherkennung (ASR) unterstützende Textdaten für Videos ohne Untertitel generiert, um sicherzustellen, dass alle Videos effektiv zur Antwortgenerierung beitragen. Die abgerufenen Videos werden dann an das Generierungsmodul übergeben, das multimodale Daten wie Videobilder, Untertitel und Abfragetext integriert und mit LVLMs verarbeitet, um lange, informative, genaue und kontextuell passende Antworten zu generieren.

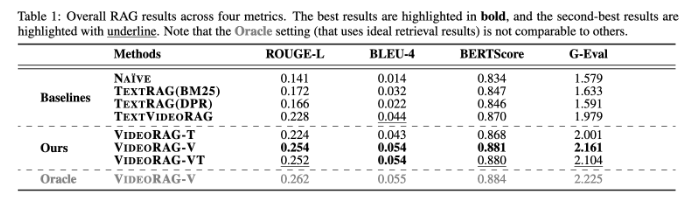

VideoRAG wurde in umfangreichen Experimenten auf Datensätzen wie WikiHowQA und HowTo100M getestet, die eine deutlich höhere Antwortqualität im Vergleich zu traditionellen Methoden zeigten. Dieser neue Rahmen verbessert nicht nur die Fähigkeiten von Retrieval-Augmented Generation-Systemen, sondern setzt auch neue Maßstäbe für zukünftige multimodale Retrieval-Systeme.

论文:https://arxiv.org/abs/2501.05874

Highlights:

📹 ** Neuer Rahmen **: VideoRAG ruft dynamisch relevante Videos ab und integriert visuelle und textuelle Informationen, um die Generierungsergebnisse zu verbessern.

🔍 ** Experimentelle Validierung **: Tests auf mehreren Datensätzen zeigen eine deutlich höhere Antwortqualität im Vergleich zu traditionellen RAG-Methoden.

🌟 ** Technologische Innovation **: Mit großen Video-Sprachmodellen ebnet VideoRAG den Weg für eine neue Ära der multimodalen Datenintegration.