Hugging Face hat ein bemerkenswertes KI-Modell vorgestellt – SmolVLM. Dieses visuelle Sprachmodell ist so klein, dass es auf kleinen Geräten wie Smartphones laufen kann und übertrifft dabei die Leistung seiner Vorgängermodelle, die große Rechenzentren benötigen.

Das SmolVLM-256M-Modell benötigt weniger als 1 GB GPU-Speicher, übertrifft aber sein Vorgängermodell Idefics80B, das 300-mal größer ist. Dies ist ein bedeutender Fortschritt für den praktischen Einsatz von KI.

Laut Andrés Marrafiotti, Machine Learning Research Engineer bei Hugging Face, bietet SmolVLM Unternehmen gleichzeitig eine deutliche Senkung der Rechenkosten. „Unser zuvor veröffentlichtes Idefics80B war im August 2023 das erste Open-Source-Video-Sprachmodell, und SmolVLM reduziert das Volumen um das 300-fache bei gleichzeitiger Leistungssteigerung“, sagte Marrafiotti in einem Interview mit dem „Entrepreneur Daily“.

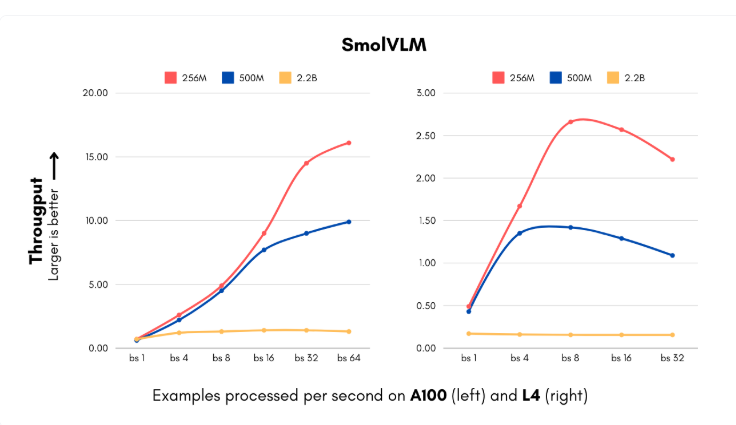

Die Einführung von SmolVLM kommt zu einem Zeitpunkt, an dem Unternehmen mit hohen Rechenkosten bei der Implementierung von KI-Systemen zu kämpfen haben. Das neue Modell umfasst zwei Parametergrößen (256M und 500M) und kann Bilder mit einer bisher unvorstellbaren Geschwindigkeit verarbeiten und visuelle Inhalte verstehen. Die kleinste Version erreicht eine Verarbeitungsgeschwindigkeit von 16 Instanzen pro Sekunde und benötigt nur 15 GB Arbeitsspeicher. Dies ist besonders für Unternehmen geeignet, die große Mengen visueller Daten verarbeiten müssen. Für mittelständische Unternehmen, die monatlich 1 Million Bilder verarbeiten, bedeutet dies eine erhebliche jährliche Einsparung bei den Rechenkosten.

Darüber hinaus hat IBM mit Hugging Face zusammengearbeitet, um das 256M-Modell in seine Dokumentenverarbeitungssoftware Docling zu integrieren. Obwohl IBM über umfangreiche Rechenressourcen verfügt, ermöglicht die Verwendung des kleineren Modells eine effiziente und kostengünstige Verarbeitung von Millionen von Dokumenten.

Das Hugging Face-Team hat durch technische Innovationen bei der visuellen Verarbeitung und den Sprachkomponenten die Modellgröße reduziert, ohne an Leistung einzubüßen. Sie ersetzten den ursprünglichen 400M-Parameter-Bildencoder durch eine 93M-Parameter-Version und implementierten eine aggressivere Token-Komprimierungstechnik. Diese Innovationen ermöglichen es kleinen und mittelständischen Unternehmen sowie Startups, in kurzer Zeit komplexe Computer-Vision-Produkte auf den Markt zu bringen, wobei die Infrastrukturkosten deutlich sinken.

Der Trainingssatz von SmolVLM umfasst 170 Millionen Trainingsbeispiele, von denen fast die Hälfte für die Dokumentenverarbeitung und Bildbeschriftung verwendet wurde. Diese Entwicklungen senken nicht nur die Kosten, sondern eröffnen Unternehmen auch völlig neue Anwendungsmöglichkeiten und verbessern die Fähigkeiten im Bereich der visuellen Suche auf ein bisher unerreichtes Niveau.

Dieser Fortschritt von Hugging Face stellt die traditionelle Vorstellung über den Zusammenhang zwischen Modellgröße und Leistung in Frage. SmolVLM beweist, dass auch kleine, effiziente Architekturen hervorragende Leistungen erzielen können. Die zukünftige Entwicklung von KI wird vielleicht nicht mehr das Streben nach größeren Modellen sein, sondern nach flexibleren und effizienteren Systemen.

Modell: https://huggingface.co/blog/smolervlm

Wichtigste Punkte:

🌟 Das von Hugging Face entwickelte SmolVLM-Modell läuft auf Smartphones und übertrifft das 300-mal größere Idefics80B-Modell in der Leistung.

💰 SmolVLM hilft Unternehmen, die Rechenkosten deutlich zu senken, und erreicht eine Verarbeitungsgeschwindigkeit von 16 Instanzen pro Sekunde.

🚀 Die technischen Innovationen des Modells ermöglichen es kleinen und mittelständischen Unternehmen sowie Startups, in kurzer Zeit komplexe Computer-Vision-Produkte auf den Markt zu bringen.