Laut einer offiziellen Mitteilung des Doubao-Großmodellteams, das in Zusammenarbeit mit der Universität für Verkehrswesen Peking und der Universität für Wissenschaft und Technologie China forscht, wurde kürzlich das von dem Doubao-Großmodellteam entwickelte experimentelle Videoerzeugungsmodell „VideoWorld“ offiziell als Open Source veröffentlicht.

Das größte Highlight dieses Modells besteht darin, dass es nicht mehr auf traditionelle Sprachmodelle angewiesen ist, sondern die Welt allein anhand visueller Informationen erkennt und versteht. Diese bahnbrechende Forschungsinspiration stammt von Professor Fei-Fei Li's TED-Vortrag über die Idee, dass „Kleinkinder die reale Welt ohne Sprache verstehen können“.

„VideoWorld“ analysiert und verarbeitet große Mengen an Videodaten und erreicht so komplexe Fähigkeiten im Bereich des Schlussfolgerns, der Planung und der Entscheidungsfindung. Experimente des Forschungsteams zeigen, dass das Modell bereits mit nur 300 Millionen Parametern bemerkenswerte Ergebnisse erzielt. Im Gegensatz zu bestehenden Modellen, die auf sprachliche oder beschreibende Daten angewiesen sind, kann VideoWorld eigenständig Wissen erlernen, insbesondere bei komplexen Aufgaben wie Origami falten oder Krawatten binden, und bietet eine intuitivere Lernmethode.

Um die Effektivität des Modells zu überprüfen, hat das Forschungsteam zwei experimentelle Umgebungen aufgebaut: ein Go-Spiel und eine Robotersimulationskontrolle. Go, als ein hochstrategisches Spiel, dient zur effektiven Bewertung der Fähigkeiten des Modells im Bereich des Regellernens und des Schlussfolgerns, während die Roboteraufgabe die Leistung des Modells in Bezug auf Steuerung und Planung untersucht. In der Trainingsphase baut das Modell durch das Betrachten einer großen Anzahl von Video-Demonstrationsdaten schrittweise die Fähigkeit zur Vorhersage zukünftiger Bilder auf.

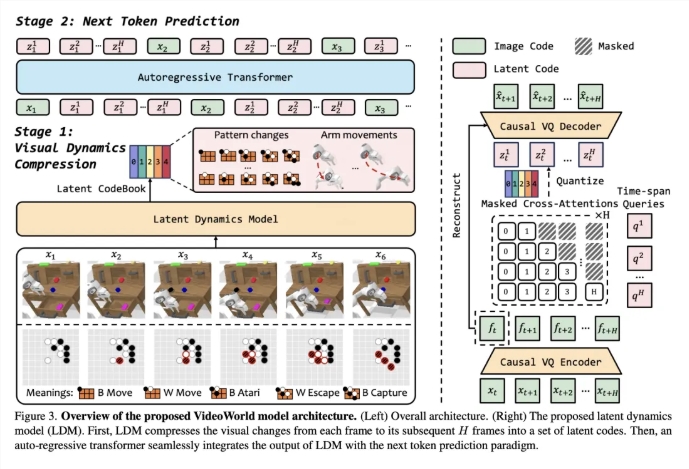

Um die Effizienz des Video-Lernens zu verbessern, hat das Team ein latentes dynamisches Modell (LDM) eingeführt, das darauf abzielt, die visuellen Veränderungen zwischen Videobildern zu komprimieren und so wichtige Informationen zu extrahieren. Diese Methode reduziert nicht nur redundante Informationen, sondern verbessert auch die Lernfähigkeit des Modells für komplexes Wissen. Durch diese Innovation zeigt VideoWorld herausragende Fähigkeiten in Go und Roboteraufgaben und erreicht sogar das Niveau eines professionellen 5-Dan-Go-Spielers.

Paper-Link: https://arxiv.org/abs/2501.09781

Code-Link: https://github.com/bytedance/VideoWorld

Projektseite: https://maverickren.github.io/VideoWorld.github.io

Wichtigste Punkte:

🌟 Das „VideoWorld“-Modell kann Wissen allein anhand visueller Informationen lernen und ist nicht auf Sprachmodelle angewiesen.

🤖 Das Modell zeigt herausragende Fähigkeiten im Schlussfolgern und Planen in Go-Spielen und Robotersimulationsaufgaben.

🔓 Der Code und das Modell dieses Projekts wurden als Open Source veröffentlicht. Alle Interessierten sind herzlich eingeladen, es auszuprobieren und sich auszutauschen.