Kürzlich veröffentlichte ein Forschungsteam von Microsoft in Zusammenarbeit mit mehreren Universitäten ein multimodales KI-Modell namens „Magma“. Dieses Modell wurde entwickelt, um verschiedene Datentypen wie Bilder, Texte und Videos zu verarbeiten und zu integrieren, um komplexe Aufgaben in digitalen und physischen Umgebungen zu bewältigen. Mit dem Fortschritt der Technologie finden multimodale KI-Agenten immer breitere Anwendung in Bereichen wie Robotik, virtuelle Assistenten und die Automatisierung von Benutzeroberflächen.

Bisherige KI-Systeme konzentrierten sich meist auf visuell-sprachliches Verständnis oder Roboterbedienung und konnten diese beiden Fähigkeiten nur schwer in einem einheitlichen Modell vereinen. Viele bestehende Modelle zeigen zwar in bestimmten Bereichen gute Leistungen, haben aber eine geringe Generalisierungsfähigkeit in verschiedenen Anwendungsszenarien. Beispielsweise zeigen Pix2Act und WebGUM hervorragende Ergebnisse in der UI-Navigation, während OpenVLA und RT-2 eher für die Roboterbedienung geeignet sind. Diese Modelle müssen jedoch oft separat trainiert werden und können die Grenzen zwischen digitalen und physischen Umgebungen nur schwer überwinden.

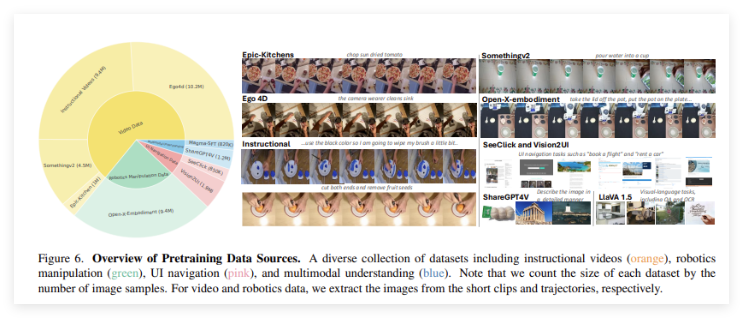

Das „Magma“-Modell wurde entwickelt, um diese Einschränkungen zu überwinden. Durch die Einführung einer leistungsstarken Trainingsmethode integriert es multimodales Verständnis, Aktionslokalisierung und Planung, um KI-Agenten einen nahtlosen Betrieb in verschiedenen Umgebungen zu ermöglichen. Der Trainingssatz von Magma umfasst 39 Millionen Beispiele, darunter Bilder, Videos und Roboter-Bewegungsbahnen. Darüber hinaus verwendet das Modell zwei innovative Technologien: „Set-of-Mark“ (SoM) und „Trace-of-Mark“ (ToM). Ersteres ermöglicht es dem Modell, in der Benutzeroberfläche interaktive visuelle Objekte zu markieren, während letzteres die Verfolgung der Bewegung von Objekten im Zeitverlauf ermöglicht und die Planung zukünftiger Aktionen verbessert.

„Magma“ verwendet eine fortschrittliche Deep-Learning-Architektur und groß angelegte Pre-Training-Techniken, um seine Leistung in verschiedenen Bereichen zu optimieren. Das Modell verwendet ConvNeXt-XXL als visuelle Backbone zur Verarbeitung von Bildern und Videos, während das LLaMA-3-8B Sprachmodell für die Verarbeitung von Texteingaben zuständig ist. Diese Architektur ermöglicht es „Magma“, visuelle, sprachliche und aktionsbezogene Informationen effizient zu integrieren. Nach einem umfassenden Training erzielte das Modell in mehreren Aufgaben hervorragende Ergebnisse und zeigte ein starkes multimodales Verständnis und räumliches Schlussfolgerungsvermögen.

Projektseite: https://microsoft.github.io/Magma/

Highlights:

🌟 Das Magma-Modell wurde mit über 39 Millionen Beispielen trainiert und verfügt über eine starke Fähigkeit zum multimodalen Lernen.

🤖 Das Modell integriert erfolgreich visuelle, sprachliche und aktionsbezogene Informationen und überwindet die Grenzen bestehender KI-Modelle.

📈 Magma zeigt in mehreren Benchmark-Tests hervorragende Ergebnisse und verfügt über eine starke Generalisierungsfähigkeit und exzellente Entscheidungs- und Ausführungsfähigkeiten.