Das japanische KI-Startup Sakana AI hat den „AI CUDA Engineer“ vorgestellt, ein innovatives KI-System zur automatisierten Erstellung hochoptimierter CUDA-Kernels. Dies führt zu einer deutlichen Steigerung der Effizienz von Machine-Learning-Operationen. Laut aktuellen Meldungen auf X beschleunigt das System, angetrieben von einem evolutionären Large Language Model (LLM) zur Codeoptimierung, gängige PyTorch-Operationen um das 10- bis 100-fache. Dies stellt einen bedeutenden Durchbruch in der GPU-Performance-Optimierung dar.

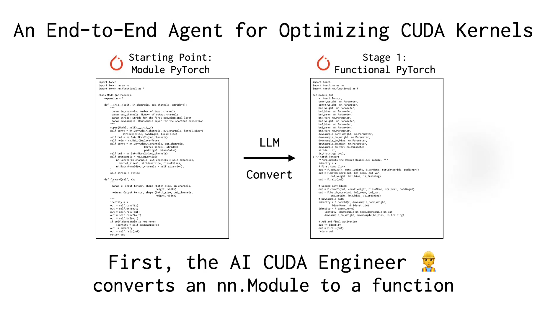

Sakana AI erklärt, dass das Schreiben und Optimieren von CUDA-Kernels, dem Kern der GPU-Berechnung, normalerweise tiefgreifende Fachkenntnisse und hohe technische Anforderungen erfordert. Vorhandene Frameworks wie PyTorch sind zwar benutzerfreundlich, erreichen aber in puncto Leistung oft nicht die Effizienz manuell optimierter Kernels. Der „AI CUDA Engineer“ löst dieses Problem durch einen intelligenten Workflow: Er wandelt PyTorch-Code nicht nur automatisch in effiziente CUDA-Kernels um, sondern optimiert die Leistung auch mithilfe von Evolutionsalgorithmen und kann sogar mehrere Kernels kombinieren, um die Laufzeiteffizienz weiter zu steigern.

Der X-Nutzer @shao__meng vergleicht die Technologie mit einem „Automatikgetriebe für die KI-Entwicklung“, das es ermöglicht, normalen Code „automatisch auf Rennwagen-Performance zu upgraden“. Ein anderer Nutzer, @FinanceYF5, hebt in seinem Beitrag das Potenzial der KI-Selbstoptimierung hervor und sieht darin eine revolutionäre Verbesserung der zukünftigen Nutzung von Rechenressourcen.

Sakana AI hat sich bereits mit Projekten wie „AI Scientist“ einen Namen gemacht. Die Veröffentlichung des „AI CUDA Engineers“ unterstreicht den Ehrgeiz des Unternehmens im Bereich der KI-Automatisierung. Das Unternehmen behauptet, über 17.000 CUDA-Kernels für verschiedene PyTorch-Operationen erfolgreich generiert und verifiziert zu haben. Der öffentlich zugängliche Datensatz soll Forschern und Entwicklern wertvolle Ressourcen bieten. Branchenexperten sind der Meinung, dass diese Technologie nicht nur die Anforderungen an die Hochleistungs-GPU-Programmierung senkt, sondern auch die Effizienz beim Training und der Bereitstellung von KI-Modellen deutlich verbessern könnte.

Informationsquelle: https://x.com/FinanceYF5/status/1892856847780237318