Im Bereich der multimodalen Künstlichen Intelligenz haben das ZHIYUAN-Institut und mehrere Universitäten das neue multimodale Vektormodell BGE-VL vorgestellt, welches einen bedeutenden Durchbruch in der multimodalen Suchtechnologie darstellt. Seit seiner Veröffentlichung hat die BGE-Modellreihe großes Lob erhalten, und BGE-VL erweitert dieses Ökosystem weiter. Das Modell zeigt in verschiedenen wichtigen Aufgaben wie Bild-Text-Suche und kombinierter Bildsuche herausragende Leistungen.

Der Erfolg von BGE-VL ist seiner zugrundeliegenden MegaPairs-Daten-Synthesetechnik zu verdanken. Diese innovative Methode generiert durch die Auswertung bestehender umfangreicher Bild-Text-Daten automatisch hochwertige multimodale Triplet-Daten und verbessert so die Skalierbarkeit und Qualität der Daten erheblich. MegaPairs kann mit sehr geringen Kosten diverse Datensätze generieren und umfasst über 26 Millionen Beispiele, die eine solide Grundlage für das Training von multimodalen Suchmodellen bieten. Diese Technologie hat BGE-VL zu Spitzenleistungen in mehreren gängigen Benchmarks für multimodale Suche verholfen.

In Zeiten, in denen die multimodale Suche immer wichtiger wird, steigt der Bedarf der Nutzer an vielfältigen Informationsquellen. Bisherige Suchmodelle basierten meist auf einzelnen Bild-Text-Paaren und konnten komplexe kombinierte Eingaben nicht effektiv verarbeiten. BGE-VL umgeht diese Einschränkung durch die Integration von MegaPairs-Daten, sodass das Modell multimodale Suchanfragen umfassender verstehen und verarbeiten kann.

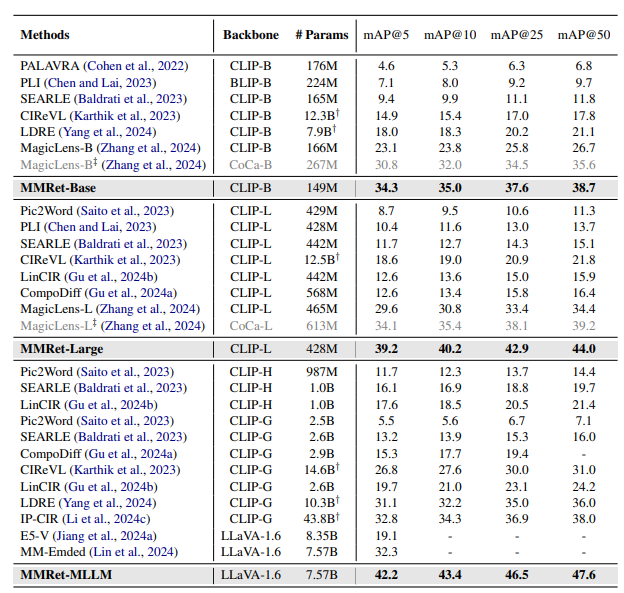

Die ZHIYUAN-Gruppe stellte bei der Leistungsmessung in verschiedenen Aufgaben fest, dass das BGE-VL-Modell eine hervorragende Null-Schuss-Leistung im Massive Multimodal Embedding Benchmark (MMEB) aufweist. Obwohl MegaPairs die meisten Aufgaben in MMEB nicht abdeckt, ist seine Fähigkeit zur Aufgabenverallgemeinerung beeindruckend. Auch bei der Bewertung der kombinierten Bildsuche zeigte BGE-VL herausragende Ergebnisse und übertraf deutlich viele bekannte Modelle wie Googles MagicLens und Nvidias MM-Embed.

Zukünftig plant das ZHIYUAN-Institut, die MegaPairs-Technologie weiterzuentwickeln, sie mit reichhaltigeren Szenarien der multimodalen Suche zu kombinieren und einen umfassenderen und effizienteren multimodalen Sucher zu entwickeln, um den Nutzern präzisere Informationsdienste zu bieten. Mit der Weiterentwicklung der multimodalen Technologie wird die Einführung von BGE-VL die weitere Erforschung und Innovation in diesem Bereich zweifellos vorantreiben.

论文地址:https://arxiv.org/abs/2412.14475

项目主页:https://github.com/VectorSpaceLab/MegaPairs

模型地址:https://huggingface.co/BAAI/BGE-VL-MLLM-S1