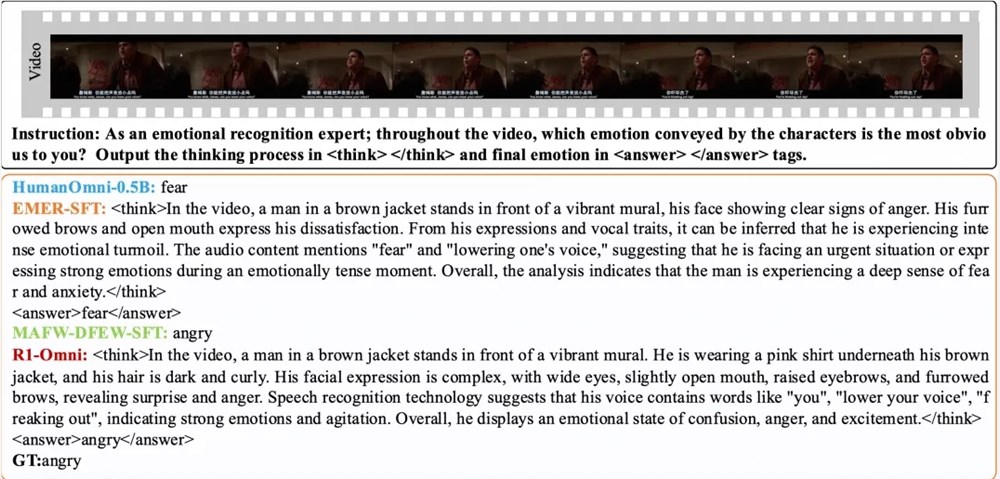

Am 11. März gab das Tongyi-Labor-Team die Open-Source-Veröffentlichung des R1-Omni-Modells bekannt, das einen neuen Durchbruch in der Entwicklung von multimodalen Modellen darstellt. Das Modell kombiniert Reinforcement Learning mit verifizierbaren Belohnungen (RLVR) und konzentriert sich auf die Verbesserung der Inferenzfähigkeit und der Generalisierungsleistung bei multimodalen Emotionserkennungsaufgaben.

Das Training von R1-Omni erfolgt in zwei Phasen. In der Kaltstartphase wird das Modell mit einem kombinierten Datensatz von 580 Videos feinabgestimmt, die aus dem Explainable Multimodal Emotion Reasoning (EMER) Datensatz und dem HumanOmni Datensatz stammen. Diese Phase dient dazu, grundlegende Inferenzfähigkeiten zu schaffen und sicherzustellen, dass das Modell vor dem Eintritt in die RLVR-Phase über eine gewisse Fähigkeit zur multimodalen Emotionserkennung verfügt, um die Stabilität, Effizienz und Zuverlässigkeit des nachfolgenden Trainings zu gewährleisten.

Anschließend wird das Modell in der RLVR-Phase durch Reinforcement Learning und einen Mechanismus verifizierbarer Belohnungen weiter optimiert. Der Schlüssel dieser Phase liegt im Policy-Modell und der Belohnungsfunktion. Das Policy-Modell verarbeitet multimodale Eingabedaten, bestehend aus Videobildern und Audioströmen, und generiert Kandidatenantworten mit detaillierten Inferenzprozessen, die zeigen, wie das Modell visuelle und auditive Informationen integriert, um Vorhersagen zu treffen. Die Belohnungsfunktion, inspiriert von DeepSeek R1, besteht aus Präzisionsbelohnung und Formatbelohnung, die zusammen die endgültige Belohnung bilden und das Modell sowohl zur Generierung korrekter Vorhersagen als auch zur Sicherstellung einer strukturierten und dem vorgegebenen Format entsprechenden Ausgabe anregen.

Die Ergebnisse zeigen, dass R1-Omni auf den Testdatensätzen DFEW und MAFW im Vergleich zum ursprünglichen Baseline-Modell eine durchschnittliche Verbesserung von über 35 % und im Vergleich zum Modell mit überwachtem Feintuning (SFT) eine Verbesserung des ungewichteten durchschnittlichen Rückrufs (UAR) von über 10 % aufweist. Auf dem Testdatensatz RAVDESS mit unterschiedlicher Verteilung verbessert sich der gewichtete durchschnittliche Rückruf (WAR) und der UAR um über 13 %, was eine hervorragende Generalisierungsfähigkeit zeigt. Darüber hinaus zeichnet sich R1-Omni durch eine deutlich verbesserte Transparenz aus. Durch die RLVR-Methode wird die Rolle von Audio- und Videoinformationen im Modell klarer und es lässt sich deutlich zeigen, welche modale Information für die Beurteilung bestimmter Emotionen entscheidend ist. Dies liefert wichtige Erkenntnisse für das Verständnis des Modellentscheidungsprozesses und zukünftige Forschung.

Paper:

https://arxiv.org/abs/2503.05379

Github:

https://github.com/HumanMLLM/R1-Omni

Modell:

https://www.modelscope.cn/models/iic/R1-Omni-0.5B